SpringCloud

Mybatis-Plus

MyBatis-Plus 🚀 为简化开发而生 (baomidou.com)

擅长单表操作

使用步骤

导入依赖

MybatisPlus提供了starter,实现了自动Mybatis以及MybatisPlus的自动装配功能

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus-boot-starter</artifactId>

<version>3.5.3.1</version>

</dependency>原来的Mapper继承BaseMapper

❗️需要指定泛型

public interface UserMapper 🚩 extends BaseMapper<User>{

}修改原来的方法

@SpringBootTest

class UserMapperTest {

@Autowired

private UserMapper userMapper;

@Test

void testInsert() {

User user = new User();

user.setId(5L);

user.setUsername("Lucy");

user.setPassword("123");

user.setPhone("18688990011");

user.setBalance(200);

user.setInfo("{\"age\": 24, \"intro\": \"英文老师\", \"gender\": \"female\"}");

user.setCreateTime(LocalDateTime.now());

user.setUpdateTime(LocalDateTime.now());

-userMapper.saveUser(user);

+userMapper.insert(user);

}

@Test

void testSelectById() {

-User user = userMapper.queryUserById(5L);

+User user = userMapper.selectById(5L);

System.out.println("user = " + user);

}

@Test

void testQueryByIds() {

-List<User> users = userMapper.queryUserByIds(List.of(1L, 2L, 3L, 4L));

+List<User> users = userMapper.selectBatchIds(List.of(1L, 2L, 3L, 4L));

users.forEach(System.out::println);

}

@Test

void testUpdateById() {

User user = new User();

user.setId(5L);

user.setBalance(20000);

-userMapper.updateUser(user);

+userMapper.updateById(user)

}

@Test

void testDeleteUser() {

-userMapper.deleteUser(5L);

+userMapper.deleteById(5L);

}

}常见注解

MybatisPlus如何知道要查询的是哪张表?表中有哪些字段呢?

MyBatisPlus通过扫描实体类,并基于反射获取实体类信息作为数据库表信息。

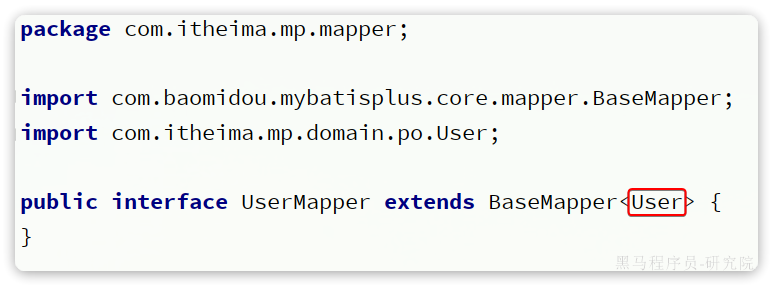

大家回忆一下,UserMapper在继承BaseMapper的时候指定了一个泛型:

泛型中的User就是与数据库对应的PO.

MybatisPlus就是根据PO实体的信息来推断出表的信息,从而生成SQL的。默认情况下:

- MybatisPlus会把PO实体的类名驼峰转下划线作为表名

- MybatisPlus会把PO实体的所有变量名驼峰转下划线作为表的字段名,并根据变量类型推断字段类型

- MybatisPlus会把名为id的字段作为主键

但很多情况下,默认的实现与实际场景不符,因此MybatisPlus提供了一些注解便于声明表信息。

@TableName

- 描述:表名注解,标识实体类对应的表

- 使用位置:实体类

@TableName("user")

public class User {

private Long id;

private String name;

}| 属性 | 类型 | 必须指定 | 默认值 | 描述 |

|---|---|---|---|---|

| value | String | 否 | "" | 表名 |

| schema | String | 否 | "" | schema |

| keepGlobalPrefix | boolean | 否 | false | 是否保持使用全局的 tablePrefix 的值(当全局 tablePrefix 生效时) |

| resultMap | String | 否 | "" | xml 中 resultMap 的 id(用于满足特定类型的实体类对象绑定) |

| autoResultMap | boolean | 否 | false | 是否自动构建 resultMap 并使用(如果设置 resultMap 则不会进行 resultMap 的自动构建与注入) |

| excludeProperty | String[] | 否 | {} | 需要排除的属性名 @since 3.3.1 |

@TableId

- 描述:主键注解,标识实体类中的主键字段

- 使用位置:实体类的主键字段

@TableName("user")

public class User {

@TableId(type = IdType.AUTO)

private Long id;

private String name;

}TableId注解支持两个属性:

| 属性 | 类型 | 必须指定 | 默认值 | 描述 |

|---|---|---|---|---|

| value | String | 否 | "" | 表名 |

| type | Enum | 否 | IdType.NONE | 指定主键类型 |

IdType支持的类型有:

| 值 | 描述 |

|---|---|

| AUTO | 数据库 ID 自增 |

| NONE | 无状态,该类型为未设置主键类型(注解里等于跟随全局,全局里约等于 INPUT) |

| INPUT | insert 前自行 set 主键值 |

| ASSIGN_ID | 分配 ID(主键类型为 Number(Long 和 Integer)或 String)(since 3.3.0),使用接口IdentifierGenerator的方法nextId(默认实现类为DefaultIdentifierGenerator雪花算法) |

| ASSIGN_UUID | 分配 UUID,主键类型为 String(since 3.3.0),使用接口IdentifierGenerator的方法nextUUID(默认 default 方法) |

| ID_WORKER | 分布式全局唯一 ID 长整型类型(please use ASSIGN_ID) |

| UUID | 32 位 UUID 字符串(please use ASSIGN_UUID) |

| ID_WORKER_STR | 分布式全局唯一 ID 字符串类型(please use ASSIGN_ID) |

这里比较常见的有三种:

AUTO:利用数据库的id自增长INPUT:手动生成idASSIGN_ID:雪花算法生成Long类型的全局唯一id,这是默认的ID策略- 不指定,默认❄️算法

@TableField

描述:普通字段注解

@TableName("user")

public class User {

@TableId

private Long id;

private String name;

private Integer age;

@TableField("isMarried")

private Boolean isMarried;

@TableField("concat")

private String concat;

}一般情况下并不需要给字段添加@TableField注解,一些特殊情况除外:

- 成员变量名与数据库字段名不一致

- 成员变量是以

isXXX命名,按照JavaBean的规范,MybatisPlus识别字段时会把is去除,这就导致与数据库不符。 - 成员变量名与数据库一致,但是与数据库的关键字冲突。使用

@TableField注解给字段名添加转义字符:``

支持的其它属性如下:

| 属性 | 类型 | 必填 | 默认值 | 描述 |

|---|---|---|---|---|

| value | String | 否 | "" | 数据库字段名 |

| exist | boolean | 否 | true | 是否为数据库表字段 |

| condition | String | 否 | "" | 字段 where 实体查询比较条件,有值设置则按设置的值为准,没有则为默认全局的 %s=#{%s},参考(opens new window) |

| update | String | 否 | "" | 字段 update set 部分注入,例如:当在version字段上注解update="%s+1" 表示更新时会 set version=version+1 (该属性优先级高于 el 属性) |

| insertStrategy | Enum | 否 | FieldStrategy.DEFAULT | 举例:NOT_NULL insert into table_a() values () |

| updateStrategy | Enum | 否 | FieldStrategy.DEFAULT | 举例:IGNORED update table_a set column=# |

| whereStrategy | Enum | 否 | FieldStrategy.DEFAULT | 举例:NOT_EMPTY where |

| fill | Enum | 否 | FieldFill.DEFAULT | 字段自动填充策略 |

| select | boolean | 否 | true | 是否进行 select 查询 |

| keepGlobalFormat | boolean | 否 | false | 是否保持使用全局的 format 进行处理 |

| jdbcType | JdbcType | 否 | JdbcType.UNDEFINED | JDBC 类型 (该默认值不代表会按照该值生效) |

| typeHandler | TypeHander | 否 | 类型处理器 (该默认值不代表会按照该值生效) | |

| numericScale | String | 否 | "" | 指定小数点后保留的位数 |

常见配置

配置 | MyBatis-Plus (baomidou.com)

大多数的配置都有默认值,因此都无需配置。但还有一些是没有默认值的,例如:

- 实体类的别名扫描包

- 全局id类型

mybatis-plus:

type-aliases-package: com.itheima.mp.domain.po

global-config:

db-config:

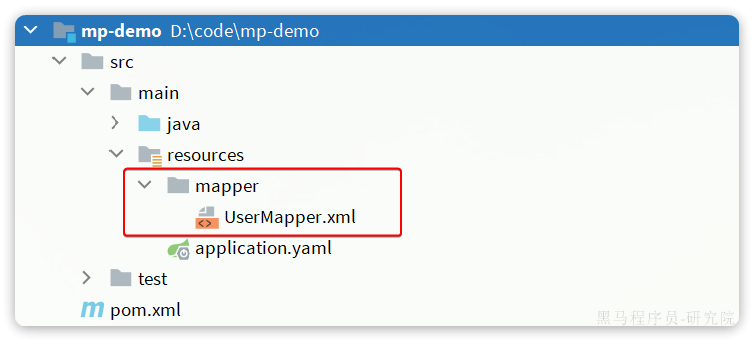

id-type: auto # 全局id类型为自增长需要注意的是,MyBatisPlus也支持手写SQL的,而mapper文件的读取地址可以自己配置:

mybatis-plus:

mapper-locations: "classpath*:/mapper/**/*.xml" # Mapper.xml文件地址,当前这个是默认值。可以看到默认值是classpath*:/mapper/**/*.xml,也就是说只要把mapper.xml文件放置这个目录下就一定会被加载。

例如,新建一个UserMapper.xml文件:

然后在其中定义一个方法:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.itheima.mp.mapper.UserMapper">

<select id="queryById" resultType="User">

SELECT * FROM user WHERE id = #{id}

</select>

</mapper>然后在测试类UserMapperTest中测试该方法:

@Test

void testQuery() {

User user = userMapper.queryById(1L);

System.out.println("user = " + user);

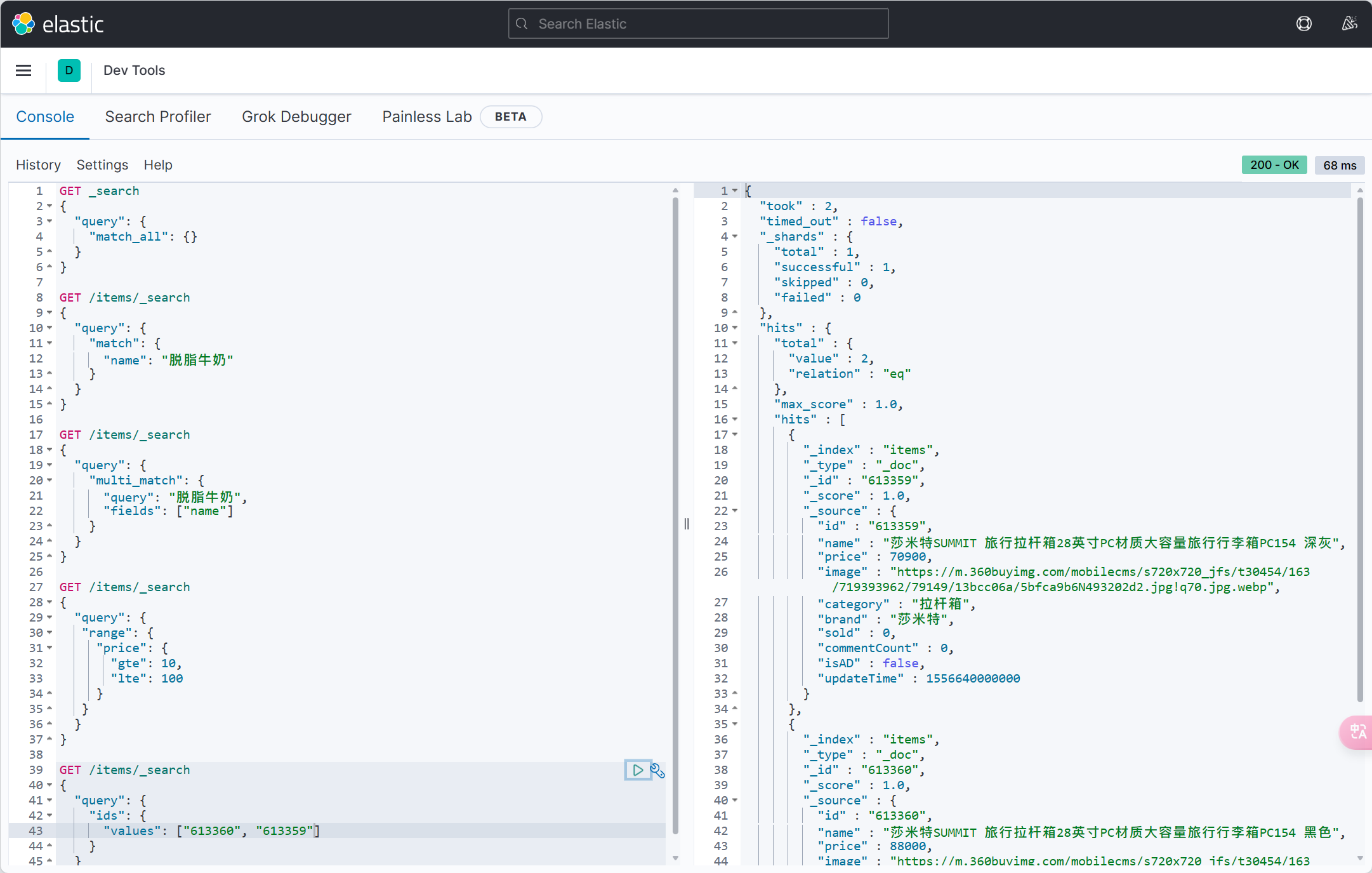

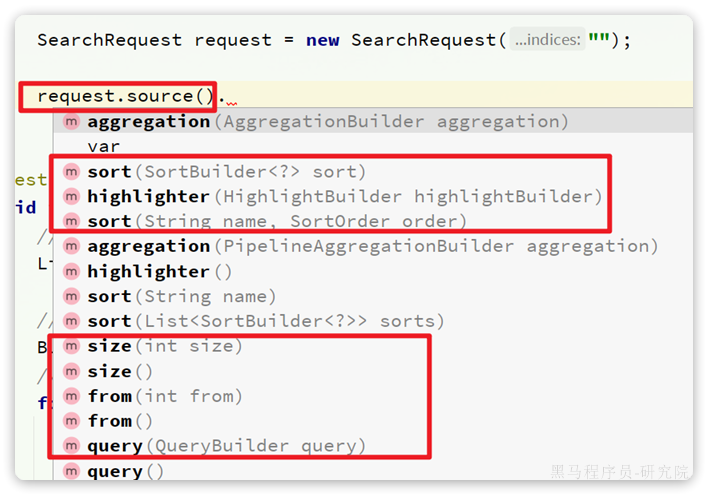

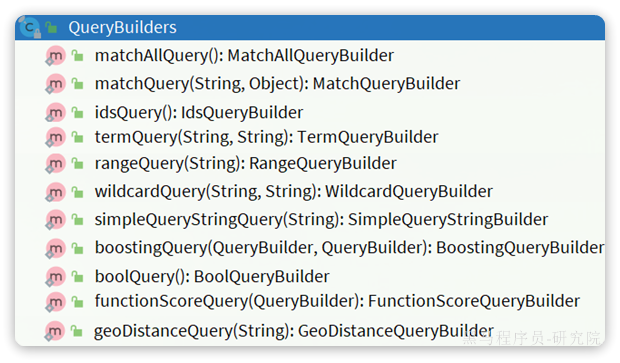

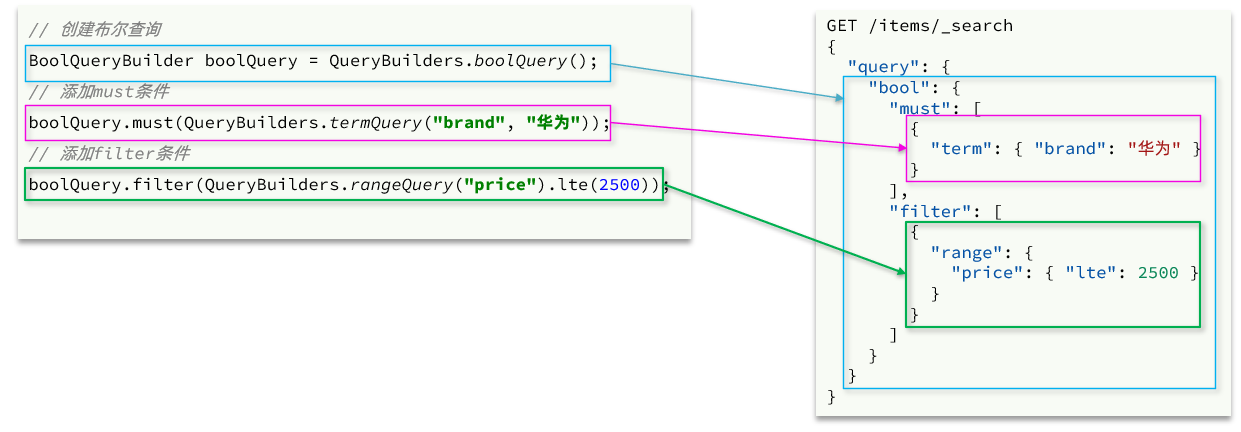

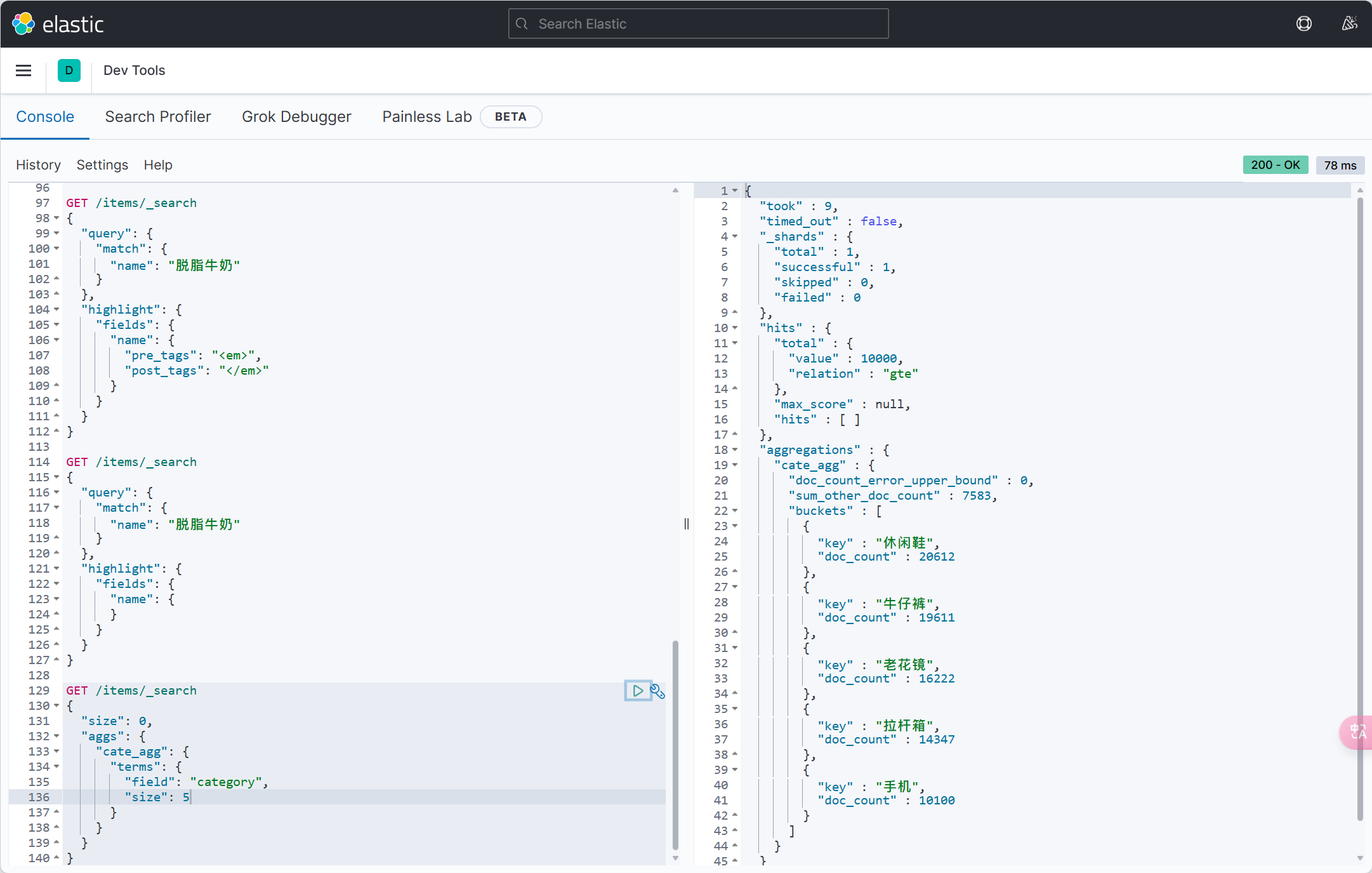

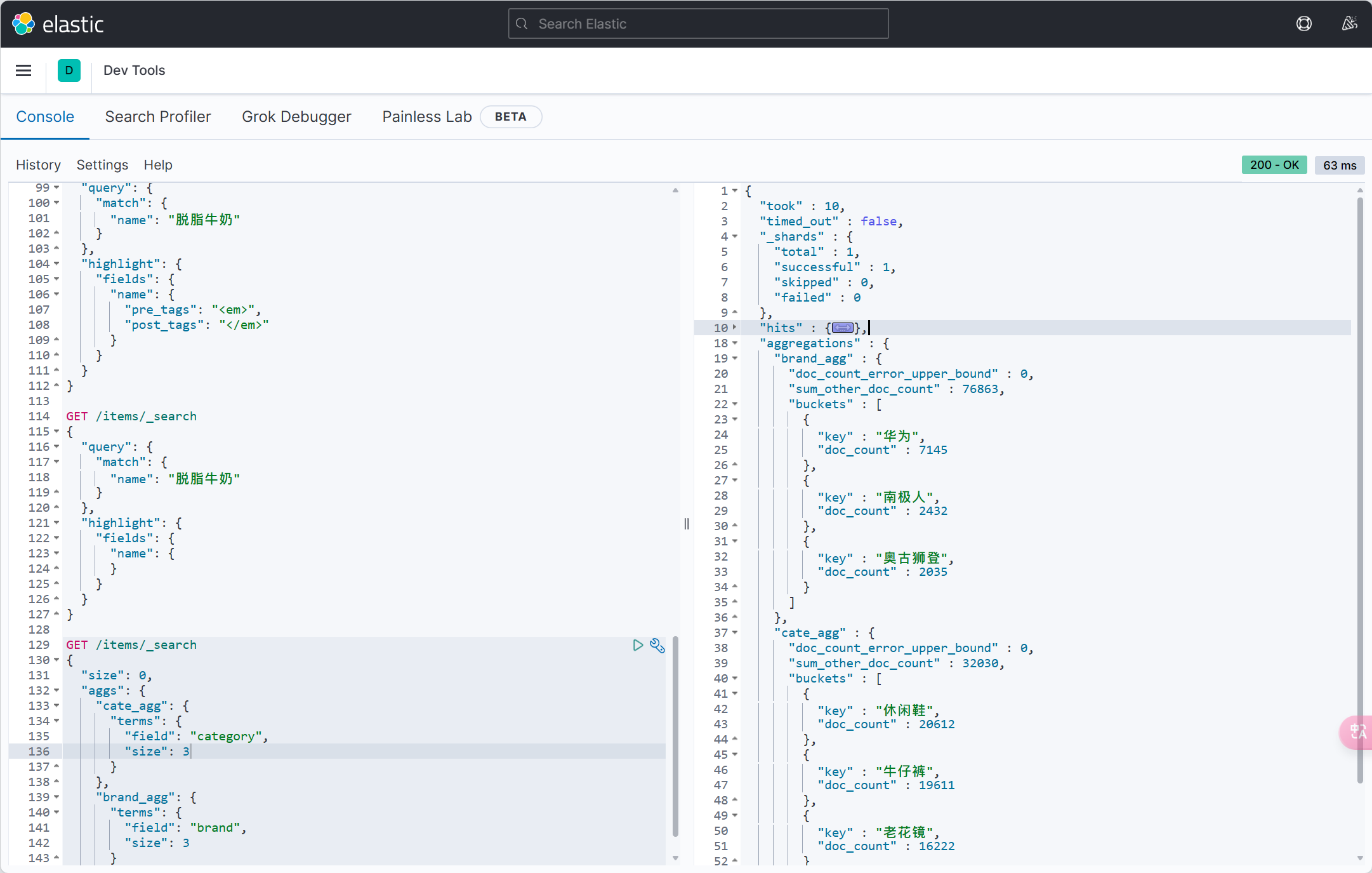

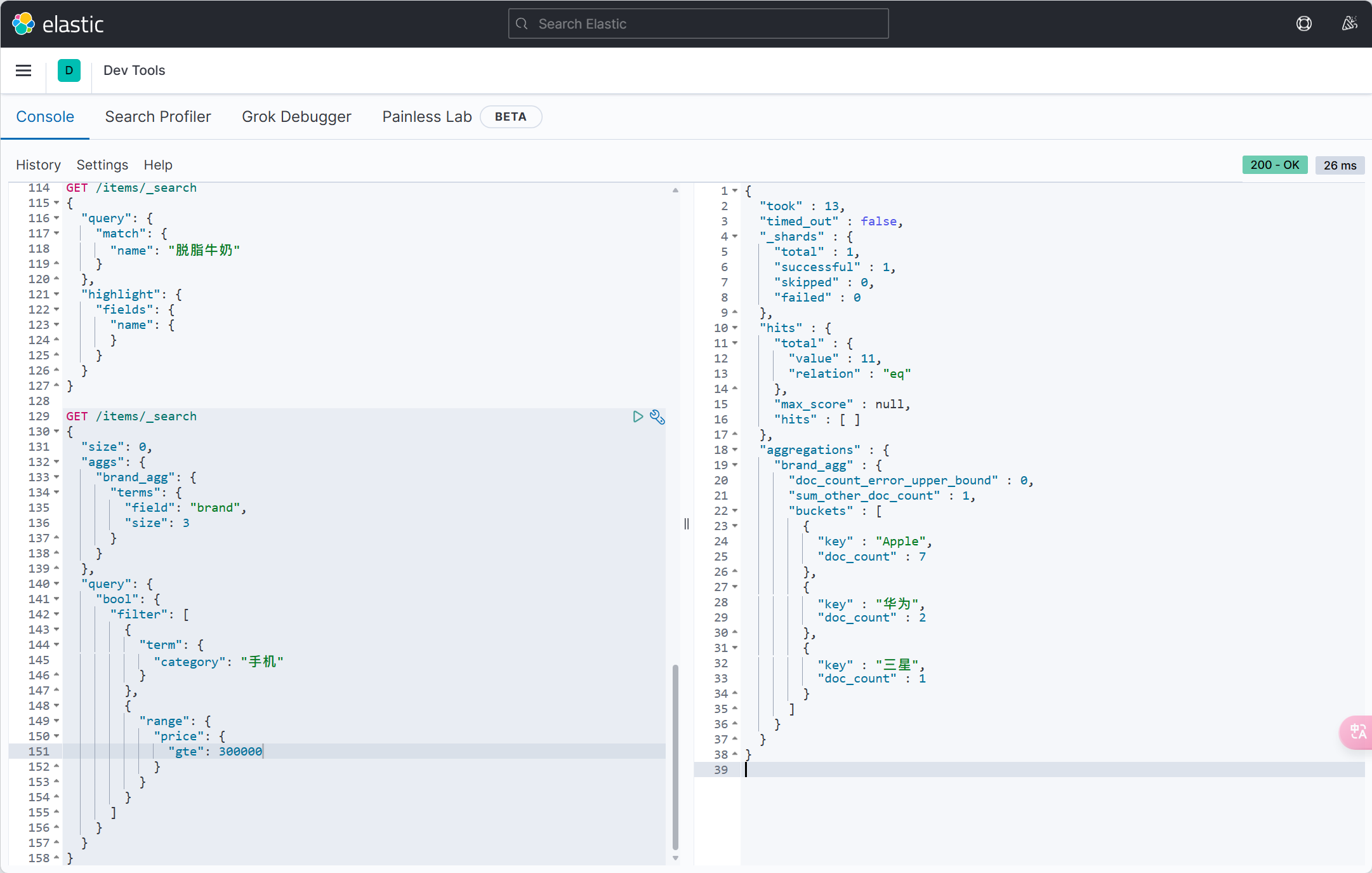

}条件构造器

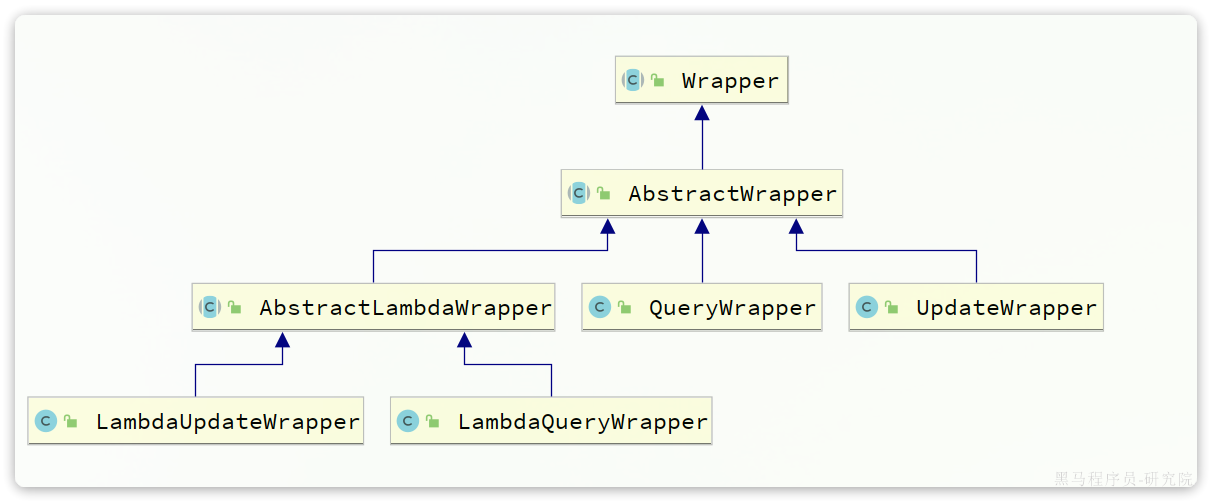

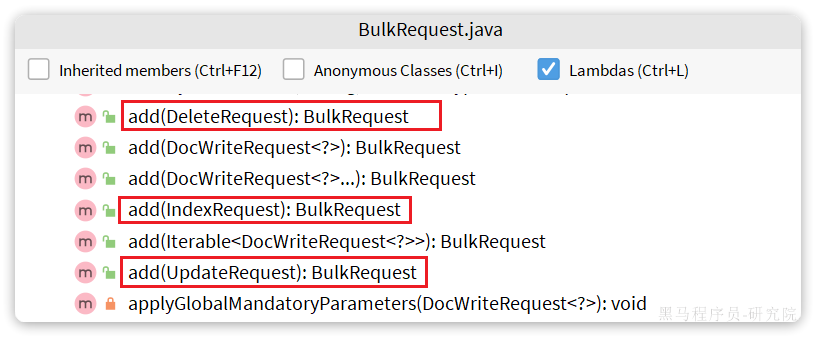

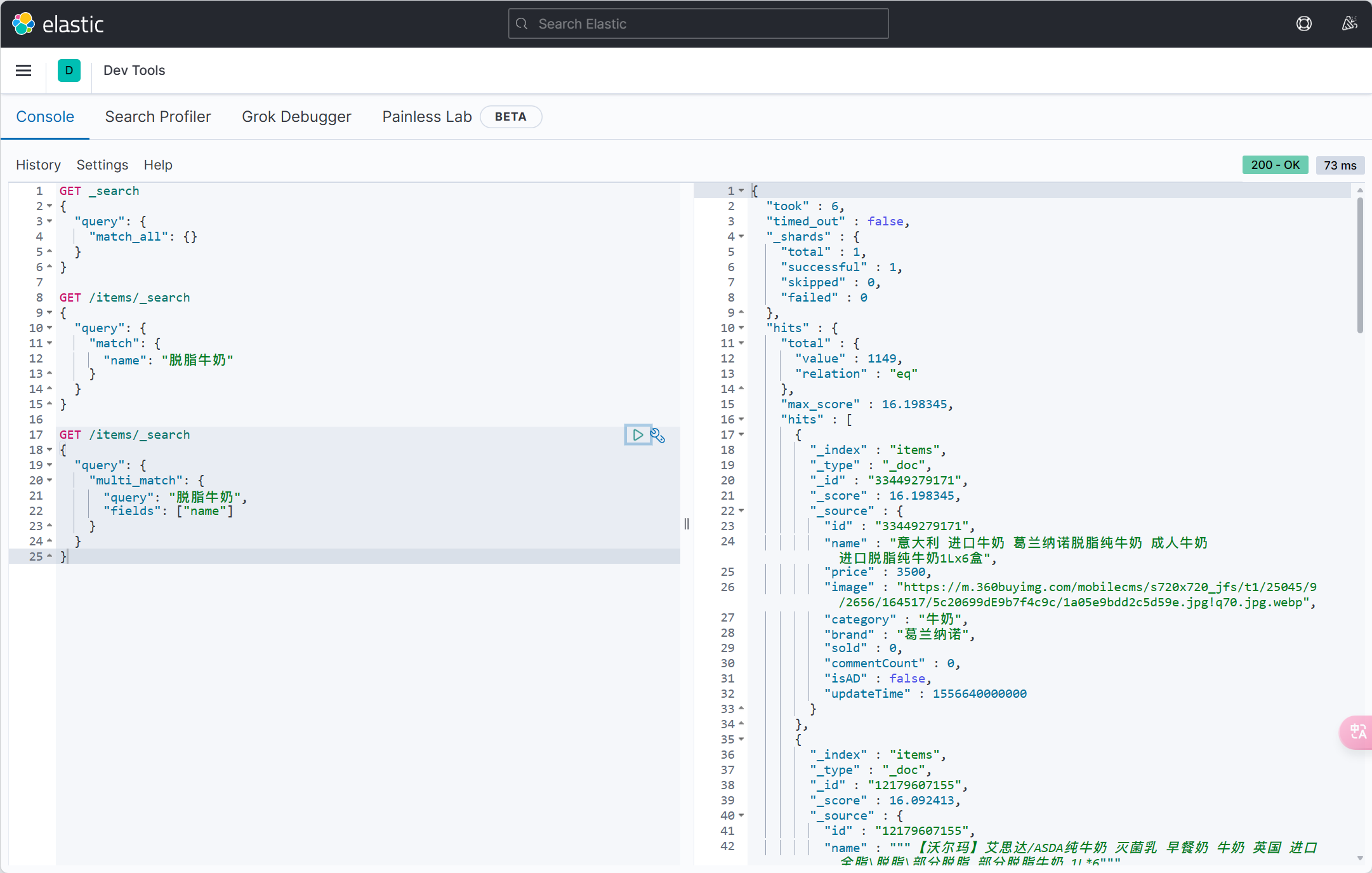

Wrapper

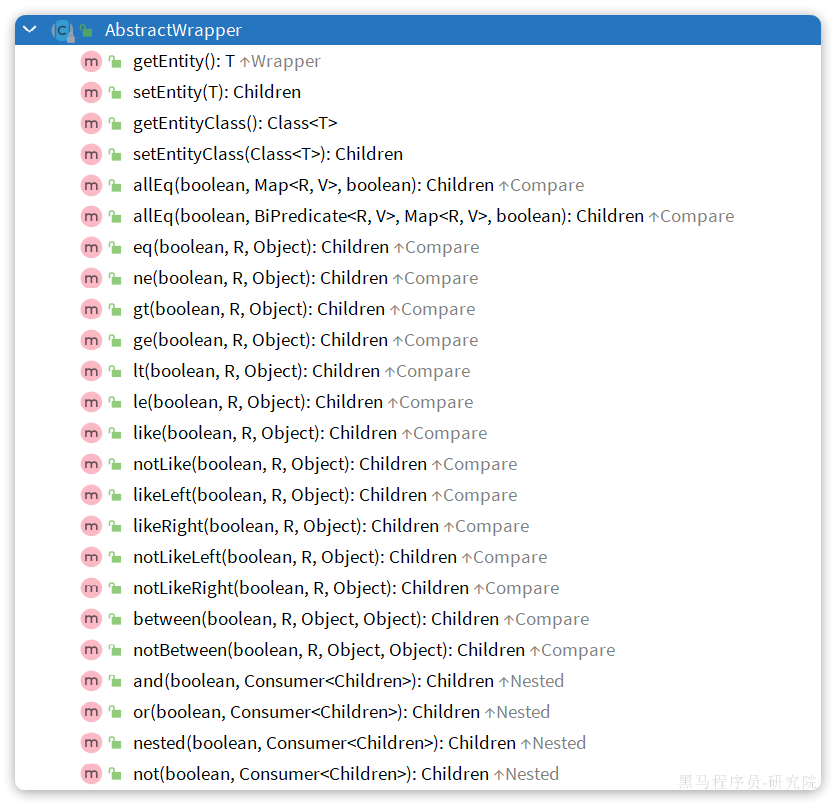

参数中的Wrapper就是条件构造的抽象类,其下有很多默认实现,继承关系如图:

Wrapper的子类AbstractWrapper提供了where中包含的所有条件构造方法:

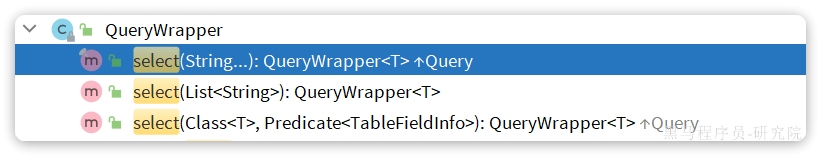

而QueryWrapper在AbstractWrapper的基础上拓展了一个select方法,允许指定查询字段:

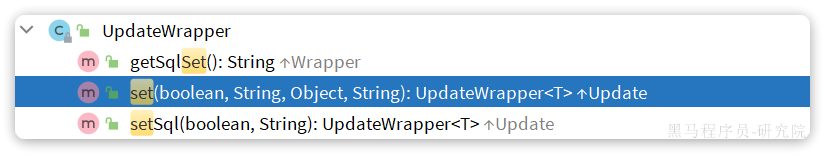

而UpdateWrapper在AbstractWrapper的基础上拓展了一个set方法,允许指定SQL中的SET部分:

@Test

void testQueryWrapper() {

QueryWrapper<User> wrapper = new QueryWrapper<User>()

.select("id", "username", "info", "balance")

.like("username", "o")

.gt("balance", 1000);

List<User> users = userMapper.selectList(wrapper);

users.forEach(System.out::println);

} @Test

void testUpdateByQueryWrapper(){

User user = new User();

user.setBalance(2000);

QueryWrapper<User> wrapper = new QueryWrapper<User>()

.eq("username", "jack");

int update = userMapper.update(user, wrapper);

System.out.println(update);

}

@Test

void testUpdateWrapper1(){

UpdateWrapper<User> wrapper = new UpdateWrapper<User>()

.set("balance", 2000)

.eq("username", "jack");

int update = userMapper.update(null, wrapper);

System.out.println(update);

} @Test

void testUpdateWrapper2(){

List<Long> ids = List.of(1L, 2L, 4L);

UpdateWrapper<User> wrapper = new UpdateWrapper<User>()

.setSql("balance = balance - 200")

.in("id", 1, 2, 4);

// .in("id", ids);

int update = userMapper.update(null, wrapper);

System.out.println(update);

}LambdaWrapper减少硬编码,推荐使用

@Test

void testLambdaQueryWrapper(){

LambdaQueryWrapper<User> wrapper = new LambdaQueryWrapper<User>()

.select(User::getId, User::getUsername, User::getInfo, User::getBalance)

.like(User::getUsername, "o")

.ge(User::getBalance, 800);

List<User> users = userMapper.selectList(wrapper);

users.forEach(System.out::println);

}WARNING: An illegal reflective access operation has occurred

WARNING: Illegal reflective access by com.baomidou.mybatisplus.core.toolkit.SetAccessibleAction (file:/E:/MySoftware/apache-maven-3.9.6/local%20repository/com/baomidou/mybatis-plus-core/3.5.3.1/mybatis-plus-core-3.5.3.1.jar) to field java.lang.invoke.SerializedLambda.capturingClass

WARNING: Please consider reporting this to the maintainers of com.baomidou.mybatisplus.core.toolkit.SetAccessibleAction

WARNING: Use --illegal-access=warn to enable warnings of further illegal reflective access operations

WARNING: All illegal access operations will be denied in a future release

13:54:06 INFO 35160 --- [ main] com.zaxxer.hikari.HikariDataSource : HikariPool-1 - Starting...

13:54:07 INFO 35160 --- [ main] com.zaxxer.hikari.HikariDataSource : HikariPool-1 - Start completed.

13:54:07 DEBUG 35160 --- [ main] c.i.mp.mapper.UserMapper.selectList : ==> Preparing: SELECT id,username,info,balance FROM user WHERE (username LIKE ? AND balance >= ?)

13:54:07 DEBUG 35160 --- [ main] c.i.mp.mapper.UserMapper.selectList : ==> Parameters: %o%(String), 800(Integer)

13:54:07 DEBUG 35160 --- [ main] c.i.mp.mapper.UserMapper.selectList : <== Total: 1

User(id=3, username=Hope, password=null, phone=null, info={"age": 25, "intro": "上进青年", "gender": "male"}, status=null, balance=100000, createTime=null, updateTime=null)自定义SQL

在某些企业也是不允许在业务层写SQL,因为SQL语句最好都维护在持久层,而不是业务层。

可以利用MyBatisPlus的Wrapper来构建复杂的Where条件,然后自己定义SQL语句中剩下的部分。

基于Wrapper构建where条件

List<Long> ids = List.of(1L, 2L, 4L);

int amount = 200;

LambdaQueryWrapper<User> wrapper = new LambdaQueryWrapper<User>()

.in(User::getId, ids);在mapper方法参数中用Param注解声明wrapper变量名称,❗️必须是ew

userMapper.updateBalanceByIds(wrapper, amount);自定义SQL,并使用Wrapper条件

public interface UserMapper extends BaseMapper<User> {

void updateBalanceByIds(@Param("ew") LambdaQueryWrapper<User> wrapper, @Param("amount") int amount);

}<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.itheima.mp.mapper.UserMapper">

<update id="updateBalanceByIds">

update user set balance = balance - #{amount} ${ew.customSqlSegment}

</update>

</mapper> @Test

void testCustomSqlUpdate(){

List<Long> ids = List.of(1L, 2L, 4L);

int amount = 200;

LambdaQueryWrapper<User> wrapper = new LambdaQueryWrapper<User>()

.in(User::getId, ids);

userMapper.updateBalanceByIds(wrapper, amount);

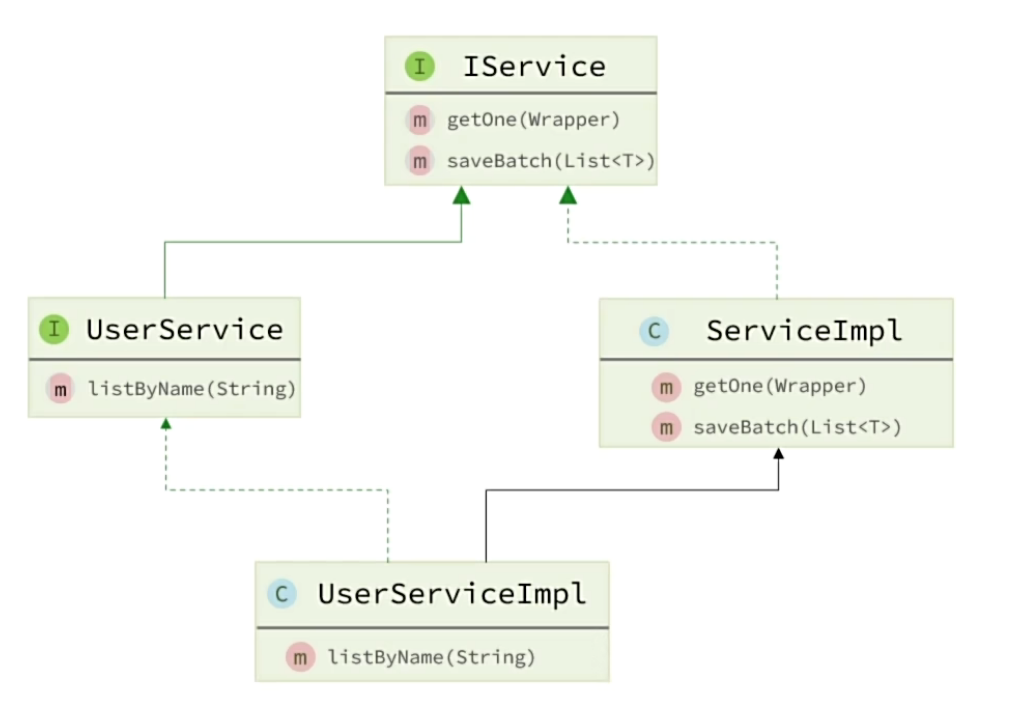

}IService接口

MybatisPlus不仅提供了BaseMapper,还提供了通用的Service接口及默认实现,封装了一些常用的service模板方法。 通用接口为IService,默认实现为ServiceImpl,其中封装的方法可以分为以下几类:

save:新增remove:删除update:更新get:查询单个结果list:查询集合结果count:计数page:分页查询

使用步骤

分别继承接口和实现类

接口

public interface IUserService extends IService<User> {

}实现类

@Service

public class IUserServiceImpl extends ServiceImpl<UserMapper, User> implements IUserService {

}测试

@SpringBootTest

class IUserServiceTest {

@Resource

private IUserService userService;

@Test

void testSaveUser(){

User user = new User();

user.setUsername("test");

user.setPassword("123456");

user.setPhone("11111111111");

user.setBalance(200);

user.setInfo("{\"age\": 24, \"intro\": \"英文老师\", \"gender\": \"female\"}");

userService.save(user);

}

}

开发基础业务接口

| 编号 | 接口 | 请求方式 | 请求路径 | 请求参数 | 返回值 |

|---|---|---|---|---|---|

| 1 | 新增用户 | POST | /users | 用户表单实体 | 无 |

| 2 | 删除用户 | DELETE | /users/ | 用户id | 无 |

| 3 | 根据id查询用户 | GET | /users/ | 用户id | 用户VO |

| 4 | 根据id批量查询 | GET | /users | 用户id集合 | 用户VO集合 |

引入Swagger和web依赖

<!--swagger-->

<dependency>

<groupId>com.github.xiaoymin</groupId>

<artifactId>knife4j-openapi2-spring-boot-starter</artifactId>

<version>4.1.0</version>

</dependency>

<!--web-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>修改配置文件

spring:

datasource:

url: jdbc:mysql://127.0.0.1:3306/mp?useUnicode=true&characterEncoding=UTF-8&autoReconnect=true&serverTimezone=Asia/Shanghai

driver-class-name: com.mysql.cj.jdbc.Driver

username: cdd

password: 1

logging:

level:

com.itheima: debug

pattern:

dateformat: HH:mm:ss

mybatis-plus:

type-aliases-package: com.itheima.mp.domain.po

global-config:

db-config:

id-type: auto # 全局id类型为自增长

mapper-locations: "classpath*:/mapper/**/*.xml" # Mapper.xml文件地址,当前这个是默认值。

knife4j:

enable: true

openapi:

title: 用户管理接口文档

description: "用户管理接口文档"

email: [email protected]

concat: CharmingDaiDai

version: v1.0.0

group:

default:

group-name: default

api-rule: package

api-rule-resources:

- com.itheima.mp.controller创建VO和DTO实体类

创建UserController

package com.itheima.mp.controller;

import cn.hutool.core.bean.BeanUtil;

import com.itheima.mp.domain.dto.UserFormDTO;

import com.itheima.mp.domain.po.User;

import com.itheima.mp.domain.vo.UserVO;

import com.itheima.mp.service.IUserService;

import io.swagger.annotations.Api;

import io.swagger.annotations.ApiOperation;

import io.swagger.annotations.ApiParam;

import lombok.extern.slf4j.Slf4j;

import org.apache.ibatis.annotations.Param;

import org.springframework.web.bind.annotation.*;

import javax.annotation.Resource;

import java.util.ArrayList;

import java.util.List;

/**

* @Author:CharmingDaiDai

* @Project:mp-demo

* @Date:2024/5/17 下午3:51

*/

@RestController

@Api(tags = "用户管理")

@RequestMapping("/users")

@Slf4j

public class UserController {

@Resource

private IUserService iUserService;

@ApiOperation(value = "新增用户")

@PostMapping

public void saveUser(@RequestBody UserFormDTO userDTO){

User user = BeanUtil.copyProperties(userDTO, User.class);

iUserService.save(user);

}

@ApiOperation(value = "删除用户")

@DeleteMapping("/{id}")

public void deleteUser(@ApiParam("用户id") @PathVariable Long id){

iUserService.removeById(id);

}

@ApiOperation(value = "根据id查询用户")

@GetMapping("/{id}")

public UserVO getById(@PathVariable Long id){

User user = iUserService.getById(id);

return BeanUtil.copyProperties(user, UserVO.class);

}

@ApiOperation(value = "根据id批量查询")

@GetMapping("/users")

public List<UserVO> getByIds(@RequestParam("ids") List<Long> ids){

List<User> users = iUserService.listByIds(ids);

return BeanUtil.copyToList(users, UserVO.class);

}

}开发复杂业务接口

一些带有业务逻辑的接口则需要在service中自定义实现了。例如下面的需求:

- 根据id扣减用户余额

这看起来是个简单修改功能,只要修改用户余额即可。但这个业务包含一些业务逻辑处理:

- 判断用户状态是否正常

- 判断用户余额是否充足

这些业务逻辑都要在service层来做,另外更新余额需要自定义SQL,要在mapper中来实现。因此,除了要编写controller以外,具体的业务还要在service和mapper中编写。

UserController

@PutMapping("{id}/deduction/{money}")

@ApiOperation("扣减用户余额")

public String deductBalance(@PathVariable("id") Long id, @PathVariable("money")Integer money){

return iUserService.deductBalance(id, money);

}IUserServiceImpl

package com.itheima.mp.service.impl;

/**

* @Author:CharmingDaiDai

* @Project:mp-demo

* @Date:2024/5/17 下午3:36

*/

@Service

public class IUserServiceImpl extends ServiceImpl<UserMapper, User> implements IUserService {

@Resource

// userMapper可以不用注入

// 因为已经继承了baseMapper,直接使用baseMapper

private UserMapper userMapper;

@Override

public String deductBalance(Long id, Integer money) {

// 直接调用实现的service接口

// User user = getById(id);

User user = userMapper.selectById(id);

if(user==null || user.getStatus() == 2){

return "用户状态异常!";

}

if (user.getBalance() <money ){

return "余额不足!";

}

user.setBalance(user.getBalance() - money);

// updateById(user);

userMapper.updateById(user);

return "扣减余额成功!";

}

} // 4.扣减余额

baseMapper.deductMoneyById(id, money);

@Update("UPDATE user SET balance = balance - #{money} WHERE id = #{id}")

void deductMoneyById(@Param("id") Long id, @Param("money") Integer money);Lambda

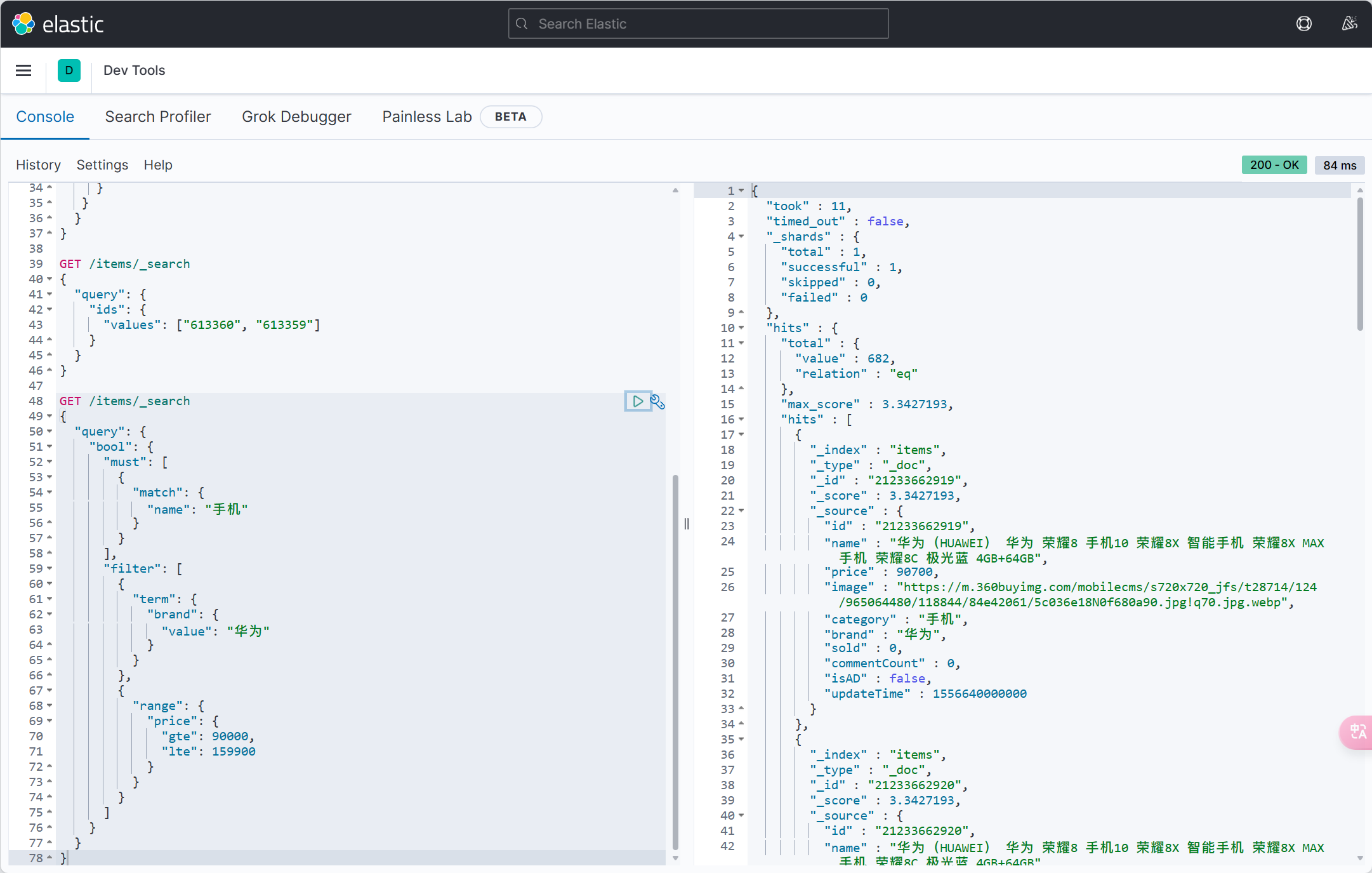

案例一:实现一个根据复杂条件查询用户的接口,查询条件如下:

- name:用户名关键字,可以为空

- status:用户状态,可以为空

- minBalance:最小余额,可以为空

- maxBalance:最大余额,可以为空

可以理解成一个用户的后台管理界面,管理员可以自己选择条件来筛选用户,因此上述条件不一定存在,需要做判断。

controller

@ApiOperation(value = "根据条件查询")

@GetMapping("/list")

public List<UserVO> getUsers(UserQuery userQuery){

List<User> users = iUserService.list(userQuery);

return BeanUtil.copyToList(users, UserVO.class);

}实现类

@Override

public List<User> list(UserQuery userQuery) {

String name = userQuery.getName();

Integer status = userQuery.getStatus();

Integer maxBalance = userQuery.getMaxBalance();

Integer minBalance = userQuery.getMinBalance();

List<User> users = lambdaQuery()

.like(name != null, User::getUsername, name)

.eq(status != null, User::getStatus, status)

.lt(maxBalance != null, User::getBalance, maxBalance)

.gt(minBalance != null, User::getBalance, minBalance)

.list();

return users;

}❗️记得➕.list()

需求:改造根据id修改用户余额的接口,要求如下

- 如果扣减后余额为0,则将用户status修改为冻结状态(2)

也就是说在扣减用户余额时,需要对用户剩余余额做出判断,如果发现剩余余额为0,则应该将status修改为2,这就是说update语句的set部分是动态的。

@Override

@Transactional(propagation = Propagation.REQUIRED, rollbackFor = Exception.class)

public String deductBalance(Long id, Integer money) {

// 直接调用实现的service接口

// User user = getById(id);

User user = userMapper.selectById(id);

if(user==null || user.getStatus() == 2){

return "用户状态异常!";

}

Integer balance = user.getBalance();

if (balance <money ){

return "余额不足!";

}

int remainBalance = balance - money;

// 使用乐观锁确保并发安全

boolean updateSuccess = lambdaUpdate()

.set(User::getBalance, remainBalance)

.set(remainBalance == 0, User::getStatus, 2)

.eq(User::getId, id)

.eq(User::getBalance, balance)

.update();

return "扣减余额成功!";

}❗️记得➕.update() 前面只是构建语句,不加不会执行

ℹ️@Transactional

在Spring框架中,@Transactional注解用于管理方法或类的事务行为。它提供了多个属性来配置事务的具体行为,其中 propagation 和 rollbackFor 是两个常用的属性。

Propagation(传播行为)

传播行为(Propagation)定义了事务的边界,决定了当前方法是否应该在一个现有事务中运行,或者是否应该启动一个新的事务。Spring提供了七种传播行为:

REQUIRED(默认值):

- 如果当前已经存在一个事务,则当前方法将在该事务中运行。

- 如果当前没有事务,则会启动一个新的事务。

- 这是最常用的传播行为,确保方法始终在事务中运行。

REQUIRES_NEW:

- 无论是否存在当前事务,总是会启动一个新的事务。

- 如果当前已经有一个事务,则该事务会被挂起,直到新的事务完成。

SUPPORTS:

- 如果当前存在一个事务,则当前方法在该事务中运行。

- 如果当前没有事务,则该方法不在事务中运行。

NOT_SUPPORTED:

- 如果当前存在一个事务,则该事务会被挂起,当前方法在没有事务的情况下运行。

MANDATORY:

- 必须在一个现有事务中运行,如果当前没有事务,则抛出异常。

NEVER:

- 当前方法必须在没有事务的情况下运行,如果当前存在事务,则抛出异常。

NESTED:

- 如果当前存在一个事务,则在该事务的嵌套事务中运行。

- 如果当前没有事务,则启动一个新的事务。

- 嵌套事务是通过保存点(savepoint)实现的,可以部分回滚到保存点,而不影响外部事务。

rollbackFor(回滚规则)

rollbackFor属性定义了哪些异常会导致事务回滚。默认情况下,Spring只会在未检查异常(unchecked exceptions,继承自RuntimeException的异常)和错误(Error)上回滚事务,但可以通过rollbackFor指定其他类型的异常。

rollbackFor:指定一个或多个异常类,当这些异常被抛出时,事务将回滚。例如:@Transactional(rollbackFor = Exception.class)这意味着当方法中抛出

Exception或其子类异常时,事务将回滚。Exception是所有受检查异常(checked exceptions)和未检查异常的基类,所以这种配置会捕获几乎所有类型的异常。

详细示例

下面是一个使用 @Transactional 的详细示例,结合了 propagation 和 rollbackFor:

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.stereotype.Service;

import org.springframework.transaction.annotation.Propagation;

import org.springframework.transaction.annotation.Transactional;

@Service

public class UserService {

@Autowired

private UserMapper userMapper;

@Transactional(propagation = Propagation.REQUIRED, rollbackFor = Exception.class)

public String deductBalance(Long id, Integer money) {

// 获取用户信息

User user = userMapper.selectById(id);

if (user == null || user.getStatus() == 2) {

return "用户状态异常!";

}

Integer balance = user.getBalance();

if (balance < money) {

return "余额不足!";

}

int remainBalance = balance - money;

// 使用乐观锁确保并发安全

boolean updateSuccess = userMapper.updateUserBalance(id, remainBalance, balance);

if (!updateSuccess) {

return "余额扣减失败,请重试!";

}

return "扣减余额成功!";

}

}解释

propagation = Propagation.REQUIRED:

- 确保

deductBalance方法始终在一个事务中运行。如果调用该方法时已经有一个事务在进行,则在该事务中运行;否则,会启动一个新的事务。

- 确保

rollbackFor = Exception.class:

- 指定了方法在捕获任何

Exception或其子类异常时回滚事务。这样可以确保即使是受检查异常也会触发事务回滚。

- 指定了方法在捕获任何

使用场景

- REQUIRED:适用于大多数情况,确保方法在事务中运行。是最常用的传播行为。

- REQUIRES_NEW:适用于需要独立的事务处理逻辑,不影响当前事务的场景。

- rollbackFor = Exception.class:适用于希望捕获所有异常(包括受检查异常和未检查异常)并回滚事务的情况。

通过合理配置 @Transactional 注解,可以灵活地控制事务的行为,确保数据的一致性和完整性。

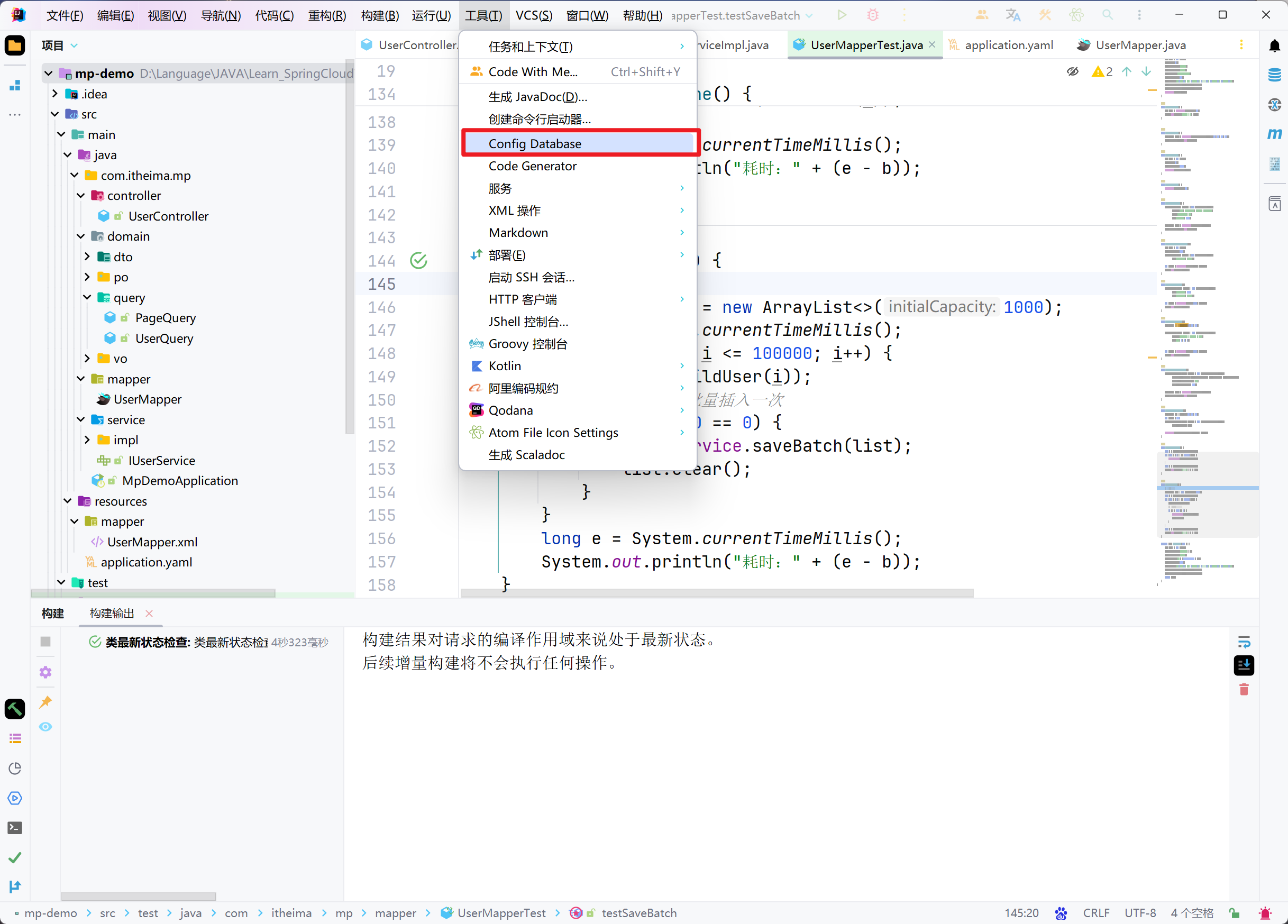

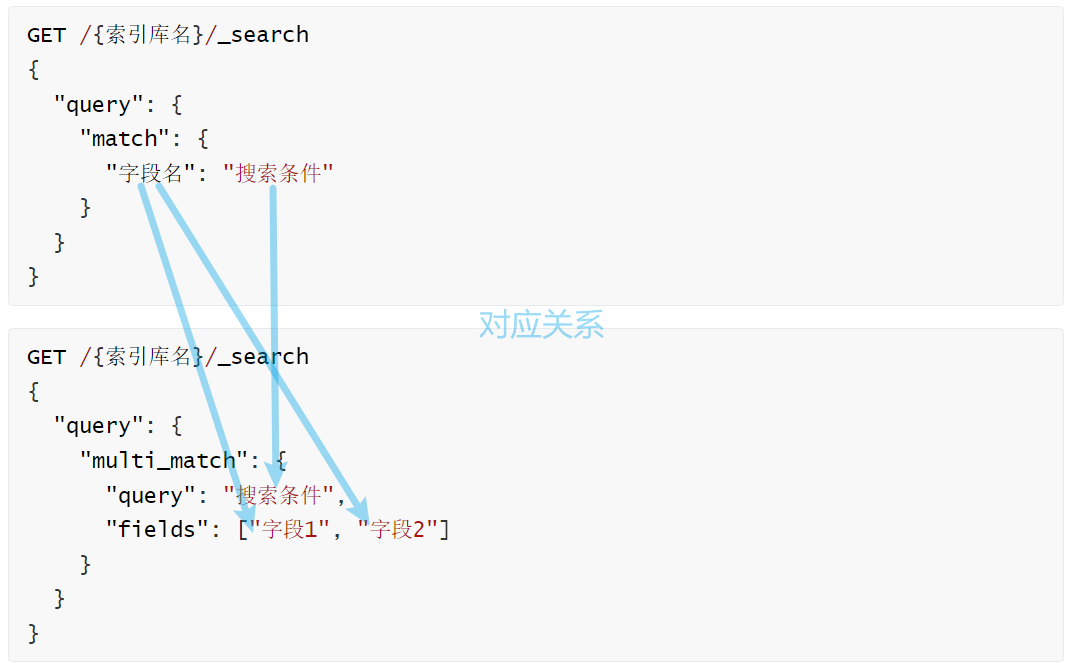

批量新增

逐条

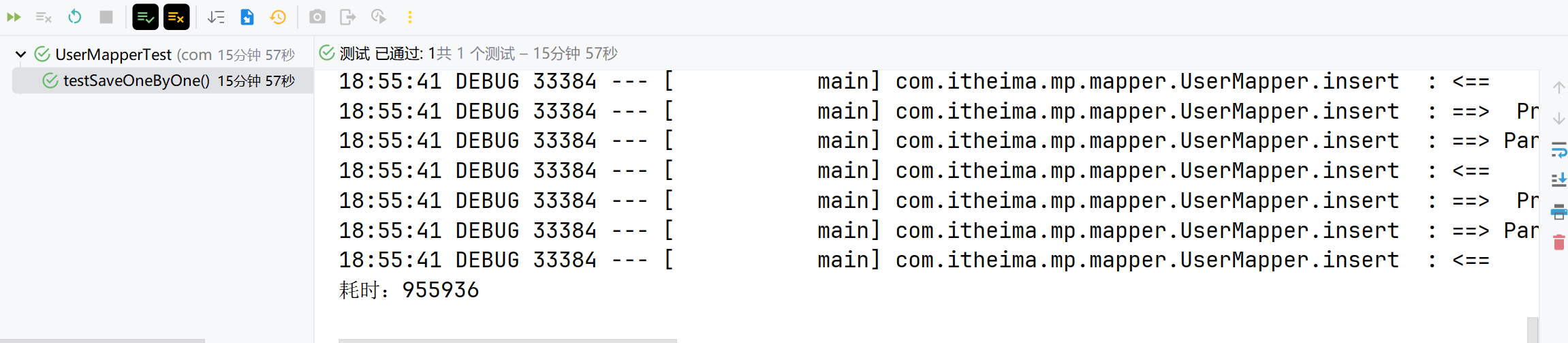

IService中的批量新增功能使用起来非常方便,但有一点注意事项,先来测试一下。 首先测试逐条插入数据:

@Test

void testSaveOneByOne() {

long b = System.currentTimeMillis();

for (int i = 1; i <= 100000; i++) {

userService.save(buildUser(i));

}

long e = System.currentTimeMillis();

System.out.println("耗时:" + (e - b));

}

private User buildUser(int i) {

User user = new User();

user.setUsername("user_" + i);

user.setPassword("123");

user.setPhone("" + (18688190000L + i));

user.setBalance(2000);

user.setInfo("{\"age\": 24, \"intro\": \"英文老师\", \"gender\": \"female\"}");

user.setCreateTime(LocalDateTime.now());

user.setUpdateTime(user.getCreateTime());

return user;

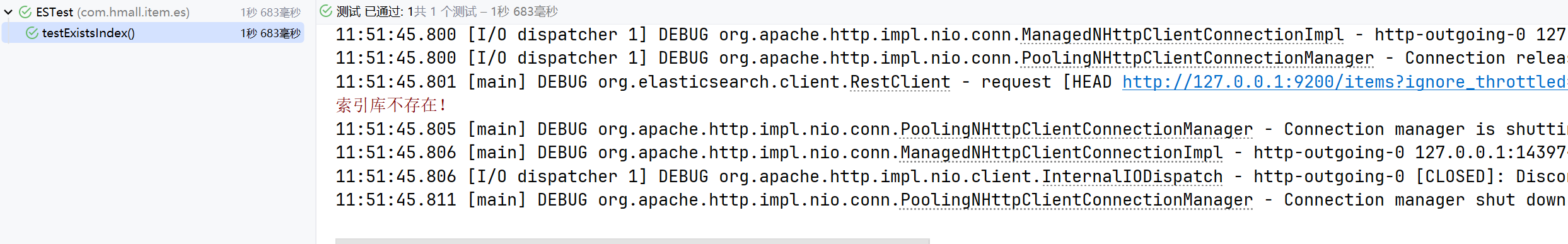

}执行结果如下:

可以看到速度非常慢。

批处理

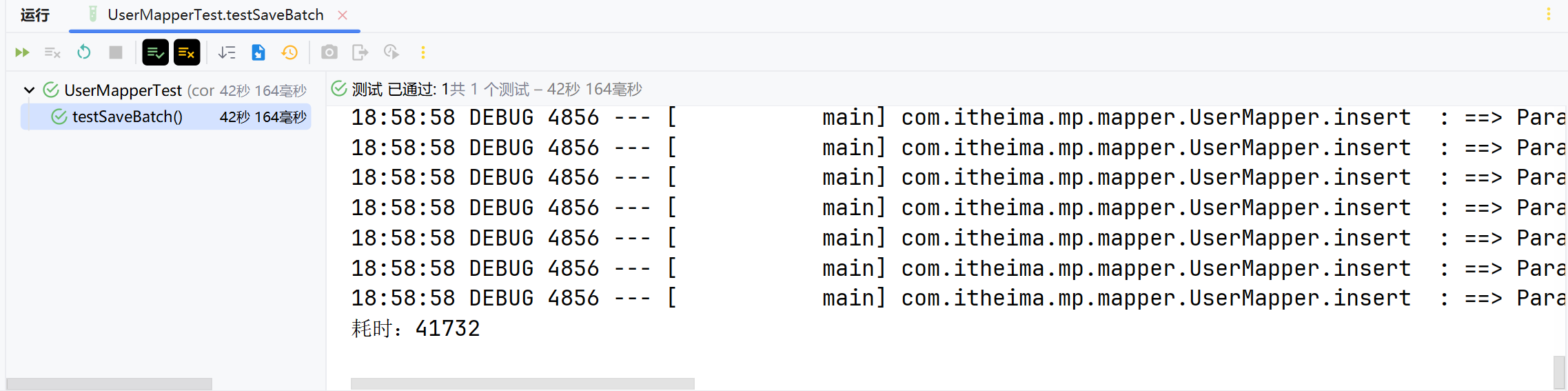

然后再试试MybatisPlus的批处理:

@Test

void testSaveBatch() {

// 准备10万条数据

List<User> list = new ArrayList<>(1000);

long b = System.currentTimeMillis();

for (int i = 1; i <= 100000; i++) {

list.add(buildUser(i));

// 每1000条批量插入一次

if (i % 1000 == 0) {

userService.saveBatch(list);

list.clear();

}

}

long e = System.currentTimeMillis();

System.out.println("耗时:" + (e - b));

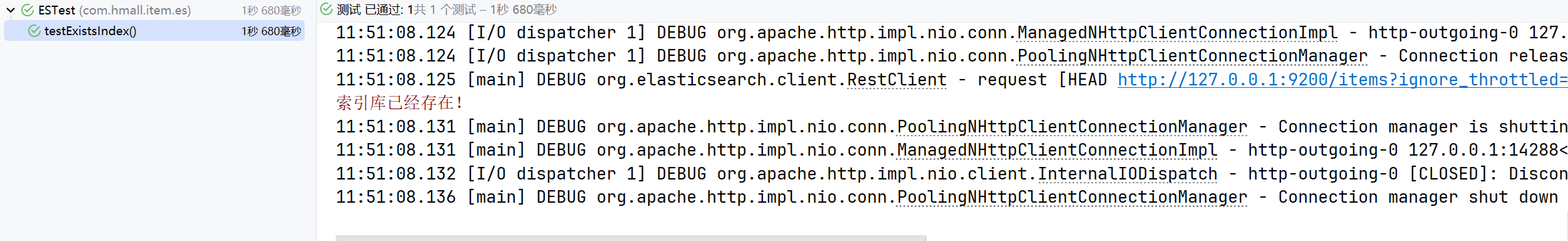

}执行最终耗时如下:

可以看到使用了批处理以后,比逐条新增效率提高了10倍左右,性能还是不错的。

不过,简单查看一下MybatisPlus源码:

@Transactional(rollbackFor = Exception.class)

@Override

public boolean saveBatch(Collection<T> entityList, int batchSize) {

String sqlStatement = getSqlStatement(SqlMethod.INSERT_ONE);

return executeBatch(entityList, batchSize, (sqlSession, entity) -> sqlSession.insert(sqlStatement, entity));

}

// ...SqlHelper

public static <E> boolean executeBatch(Class<?> entityClass, Log log, Collection<E> list, int batchSize, BiConsumer<SqlSession, E> consumer) {

Assert.isFalse(batchSize < 1, "batchSize must not be less than one");

return !CollectionUtils.isEmpty(list) && executeBatch(entityClass, log, sqlSession -> {

int size = list.size();

int idxLimit = Math.min(batchSize, size);

int i = 1;

for (E element : list) {

consumer.accept(sqlSession, element);

if (i == idxLimit) {

sqlSession.flushStatements();

idxLimit = Math.min(idxLimit + batchSize, size);

}

i++;

}

});

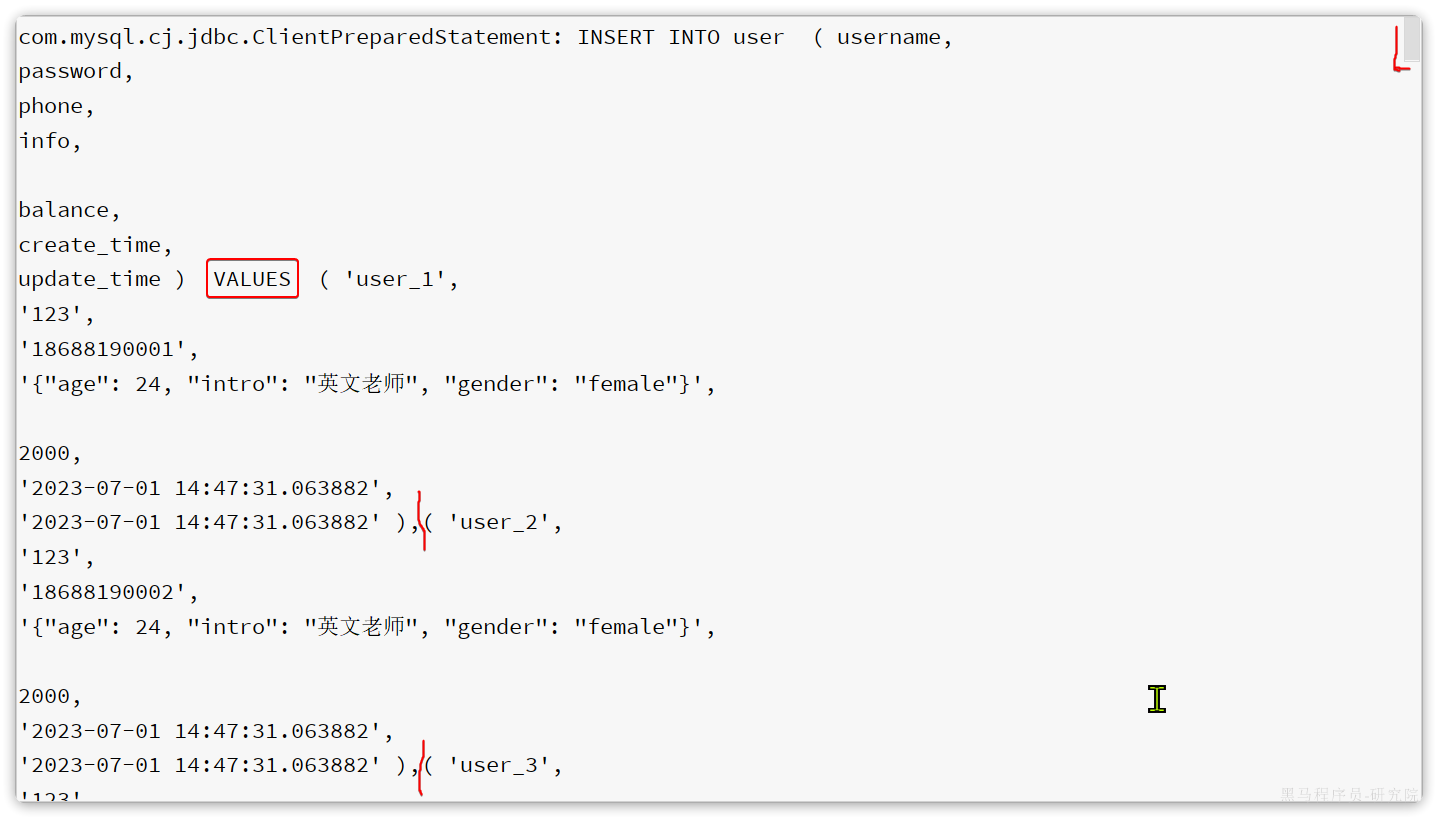

}可以发现其实MybatisPlus的批处理是基于PrepareStatement的预编译模式,然后批量提交,最终在数据库执行时还是会有多条insert语句,逐条插入数据。SQL类似这样:

Preparing: INSERT INTO user ( username, password, phone, info, balance, create_time, update_time ) VALUES ( ?, ?, ?, ?, ?, ?, ? )

Parameters: user_1, 123, 18688190001, "", 2000, 2023-07-01, 2023-07-01

Parameters: user_2, 123, 18688190002, "", 2000, 2023-07-01, 2023-07-01

Parameters: user_3, 123, 18688190003, "", 2000, 2023-07-01, 2023-07-01而如果想要得到最佳性能,最好是将多条SQL合并为一条,像这样:

INSERT INTO user ( username, password, phone, info, balance, create_time, update_time )

VALUES

(user_1, 123, 18688190001, "", 2000, 2023-07-01, 2023-07-01),

(user_2, 123, 18688190002, "", 2000, 2023-07-01, 2023-07-01),

(user_3, 123, 18688190003, "", 2000, 2023-07-01, 2023-07-01),

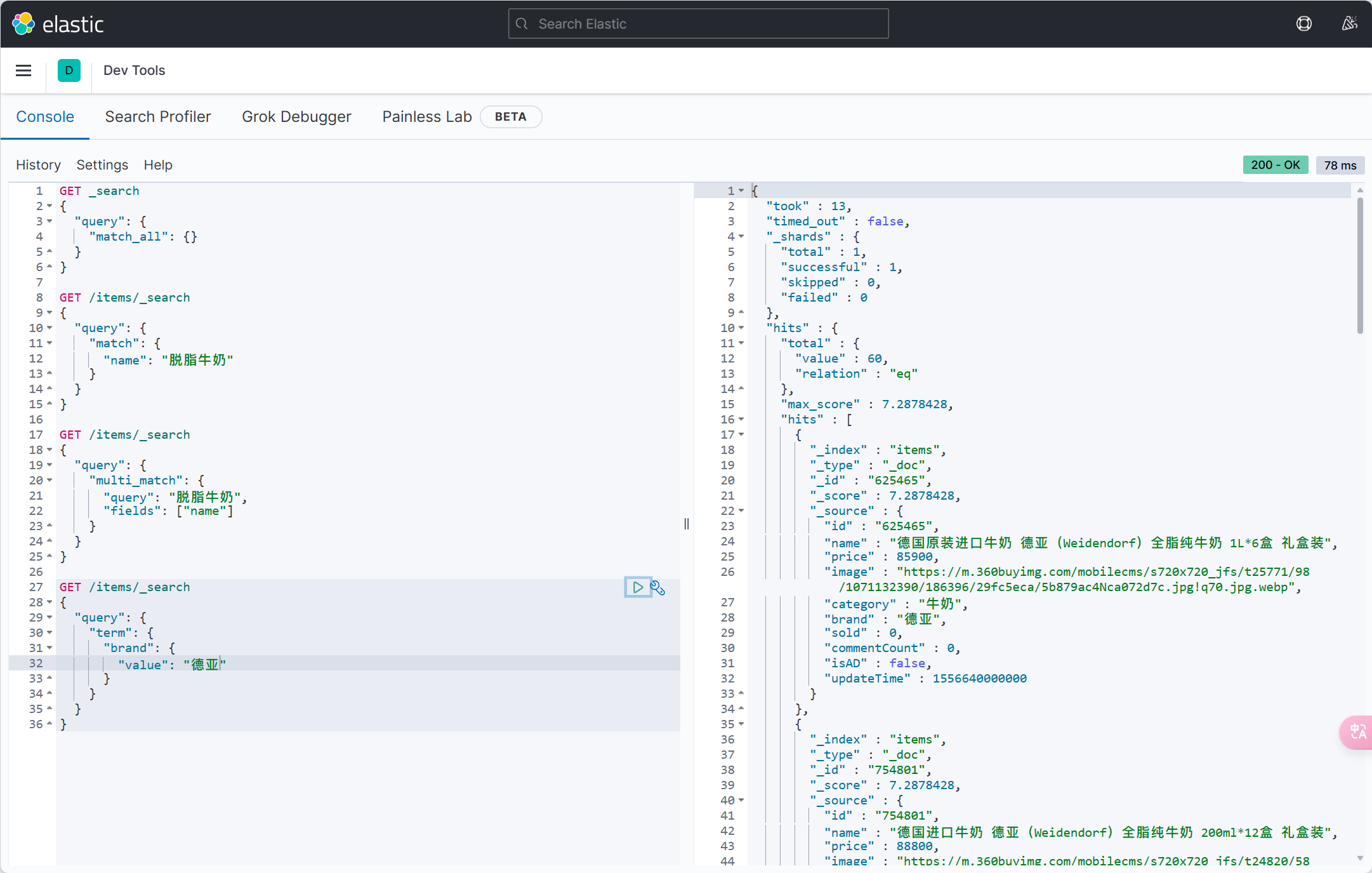

(user_4, 123, 18688190004, "", 2000, 2023-07-01, 2023-07-01);该怎么做呢?

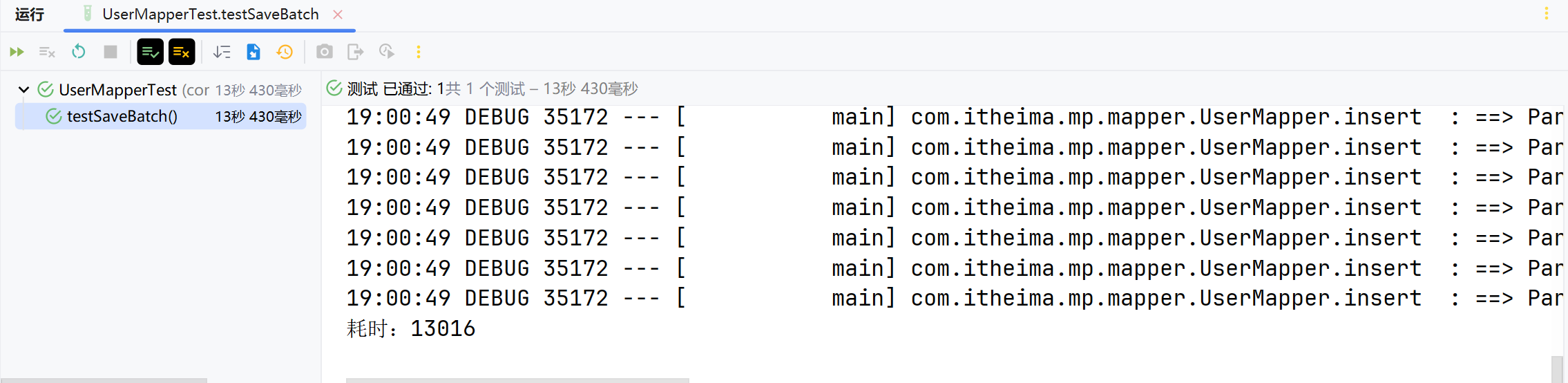

rewriteBatchedStatements

MySQL的客户端连接参数中有这样的一个参数:rewriteBatchedStatements。顾名思义,就是重写批处理的statement语句.

这个参数的默认值是false,需要修改连接参数,将其配置为true

修改项目中的application.yml文件,在jdbc的url后面添加参数&rewriteBatchedStatements=true:

spring:

datasource:

url: jdbc:mysql://127.0.0.1:3306/mp?useUnicode=true&characterEncoding=UTF-8&autoReconnect=true&serverTimezone=Asia/Shanghai&rewriteBatchedStatements=true

driver-class-name: com.mysql.cj.jdbc.Driver

username: cdd

password: 1再次测试插入10万条数据,可以发现速度有非常明显的提升:

在ClientPreparedStatement的executeBatchInternal中,有判断rewriteBatchedStatements值是否为true并重写SQL的功能:

最终,SQL被重写了:

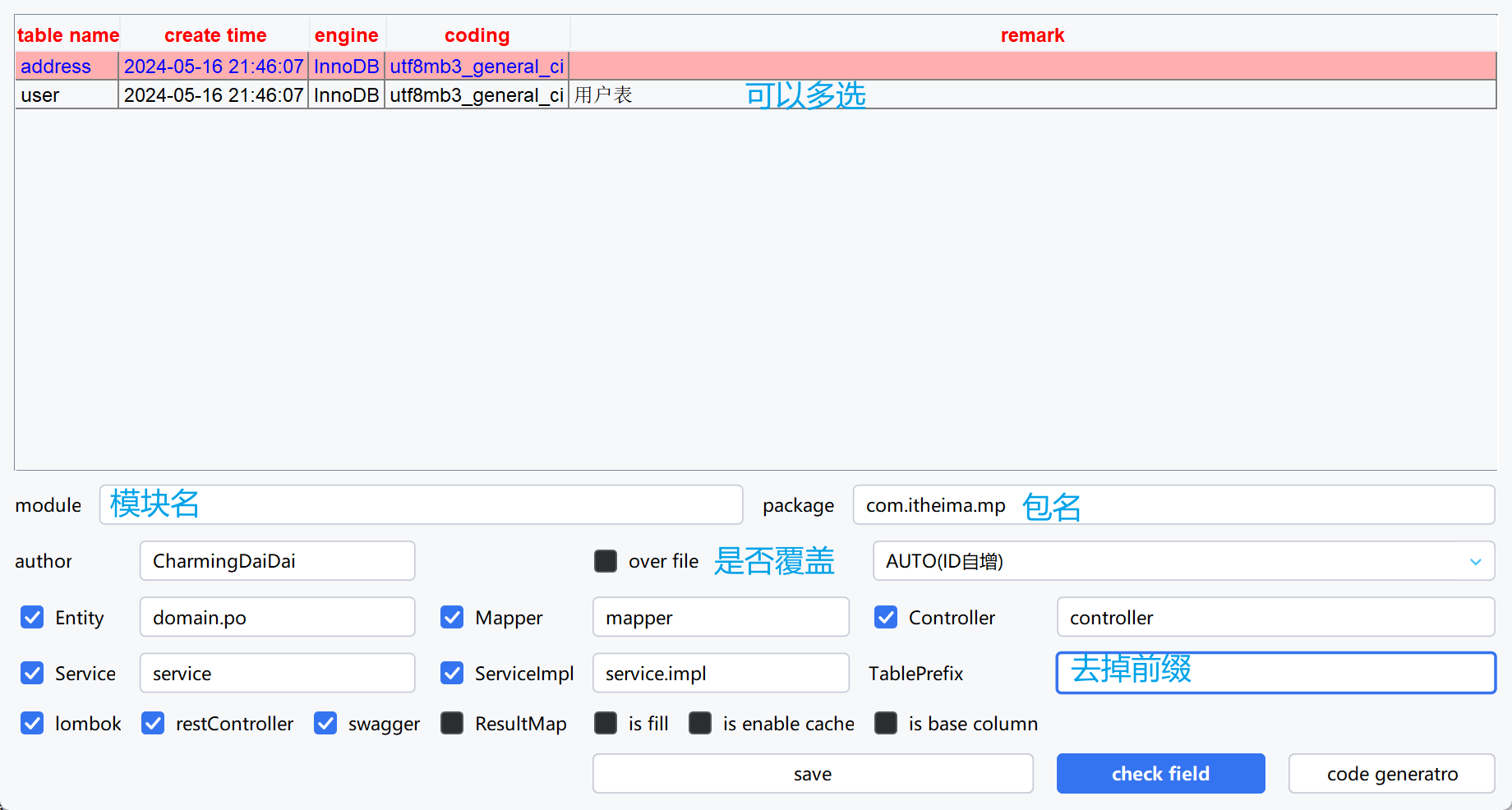

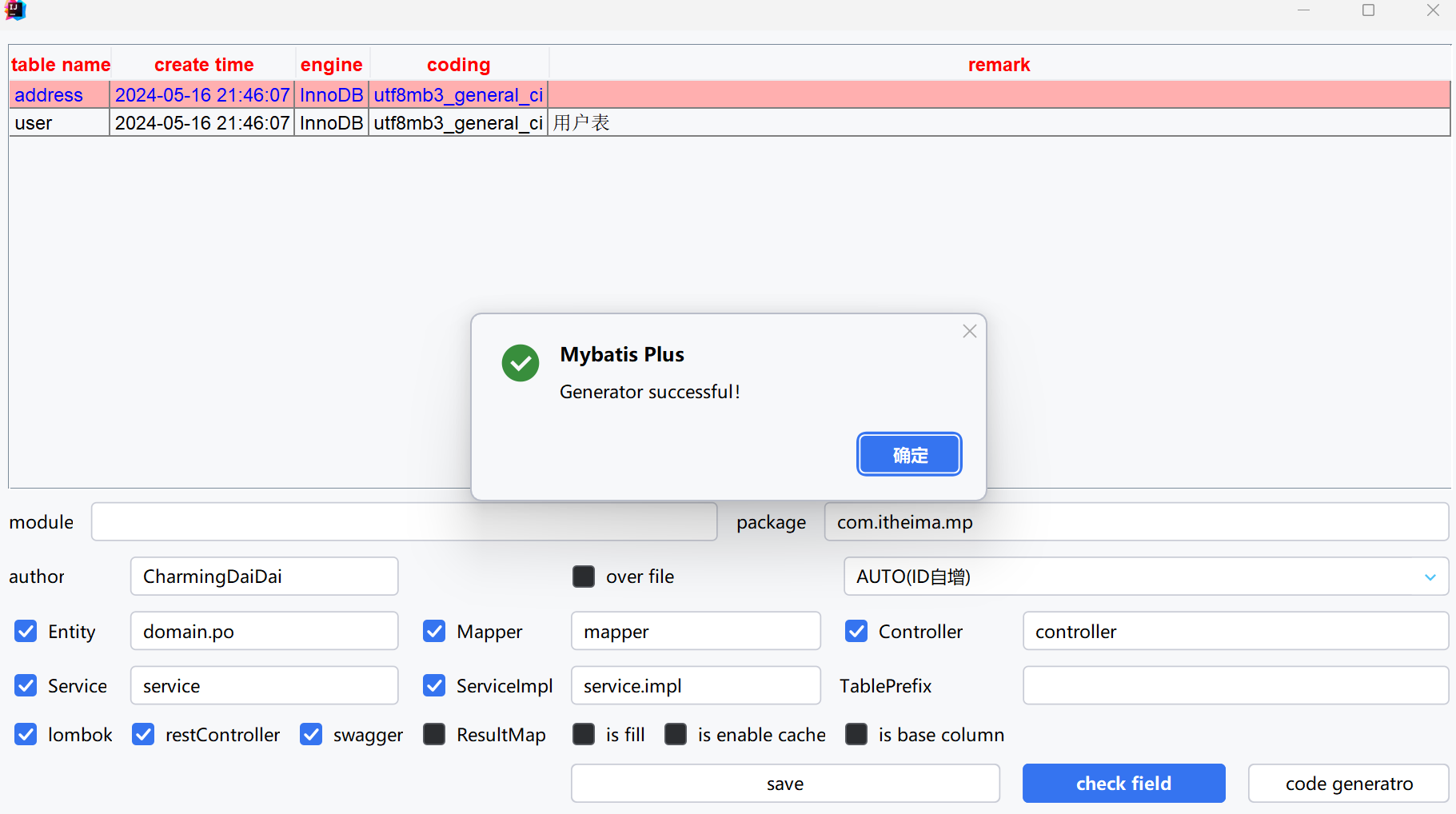

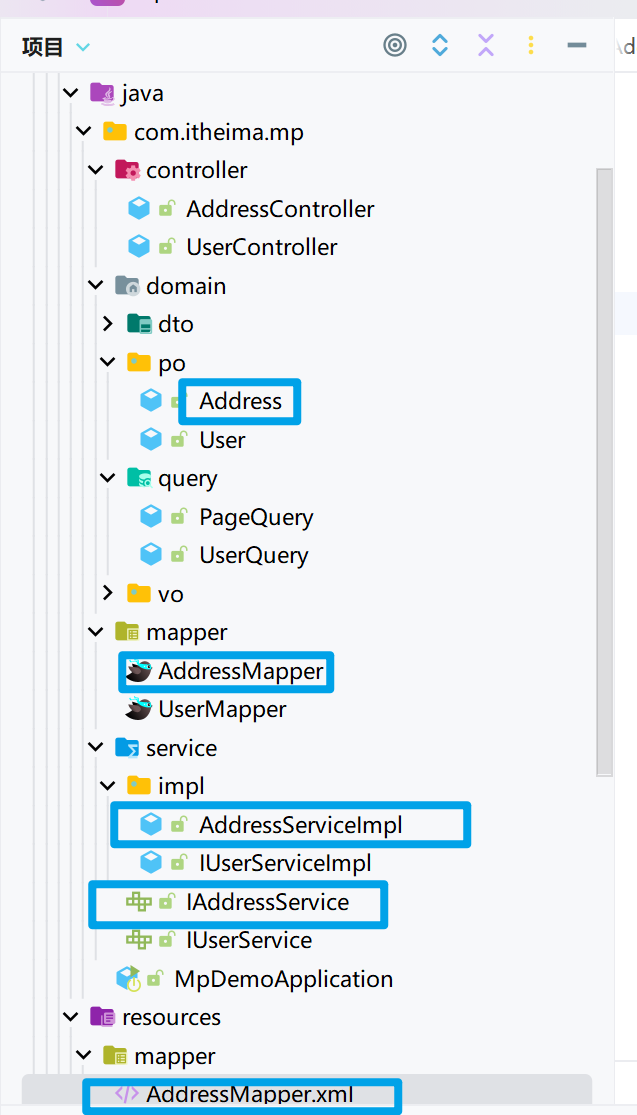

代码生成器

DB静态工具

有的时候Service之间也会相互调用,为了避免出现循环依赖问题,MybatisPlus提供一个静态工具类:Db,其中的一些静态方法与IService中方法签名基本一致,也可以帮助实现CRUD功能

需求:改造根据id用户查询的接口,查询用户的同时返回用户收货地址列表

添加收货地址VO对象

package com.itheima.mp.domain.vo;

import io.swagger.annotations.ApiModel;

import io.swagger.annotations.ApiModelProperty;

import lombok.Data;

@Data

@ApiModel(description = "收货地址VO")

public class AddressVO{

@ApiModelProperty("id")

private Long id;

@ApiModelProperty("用户ID")

private Long userId;

@ApiModelProperty("省")

private String province;

@ApiModelProperty("市")

private String city;

@ApiModelProperty("县/区")

private String town;

@ApiModelProperty("手机")

private String mobile;

@ApiModelProperty("详细地址")

private String street;

@ApiModelProperty("联系人")

private String contact;

@ApiModelProperty("是否是默认 1默认 0否")

private Boolean isDefault;

@ApiModelProperty("备注")

private String notes;

}controller

@ApiOperation(value = "根据id查询用户")

@GetMapping("/{id}")

public UserVO getById(@PathVariable Long id){

return iUserService.queryUserAndAddressById(id);

}实现类

@Override

public UserVO queryUserAndAddressById(Long id) {

User user = getById(id);

if (user == null || user.getStatus() == 2) {

throw new RuntimeException("用户状态异常");

}

List<Address> addressList = Db.lambdaQuery(Address.class).eq(Address::getUserId, id).list();

UserVO userVO = new UserVO();

BeanUtil.copyProperties(user, userVO);

userVO.setAddresses(BeanUtil.copyToList(addressList, AddressVO.class));

return userVO;

}批量改造:

controller

@ApiOperation(value = "根据id查询用户")

@GetMapping("/{id}")

public UserVO getById(@PathVariable Long id){

return iUserService.queryUserAndAddressById(id);

}实现类

@Override

public List<UserVO> queryUserAndAddressByIds(List<Long> ids) {

List<User> users = listByIds(ids);

if (users == null) {

return Collections.emptyList();

}

List<Long> userIds = users.stream().map(User::getId).collect(Collectors.toList());

List<Address> addressList = Db.lambdaQuery(Address.class).in(Address::getUserId, userIds).list();

List<AddressVO> addressVOS = BeanUtil.copyToList(addressList, AddressVO.class);

Map<Long, List<AddressVO>> addressMap = new HashMap<>();

if (addressList != null){

addressMap = addressVOS.stream().collect(Collectors.groupingBy(AddressVO::getUserId));

}

List<UserVO> userVOS = new ArrayList<>();

for (User user : users) {

UserVO userVO = BeanUtil.copyProperties(user, UserVO.class);

userVO.setAddresses(addressMap.get(user.getId()));

userVOS.add(userVO);

}

return userVOS;

}逻辑删除

对于一些比较重要的数据,往往会采用逻辑删除的方案,即:

- 在表中添加一个字段标记数据是否被删除

- 当删除数据时把标记置为true

- 查询时过滤掉标记为true的数据

一旦采用了逻辑删除,所有的查询和删除逻辑都要跟着变化,非常麻烦。

为了解决这个问题,MybatisPlus就添加了对逻辑删除的支持。

注意,只有MybatisPlus生成的SQL语句才支持自动的逻辑删除,自定义SQL需要自己手动处理逻辑删除。

给address表添加一个逻辑删除字段:

alter table address add deleted bit default b'0' null comment '逻辑删除';给Address实体添加一个逻辑删除字段

@Data

@EqualsAndHashCode(callSuper = false)

@Accessors(chain = true)

@TableName("address")

@ApiModel(value="Address对象", description="")

public class Address implements Serializable {

private static final long serialVersionUID = 1L;

@TableId(value = "id", type = IdType.AUTO)

private Long id;

@ApiModelProperty(value = "用户ID")

private Long userId;

@ApiModelProperty(value = "省")

private String province;

@ApiModelProperty(value = "市")

private String city;

@ApiModelProperty(value = "县/区")

private String town;

@ApiModelProperty(value = "手机")

private String mobile;

@ApiModelProperty(value = "详细地址")

private String street;

@ApiModelProperty(value = "联系人")

private String contact;

@ApiModelProperty(value = "是否是默认 1默认 0否")

private Boolean isDefault;

@ApiModelProperty(value = "备注")

private String notes;

@ApiModelProperty(value = "逻辑删除")

private Boolean deleted;

}在application.yml中配置逻辑删除字段

mybatis-plus:

type-aliases-package: com.itheima.mp.domain.po

global-config:

db-config:

id-type: auto # 全局id类型为自增长

logic-delete-field: deleted # 全局逻辑删除的实体字段名(since 3.3.0,配置后可以忽略不配置步骤2)

logic-delete-value: 1 # 逻辑已删除值(默认为 1)

logic-not-delete-value: 0 # 逻辑未删除值(默认为 0)测试

@Test

void testDeleteByLogic() {

// 删除方法与以前没有区别

addressService.removeById(59L);

}@Test

void testQuery() {

List<Address> list = addressService.list();

list.forEach(System.out::println);

}注意: 逻辑删除本身也有自己的问题,比如:

- 会导致数据库表垃圾数据越来越多,从而影响查询效率

- SQL中全都需要对逻辑删除字段做判断,影响查询效率

因此,我不太推荐采用逻辑删除功能,如果数据不能删除,可以采用把数据迁移到其它表的办法。

通用枚举

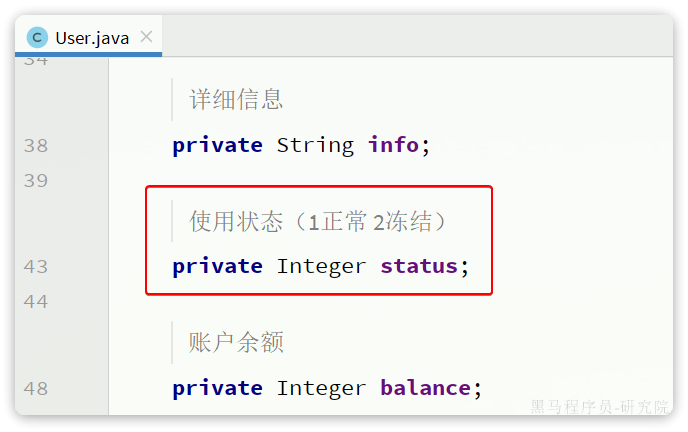

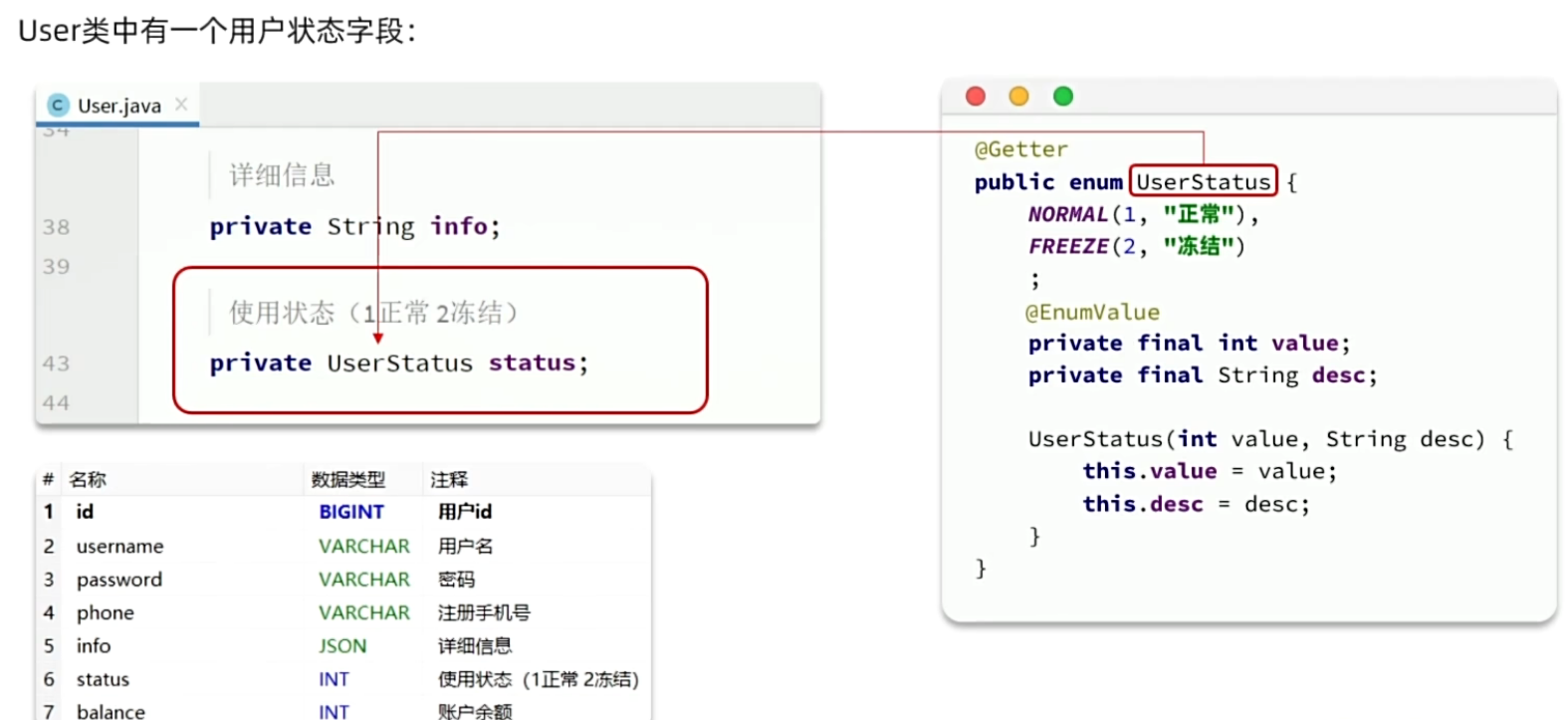

User类中有一个用户状态字段:

像这种字段一般会定义一个枚举,做业务判断的时候就可以直接基于枚举做比较。但是数据库采用的是int类型,对应的PO也是Integer。因此业务操作时必须手动把枚举与Integer转换,非常麻烦。

因此,MybatisPlus提供了一个处理枚举的类型转换器,可以帮把枚举类型与数据库类型自动转换。

定义枚举

package com.itheima.mp.enums;

import com.baomidou.mybatisplus.annotation.EnumValue;

import com.fasterxml.jackson.annotation.JsonValue;

import lombok.Getter;

/**

* @author:CharmingDaiDai

* @project:mp-demo

* @since:2024/5/17 下午8:52

*/

@Getter

public enum UserStatus {

NORMAL(1, "正常"),

FREEZE(2, "冻结"),

;

private final int value;

private final String desc;

UserStatus(int value, String desc) {

this.value = value;

this.desc = desc;

}

}把User类中的status字段改为UserStatus 类型

/**

* 使用状态(1正常 2冻结)

*/

private UserStatus status;MybatisPlus提供了@EnumValue注解来标记枚举属性

配置枚举处理器

❗️3.5.2开始无需配置

mybatis-plus:

configuration:

default-enum-type-handler: com.baomidou.mybatisplus.core.handlers.MybatisEnumTypeHandler测试

@Test

void testService() {

List<User> list = userService.list();

list.forEach(System.out::println);

}21:03:08 INFO 31976 --- [ main] com.zaxxer.hikari.HikariDataSource : HikariPool-1 - Starting...

21:03:09 INFO 31976 --- [ main] com.zaxxer.hikari.HikariDataSource : HikariPool-1 - Start completed.

21:03:09 DEBUG 31976 --- [ main] c.i.mp.mapper.UserMapper.selectList : ==> Preparing: SELECT id,username,password,phone,info,status,balance,create_time,update_time FROM user

21:03:09 DEBUG 31976 --- [ main] c.i.mp.mapper.UserMapper.selectList : ==> Parameters:

21:03:09 DEBUG 31976 --- [ main] c.i.mp.mapper.UserMapper.selectList : <== Total: 6

User(id=1, username=Jack, password=123, phone=13900112224, info={"age": 20, "intro": "佛系青年", "gender": "male"}, status=NORMAL, balance=1600, createTime=2023-05-19T20:50:21, updateTime=2024-05-17T15:28:46)

User(id=2, username=Rose, password=123, phone=13900112223, info={"age": 19, "intro": "青涩少女", "gender": "female"}, status=NORMAL, balance=200, createTime=2023-05-19T21:00:23, updateTime=2024-05-17T15:28:46)

User(id=3, username=Hope, password=123, phone=13900112222, info={"age": 25, "intro": "上进青年", "gender": "male"}, status=NORMAL, balance=100000, createTime=2023-06-19T22:37:44, updateTime=2023-06-19T22:37:44)

User(id=4, username=Thomas, password=123, phone=17701265258, info={"age": 29, "intro": "伏地魔", "gender": "male"}, status=NORMAL, balance=400, createTime=2023-06-19T23:44:45, updateTime=2024-05-17T15:28:46)

User(id=5, username=Lucy, password=123, phone=18688990011, info={"age": 24, "intro": "英文老师", "gender": "female"}, status=NORMAL, balance=200, createTime=2024-05-17T10:55:38, updateTime=2024-05-17T10:55:38)

User(id=6, username=test, password=123456, phone=11111111111, info={"age": 24, "intro": "英文老师", "gender": "female"}, status=NORMAL, balance=193, createTime=2024-05-17T15:43:49, updateTime=2024-05-17T15:43:49)为了使页面查询结果也是枚举格式,需要修改UserVO中的status属性

@ApiModelProperty("使用状态(1正常 2冻结)")

private UserStatus status;在UserStatus枚举中通过@JsonValue注解标记JSON序列化时展示的字段

package com.itheima.mp.enums;

import com.baomidou.mybatisplus.annotation.EnumValue;

import com.fasterxml.jackson.annotation.JsonValue;

import lombok.Getter;

/**

* @author:CharmingDaiDai

* @project:mp-demo

* @since:2024/5/17 下午8:52

*/

@Getter

public enum UserStatus {

NORMAL(1, "正常"),

FREEZE(2, "冻结");

@EnumValue

private final int value;

@JsonValue

private final String desc;

UserStatus(int value, String desc) {

this.value = value;

this.desc = desc;

}

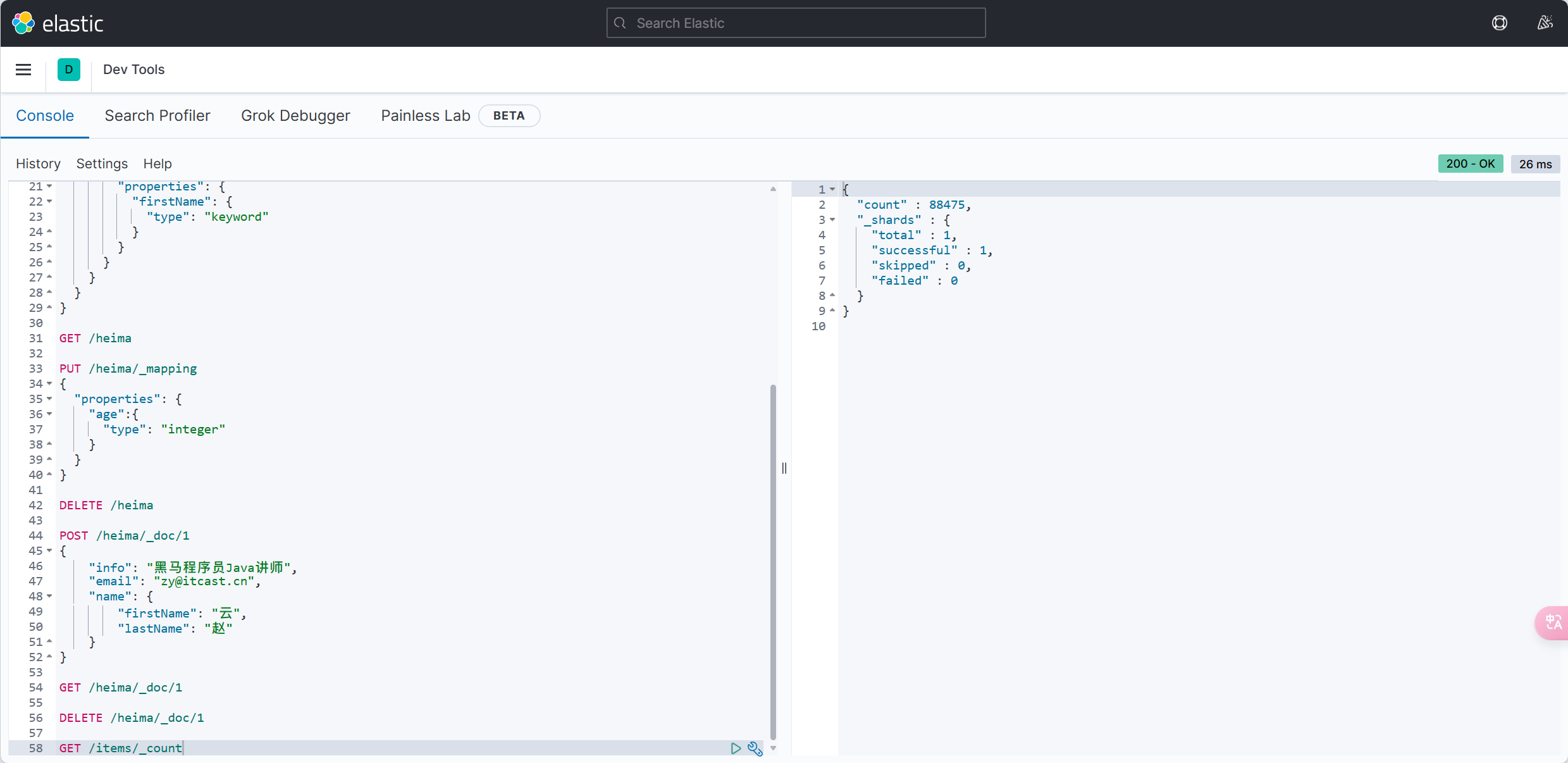

}Json类处理器

数据库的user表中有一个info字段,是JSON类型:

格式像这样:

{"age": 20, "intro": "佛系青年", "gender": "male"}而目前User实体类中却是String类型:

这样一来,要读取info中的属性时就非常不方便。如果要方便获取,info的类型最好是一个Map或者实体类。

而一旦把info改为对象类型,就需要在写入数据库时手动转为String,再读取数据库时,手动转换为对象,这会非常麻烦。

因此MybatisPlus提供了很多特殊类型字段的类型处理器,解决特殊字段类型与数据库类型转换的问题。例如处理JSON就可以使用JacksonTypeHandler处理器。

定义实体

package com.itheima.mp.domain.po;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

@Data

@AllArgsConstructor(staticName = "of")

@NoArgsConstructor

public class UserInfo {

private Integer age;

private String intro;

private String gender;

}使用类型处理器

将User类的info字段修改为UserInfo类型,并声明类型处理器,并开启注解映射:

@Data

🚩开启注解映射

@TableName(autoResultMap = true)

public class User {

/**

* 用户id

*/

@TableId(type = IdType.AUTO)

private Long id;

/**

* 用户名

*/

private String username;

/**

* 密码

*/

private String password;

/**

* 注册手机号

*/

private String phone;

/**

* 详细信息

*/

🚩声明类处理器

@TableField(typeHandler = JacksonTypeHandler.class)

private UserInfo info;

/**

* 使用状态(1正常 2冻结)

*/

private UserStatus status;

/**

* 账户余额

*/

private Integer balance;

/**

* 创建时间

*/

private LocalDateTime createTime;

/**

* 更新时间

*/

private LocalDateTime updateTime;

}修改UserVO中的info字段:

@ApiModelProperty("详细信息")

private UserInfo info;{

"id": 1,

"username": "Jack",

*-------------------------------------------------------------------*

"info": "{\"age\": 20, \"intro\": \"佛系青年\", \"gender\": \"male\"}",

*-------------------------------------------------------------------*

"info": {

"age": 20,

"intro": "佛系青年",

"gender": "male"

},

*-------------------------------------------------------------------*

"status": "正常",

"balance": 1600,

"addresses": [

{

"id": 60,

"userId": 1,

"province": "北京",

"city": "北京",

"town": "朝阳区",

"mobile": "13700221122",

"street": "修正大厦",

"contact": "Jack",

"isDefault": false,

"notes": null

},

{

"id": 61,

"userId": 1,

"province": "上海",

"city": "上海",

"town": "浦东新区",

"mobile": "13301212233",

"street": "航头镇航头路",

"contact": "Jack",

"isDefault": true,

"notes": null

}

]

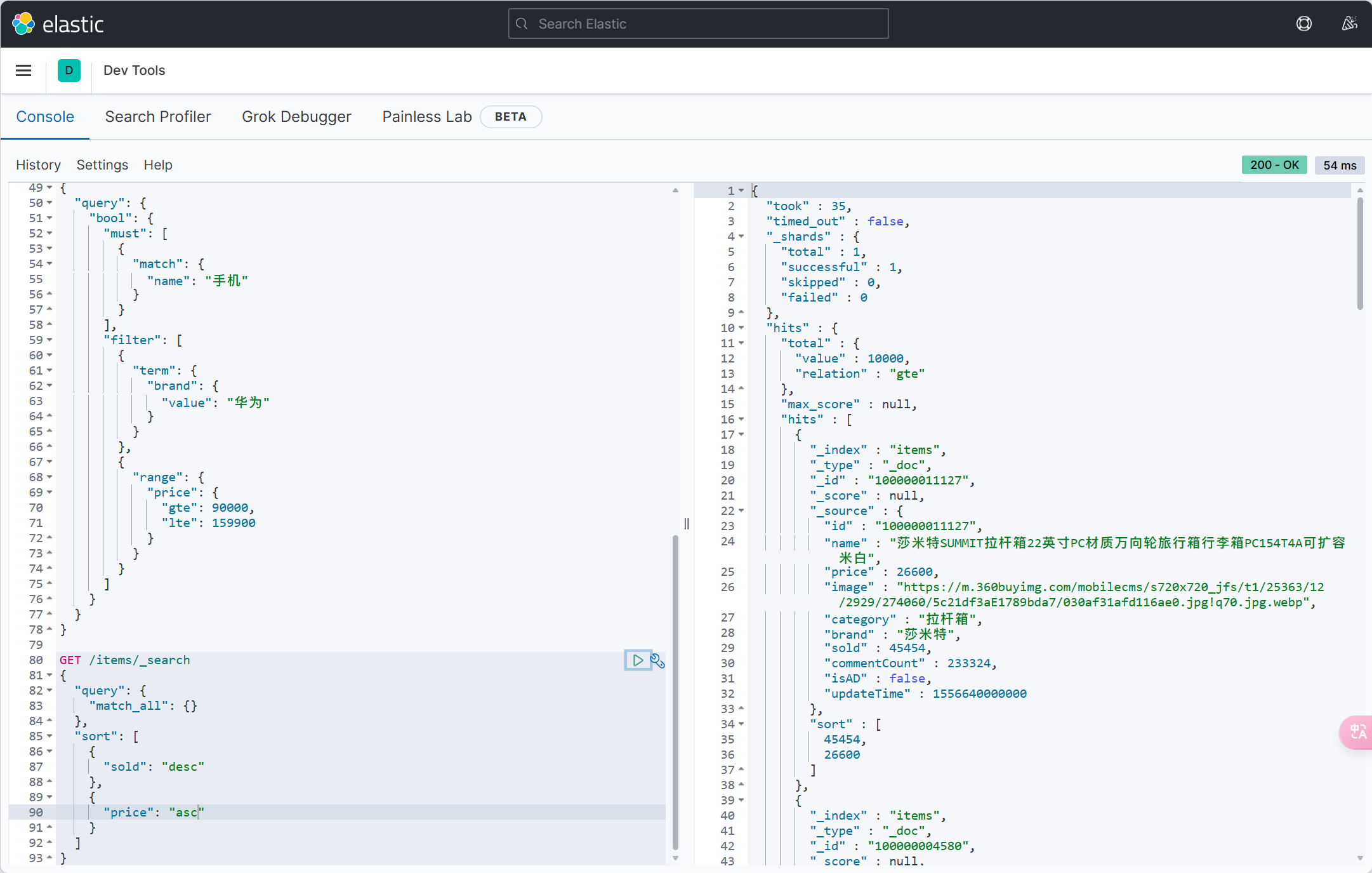

}分页插件

在3.4.0及之后的版本中,分页插件已经默认集成。无需额外配置

在未引入分页插件的情况下,MybatisPlus是不支持分页功能的,IService和BaseMapper中的分页方法都无法正常起效。 所以必须配置分页插件。

分页插件配置类

package com.itheima.mp.config;

import com.baomidou.mybatisplus.annotation.DbType;

import com.baomidou.mybatisplus.extension.plugins.MybatisPlusInterceptor;

import com.baomidou.mybatisplus.extension.plugins.inner.PaginationInnerInterceptor;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

/**

* @author:CharmingDaiDai

* @project:mp-demo

* @since:2024/5/20 上午9:10

*/

@Configuration

public class MybatisConfig {

@Bean

public MybatisPlusInterceptor mybatisPlusInterceptor() {

// 初始化核心插件

MybatisPlusInterceptor interceptor = new MybatisPlusInterceptor();

// 添加分页插件

interceptor.addInnerInterceptor(new PaginationInnerInterceptor(DbType.MYSQL));

return interceptor;

}

}测试类

@Test

void testPageQuery() {

// 1.分页查询,new Page()的两个参数分别是:页码、每页大小

Page<User> p = userService.page(new Page<>(2, 2));

// 2.总条数

System.out.println("total = " + p.getTotal());

// 3.总页数

System.out.println("pages = " + p.getPages());

// 4.数据

List<User> records = p.getRecords();

records.forEach(System.out::println);

}total = 6

pages = 3

User(id=3, username=Hope, password=123, phone=13900112222, info=UserInfo(age=25, intro=上进青年, gender=male), status=NORMAL, balance=100000, createTime=2023-06-19T22:37:44, updateTime=2023-06-19T22:37:44)

User(id=4, username=Thomas, password=123, phone=17701265258, info=UserInfo(age=29, intro=伏地魔, gender=male), status=NORMAL, balance=400, createTime=2023-06-19T23:44:45, updateTime=2024-05-17T15:28:46)可以添加排序的字段

int pageNo = 1, pageSize = 5;

// 分页参数

Page<User> page = Page.of(pageNo, pageSize);

// 排序参数, 通过OrderItem来指定

page.addOrder(new OrderItem("balance", false));

userService.page(page);分页工具类

package com.itheima.mp.domain.query;

import com.baomidou.mybatisplus.core.metadata.OrderItem;

import com.baomidou.mybatisplus.extension.plugins.pagination.Page;

import lombok.Data;

@Data

public class PageQuery {

private Integer pageNo;

private Integer pageSize;

private String sortBy;

private Boolean isAsc;

public <T> Page<T> toMpPage(OrderItem ... orders){

// 1.分页条件

Page<T> p = Page.of(pageNo, pageSize);

// 2.排序条件

// 2.1.先看前端有没有传排序字段

if (sortBy != null) {

p.addOrder(new OrderItem(sortBy, isAsc));

return p;

}

// 2.2.再看有没有手动指定排序字段

if(orders != null){

p.addOrder(orders);

}

return p;

}

public <T> Page<T> toMpPage(String defaultSortBy, boolean isAsc){

return this.toMpPage(new OrderItem(defaultSortBy, isAsc));

}

public <T> Page<T> toMpPageDefaultSortByCreateTimeDesc() {

return toMpPage("create_time", false);

}

public <T> Page<T> toMpPageDefaultSortByUpdateTimeDesc() {

return toMpPage("update_time", false);

}

}改造PageDTO

package com.itheima.mp.domain.dto;

import cn.hutool.core.bean.BeanUtil;

import com.baomidou.mybatisplus.extension.plugins.pagination.Page;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import java.util.Collections;

import java.util.List;

import java.util.function.Function;

import java.util.stream.Collectors;

@Data

@NoArgsConstructor

@AllArgsConstructor

public class PageDTO<V> {

private Long total;

private Long pages;

private List<V> list;

/**

* 返回空分页结果

* @param p MybatisPlus的分页结果

* @param <V> 目标VO类型

* @param <P> 原始PO类型

* @return VO的分页对象

*/

public static <V, P> PageDTO<V> empty(Page<P> p){

return new PageDTO<>(p.getTotal(), p.getPages(), Collections.emptyList());

}

/**

* 将MybatisPlus分页结果转为 VO分页结果

* @param p MybatisPlus的分页结果

* @param voClass 目标VO类型的字节码

* @param <V> 目标VO类型

* @param <P> 原始PO类型

* @return VO的分页对象

*/

public static <V, P> PageDTO<V> of(Page<P> p, Class<V> voClass) {

// 1.非空校验

List<P> records = p.getRecords();

if (records == null || records.size() <= 0) {

// 无数据,返回空结果

return empty(p);

}

// 2.数据转换

List<V> vos = BeanUtil.copyToList(records, voClass);

// 3.封装返回

return new PageDTO<>(p.getTotal(), p.getPages(), vos);

}

/**

* 将MybatisPlus分页结果转为 VO分页结果,允许用户自定义PO到VO的转换方式

* @param p MybatisPlus的分页结果

* @param convertor PO到VO的转换函数

* @param <V> 目标VO类型

* @param <P> 原始PO类型

* @return VO的分页对象

*/

public static <V, P> PageDTO<V> of(Page<P> p, Function<P, V> convertor) {

// 1.非空校验

List<P> records = p.getRecords();

if (records == null || records.size() <= 0) {

// 无数据,返回空结果

return empty(p);

}

// 2.数据转换

List<V> vos = records.stream().map(convertor).collect(Collectors.toList());

// 3.封装返回

return new PageDTO<>(p.getTotal(), p.getPages(), vos);

}

}controller

@ApiOperation(value = "根据分页查询")

@GetMapping("/page")

public PageDTO<UserVO> getByPage(PageQuery pageQuery){

return iUserService.queryUserByPage(pageQuery);

}实现类

@Override

public PageDTO<UserVO> queryUserByPage(PageQuery query) {

// 1.构建条件

Page<User> page = query.toMpPageDefaultSortByCreateTimeDesc();

// 2.查询

page(page);

// 3.封装返回

return PageDTO.of(page, UserVO.class);

}docker

Docker: Accelerated Container Application Development

Docker Hub Container Image Library | App Containerization

安装-ubuntu

Install Docker Engine on Ubuntu | Docker Docs

卸载旧的

Set up Docker's apt repository.

# Add Docker's official GPG key:

sudo apt-get update

sudo apt-get install ca-certificates curl

sudo install -m 0755 -d /etc/apt/keyrings

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc

sudo chmod a+r /etc/apt/keyrings/docker.asc

# Add the repository to Apt sources:

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu \

$(. /etc/os-release && echo "$VERSION_CODENAME") stable" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get updateTo install the latest version, run:

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin阿里云镜像加速

针对Docker客户端版本大于 1.10.0 的用户

您可以通过修改daemon配置文件/etc/docker/daemon.json来使用加速器

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["加速器地址"]

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker# Docker开机自启

systemctl enable docker

# Docker容器开机自启

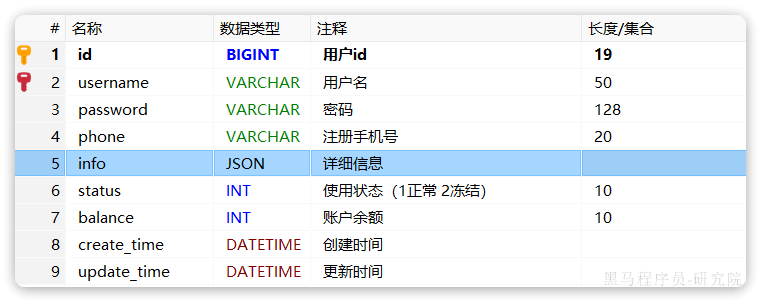

docker update --restart=always [容器名/容器id]命令

| 命令 | 说明 | 文档地址 |

|---|---|---|

| docker pull | 拉取镜像 | docker pull |

| docker push | 推送镜像到DockerRegistry | docker push |

| docker images | 查看本地镜像 | docker images |

| docker rmi | 删除本地镜像 | docker rmi |

| docker run | 创建并运行容器(不能重复创建) | docker run |

| docker stop | 停止指定容器 | docker stop |

| docker start | 启动指定容器 | docker start |

| docker restart | 重新启动容器 | docker restart |

| docker rm | 删除指定容器 | docs.docker.com |

| docker ps | 查看容器 | docker ps |

| docker logs | 查看容器运行日志 | docker logs |

| docker exec | 进入容器 | docker exec |

| docker save | 保存镜像到本地压缩文件 | docker save |

| docker load | 加载本地压缩文件到镜像 | docker load |

| docker inspect | 查看容器详细信息 | docker inspect |

命令别名

# 修改/root/.bashrc文件

vim /root/.bashrc内容如下:

# .bashrc

# User specific aliases and functions

alias rm='rm -i'

alias cp='cp -i'

alias mv='mv -i'

alias dps='docker ps --format "table {{.ID}}\t{{.Image}}\t{{.Ports}}\t{{.Status}}\t{{.Names}}"'

alias dis='docker images'

# Source global definitions

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fisource /root/.bashrc数据卷

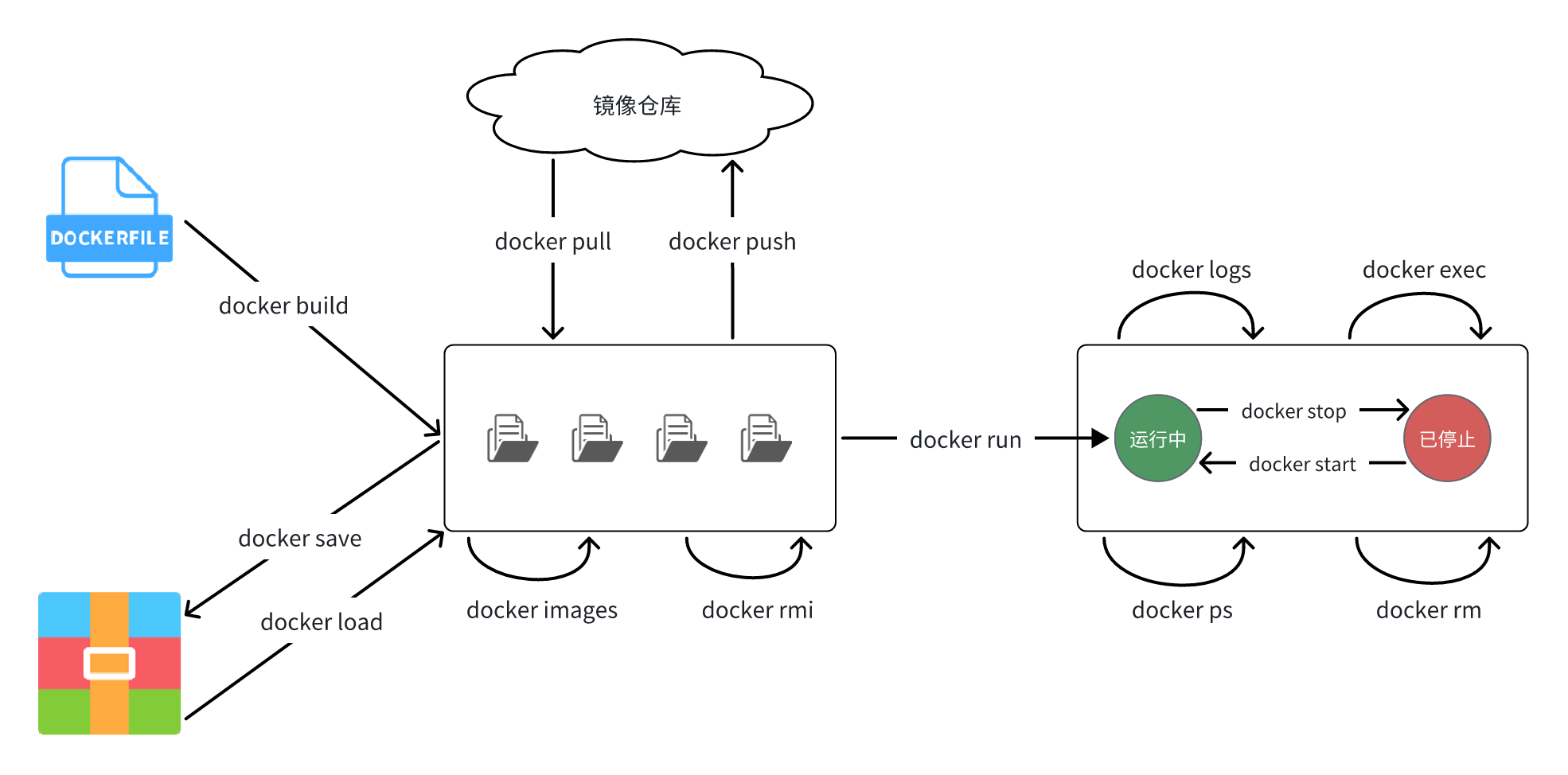

数据卷(volume)是一个虚拟目录,是容器内目录与宿主机目录之间映射的桥梁。

以Nginx为例,知道Nginx中有两个关键的目录:

html:放置一些静态资源conf:放置配置文件

如果要让Nginx代理的静态资源,最好是放到html目录;如果要修改Nginx的配置,最好是找到conf下的nginx.conf文件。

但遗憾的是,容器运行的Nginx所有的文件都在容器内部。所以必须利用数据卷将两个目录与宿主机目录关联,方便操作。如图:

在上图中:

- 创建了两个数据卷:

conf、html - Nginx容器内部的

conf目录和html目录分别与两个数据卷关联。 - 而数据卷conf和html分别指向了宿主机的

/var/lib/docker/volumes/conf/_data目录和/var/lib/docker/volumes/html/_data目录

这样以来,容器内的conf和html目录就 与宿主机的conf和html目录关联起来,称为挂载。此时,操作宿主机的/var/lib/docker/volumes/html/_data就是在操作容器内的/usr/share/nginx/html/_data目录。只要将静态资源放入宿主机对应目录,就可以被Nginx代理了。

小提示:

/var/lib/docker/volumes这个目录就是默认的存放所有容器数据卷的目录,其下再根据数据卷名称创建新目录,格式为/数据卷名/_data。

为什么不让容器目录直接指向宿主机目录呢?

- 因为直接指向宿主机目录就与宿主机强耦合了,如果切换了环境,宿主机目录就可能发生改变了。由于容器一旦创建,目录挂载就无法修改,这样容器就无法正常工作了。

- 但是容器指向数据卷,一个逻辑名称,而数据卷再指向宿主机目录,就不存在强耦合。如果宿主机目录发生改变,只要改变数据卷与宿主机目录之间的映射关系即可。

不过,通过由于数据卷目录比较深,不好寻找,通常也允许让容器直接与宿主机目录挂载而不使用数据卷

| 命令 | 说明 | 文档地址 |

|---|---|---|

| docker volume create | 创建数据卷 | docker volume create |

| docker volume ls | 查看所有数据卷 | docs.docker.com |

| docker volume rm | 删除指定数据卷 | docs.docker.com |

| docker volume inspect | 查看某个数据卷的详情 | docs.docker.com |

| docker volume prune | 清除数据卷 | docker volume prune |

❗️容器与数据卷的挂载要在创建容器时配置,对于创建好的容器,是不能设置数据卷的。而且创建容器的过程中,数据卷会自动创建。

nginx的html目录挂载

# 1.首先创建容器并指定数据卷,注意通过 -v 参数来指定数据卷

docker run -d --name nginx -p 80:80 -v html:/usr/share/nginx/html nginx

# 2.然后查看数据卷

docker volume ls

# 结果

DRIVER VOLUME NAME

local 29524ff09715d3688eae3f99803a2796558dbd00ca584a25a4bbc193ca82459f

local html

# 3.查看数据卷详情

docker volume inspect html

# 结果

[

{

"CreatedAt": "2024-05-17T19:57:08+08:00",

"Driver": "local",

"Labels": null,

"Mountpoint": "/var/lib/docker/volumes/html/_data",

"Name": "html",

"Options": null,

"Scope": "local"

}

]

# 4.查看/var/lib/docker/volumes/html/_data目录

ll /var/lib/docker/volumes/html/_data

# 可以看到与nginx的html目录内容一样,结果如下:

总用量 8

-rw-r--r--. 1 root root 497 12月 28 2021 50x.html

-rw-r--r--. 1 root root 615 12月 28 2021 index.html

# 5.进入该目录,并随意修改index.html内容

cd /var/lib/docker/volumes/html/_data

vi index.html

# 6.打开页面,查看效果

# 7.进入容器内部,查看/usr/share/nginx/html目录内的文件是否变化

docker exec -it nginx bash演示一下MySQL的匿名数据卷

# 1.查看MySQL容器详细信息

docker inspect mysql

# 关注其中.Config.Volumes部分和.Mounts部分{

"Config": {

// ... 略

"Volumes": {

"/var/lib/mysql": {}

}

// ... 略

}

}可以发现这个容器声明了一个本地目录,需要挂载数据卷,但是数据卷未定义。这就是匿名卷。

{

"Mounts": [

{

"Type": "volume",

"Name": "29524ff09715d3688eae3f99803a2796558dbd00ca584a25a4bbc193ca82459f",

"Source": "/var/lib/docker/volumes/29524ff09715d3688eae3f99803a2796558dbd00ca584a25a4bbc193ca82459f/_data",

"Destination": "/var/lib/mysql",

"Driver": "local",

}

]

}可以发现,其中有几个关键属性:

- Name:数据卷名称。由于定义容器未设置容器名,这里的就是匿名卷自动生成的名字,一串hash值。

- Source:宿主机目录

- Destination : 容器内的目录

上述配置是将容器内的/var/lib/mysql这个目录,与数据卷29524ff09715d3688eae3f99803a2796558dbd00ca584a25a4bbc193ca82459f挂载。于是在宿主机中就有了/var/lib/docker/volumes/29524ff09715d3688eae3f99803a2796558dbd00ca584a25a4bbc193ca82459f/_data这个目录。这就是匿名数据卷对应的目录,其使用方式与普通数据卷没有差别。

接下来,可以查看该目录下的MySQL的data文件:

ls -l /var/lib/docker/volumes/29524ff09715d3688eae3f99803a2796558dbd00ca584a25a4bbc193ca82459f/_data注意:每一个不同的镜像,将来创建容器后内部有哪些目录可以挂载,可以参考DockerHub对应的页面

挂载本地目录或文件

# 挂载本地目录

-v 本地目录:容器内目录

# 挂载本地文件

-v 本地文件:容器内文件❗️注意:本地目录或文件必须以 / 或 ./开头,如果直接以名字开头,会被识别为数据卷名而非本地目录名。

-v mysql:/var/lib/mysql # 会被识别为一个数据卷叫mysql,运行时会自动创建这个数据卷

-v ./mysql:/var/lib/mysql # 会被识别为当前目录下的mysql目录,运行时如果不存在会创建目录演示

- 挂载

/root/mysql/data到容器内的/var/lib/mysql目录 - 挂载

/root/mysql/init到容器内的/docker-entrypoint-initdb.d目录(初始化的SQL脚本目录) - 挂载

/root/mysql/conf到容器内的/etc/mysql/conf.d目录(这个是MySQL配置文件目录)

# 1.删除原来的MySQL容器

docker rm -f mysql

# 2.进入root目录

cd ~

# 3.创建并运行新mysql容器,挂载本地目录

docker run -d \

--name mysql \

-p 3306:3306 \

-e TZ=Asia/Shanghai \

-e MYSQL_ROOT_PASSWORD=123 \

-v ./mysql/data:/var/lib/mysql \

-v ./mysql/conf:/etc/mysql/conf.d \

-v ./mysql/init:/docker-entrypoint-initdb.d \

mysql

# 4.查看root目录,可以发现~/mysql/data目录已经自动创建好了

ls -l mysql

# 结果:

总用量 4

drwxr-xr-x. 2 root root 20 5月 19 15:11 conf

drwxr-xr-x. 7 polkitd root 4096 5月 19 15:11 data

drwxr-xr-x. 2 root root 23 5月 19 15:11 init

# 查看data目录,会发现里面有大量数据库数据,说明数据库完成了初始化

ls -l data

# 5.查看MySQL容器内数据

# 5.1.进入MySQL

docker exec -it mysql mysql -uroot -p123

# 5.2.查看编码表

show variables like "%char%";

# 5.3.结果,发现编码是utf8mb4没有问题

+--------------------------+--------------------------------+

| Variable_name | Value |

+--------------------------+--------------------------------+

| character_set_client | utf8mb4 |

| character_set_connection | utf8mb4 |

| character_set_database | utf8mb4 |

| character_set_filesystem | binary |

| character_set_results | utf8mb4 |

| character_set_server | utf8mb4 |

| character_set_system | utf8mb3 |

| character_sets_dir | /usr/share/mysql-8.0/charsets/ |

+--------------------------+--------------------------------+

# 6.查看数据

# 6.1.查看数据库

show databases;

# 结果,hmall是黑马商城数据库

+--------------------+

| Database |

+--------------------+

| hmall |

| information_schema |

| mysql |

| performance_schema |

| sys |

+--------------------+

5 rows in set (0.00 sec)

# 6.2.切换到hmall数据库

use hmall;

# 6.3.查看表

show tables;

# 结果:

+-----------------+

| Tables_in_hmall |

+-----------------+

| address |

| cart |

| item |

| order |

| order_detail |

| order_logistics |

| pay_order |

| user |

+-----------------+

# 6.4.查看address表数据

+----+---------+----------+--------+----------+-------------+---------------+-----------+------------+-------+

| id | user_id | province | city | town | mobile | street | contact | is_default | notes |

+----+---------+----------+--------+----------+-------------+---------------+-----------+------------+-------+

| 59 | 1 | 北京 | 北京 | 朝阳区 | 13900112222 | 金燕龙办公楼 | 李佳诚 | 0 | NULL |

| 60 | 1 | 北京 | 北京 | 朝阳区 | 13700221122 | 修正大厦 | 李佳红 | 0 | NULL |

| 61 | 1 | 上海 | 上海 | 浦东新区 | 13301212233 | 航头镇航头路 | 李佳星 | 1 | NULL |

| 63 | 1 | 广东 | 佛山 | 永春 | 13301212233 | 永春武馆 | 李晓龙 | 0 | NULL |

+----+---------+----------+--------+----------+-------------+---------------+-----------+------------+-------+

4 rows in set (0.00 sec)docker run -d

--name mysql

-p 3309:3306

-e TZ=Asia/Shanghai

-e MYSQL_ROOT_PASSWORD=1

-v ./mysql/data:/var/lib/mysql

-v ./mysql/conf:/etc/mysql/conf.d

mysql

镜像

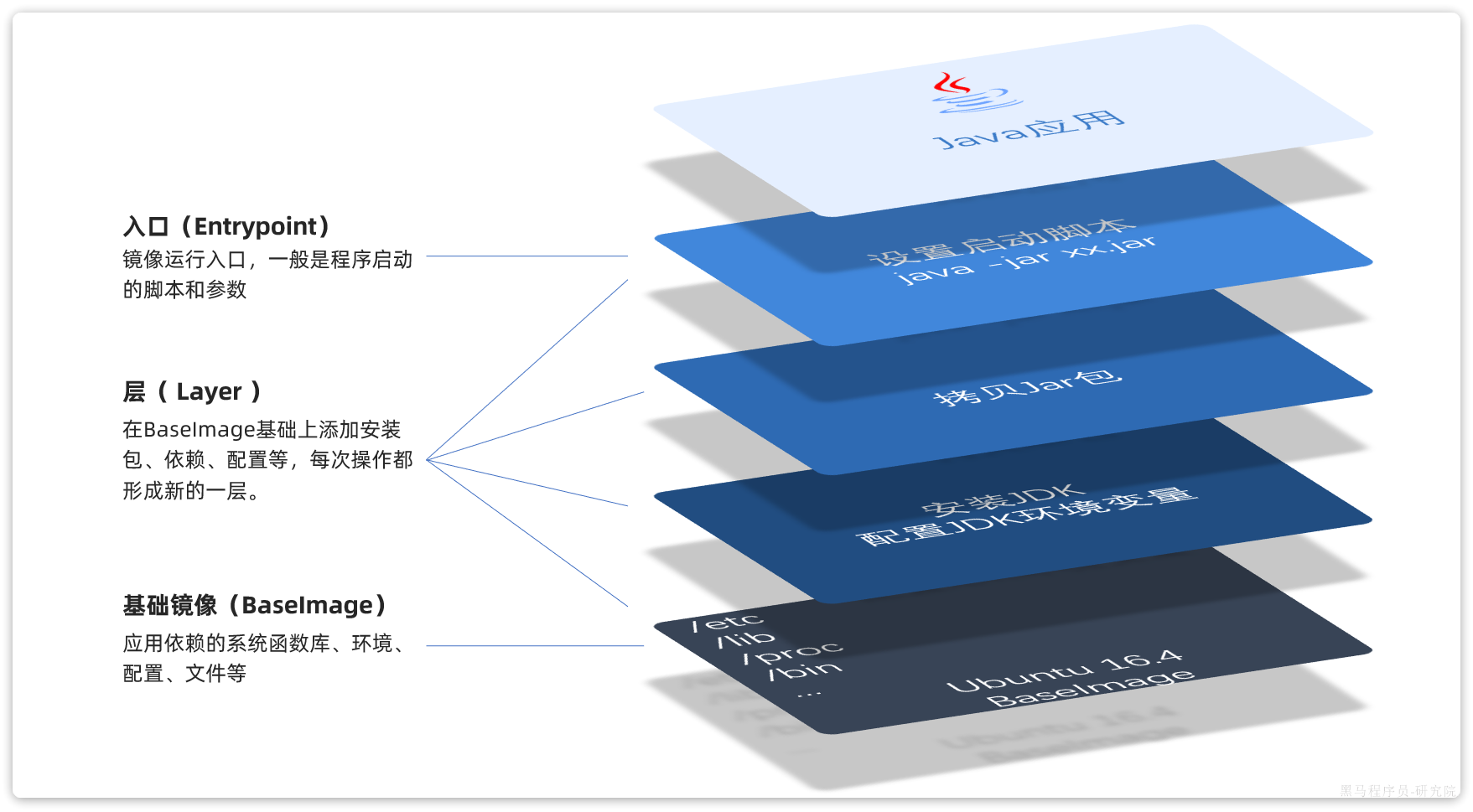

举个例子,要从0部署一个Java应用,大概流程是这样:

- 准备一个linux服务(CentOS或者Ubuntu均可)

- 安装并配置JDK

- 上传Jar包

- 运行jar包

那因此,打包镜像也是分成这么几步:

- 准备Linux运行环境(java项目并不需要完整的操作系统,仅仅是基础运行环境即可)

- 安装并配置JDK

- 拷贝jar包

- 配置启动脚本

上述步骤中的每一次操作其实都是在生产一些文件(系统运行环境、函数库、配置最终都是磁盘文件),所以镜像就是一堆文件的集合。

但需要注意的是,镜像文件不是随意堆放的,而是按照操作的步骤分层叠加而成,每一层形成的文件都会单独打包并标记一个唯一id,称为Layer(层)。这样,如果构建时用到的某些层其他人已经制作过,就可以直接拷贝使用这些层,而不用重复制作。

例如,第一步中需要的Linux运行环境,通用性就很强,所以Docker官方就制作了这样的只包含Linux运行环境的镜像。在制作java镜像时,就无需重复制作,直接使用Docker官方提供的CentOS或Ubuntu镜像作为基础镜像。然后再搭建其它层即可,这样逐层搭建,最终整个Java项目的镜像结构如图所示:

Dockerfile

由于制作镜像的过程中,需要逐层处理和打包,比较复杂,所以Docker就提供了自动打包镜像的功能。只需要将打包的过程,每一层要做的事情用固定的语法写下来,交给Docker去执行即可。

而这种记录镜像结构的文件就称为Dockerfile

Dockerfile reference | Docker Docs

| 指令 | 说明 | 示例 |

|---|---|---|

| FROM | 指定基础镜像 | FROM centos:6 |

| ENV | 设置环境变量,可在后面指令使用 | ENV key value |

| COPY | 拷贝本地文件到镜像的指定目录 | COPY ./xx.jar /tmp/app.jar |

| RUN | 执行Linux的shell命令,一般是安装过程的命令 | RUN yum install gcc |

| EXPOSE | 指定容器运行时监听的端口,是给镜像使用者看的 | EXPOSE 8080 |

| ENTRYPOINT | 镜像中应用的启动命令,容器运行时调用 | ENTRYPOINT java -jar xx.jar |

例如,要基于Ubuntu镜像来构建一个Java应用,其Dockerfile内容如下:

# 指定基础镜像

FROM ubuntu:16.04

# 配置环境变量,JDK的安装目录、容器内时区

ENV JAVA_DIR=/usr/local

ENV TZ=Asia/Shanghai

# 拷贝jdk和java项目的包

COPY ./jdk8.tar.gz $JAVA_DIR/

COPY ./docker-demo.jar /tmp/app.jar

# 设定时区

RUN ln -snf /usr/share/zoneinfo/$TZ /etc/localtime && echo $TZ > /etc/timezone

# 安装JDK

RUN cd $JAVA_DIR \

&& tar -xf ./jdk8.tar.gz \

&& mv ./jdk1.8.0_144 ./java8

# 配置环境变量

ENV JAVA_HOME=$JAVA_DIR/java8

ENV PATH=$PATH:$JAVA_HOME/bin

# 指定项目监听的端口

EXPOSE 8080

# 入口,java项目的启动命令

ENTRYPOINT ["java", "-jar", "/app.jar"]# 基础镜像

FROM openjdk:11.0-jre-buster

# 设定时区

ENV TZ=Asia/Shanghai

RUN ln -snf /usr/share/zoneinfo/$TZ /etc/localtime && echo $TZ > /etc/timezone

# 拷贝jar包

COPY docker-demo.jar /app.jar

# 入口

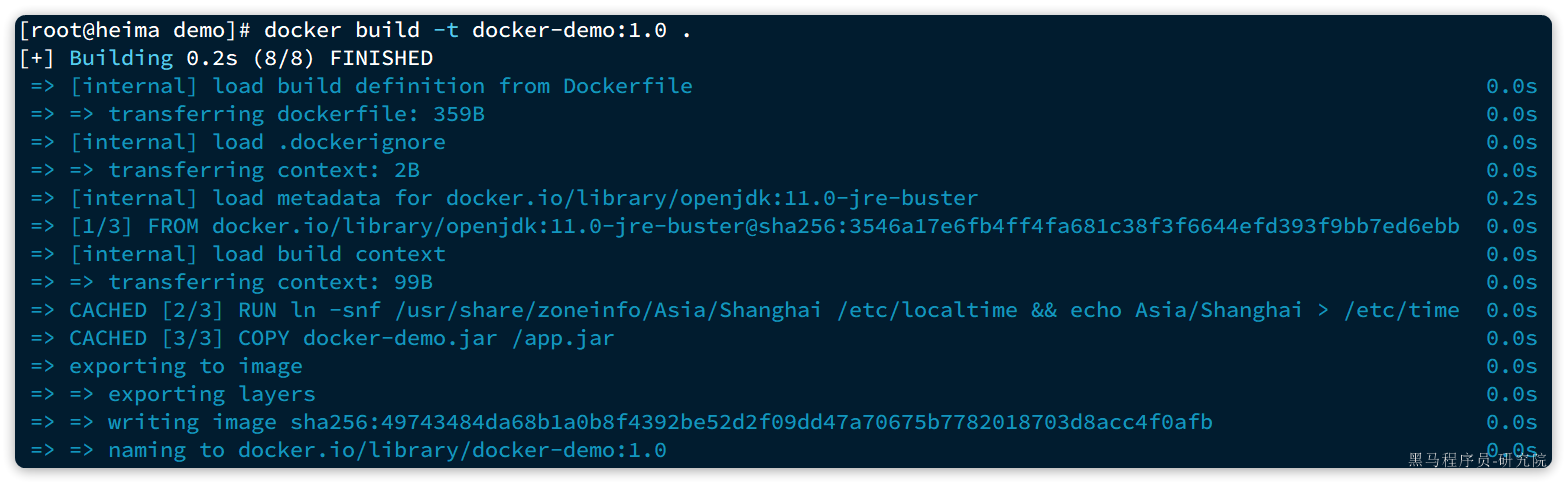

ENTRYPOINT ["java", "-jar", "/app.jar"]构建镜像

# 进入镜像目录

cd /root/demo

# 开始构建

docker build -t docker-demo:1.0 .命令说明:

docker build: 就是构建一个docker镜像-t docker-demo:1.0:-t参数是指定镜像的名称(repository和tag).: 最后的点是指构建时Dockerfile所在路径,由于进入了demo目录,所以指定的是.代表当前目录,也可以直接指定Dockerfile目录:# 直接指定Dockerfile目录 docker build -t docker-demo:1.0 /root/demo

结果:

查看镜像列表:

# 查看镜像列表:

docker images

# 结果

REPOSITORY TAG IMAGE ID CREATED SIZE

docker-demo 1.0 d6ab0b9e64b9 27 minutes ago 327MB

nginx latest 605c77e624dd 16 months ago 141MB

mysql latest 3218b38490ce 17 months ago 516MB网络

容器的网络IP其实是一个虚拟的IP,其值并不固定与某一个容器绑定,如果在开发时写死某个IP,而在部署时很可能MySQL容器的IP会发生变化,连接会失败。

| 命令 | 说明 | 文档地址 |

|---|---|---|

| docker network create | 创建一个网络 | docker network create |

| docker network ls | 查看所有网络 | docs.docker.com |

| docker network rm | 删除指定网络 | docs.docker.com |

| docker network prune | 清除未使用的网络 | docs.docker.com |

| docker network connect | 使指定容器连接加入某网络 | docs.docker.com |

| docker network disconnect | 使指定容器连接离开某网络 | docker network disconnect |

| docker network inspect | 查看网络详细信息 | docker network inspect |

自定义网络

# 1.首先通过命令创建一个网络

docker network create hmall

# 2.然后查看网络

docker network ls

# 结果:

NETWORK ID NAME DRIVER SCOPE

639bc44d0a87 bridge bridge local

403f16ec62a2 hmall bridge local

0dc0f72a0fbb host host local

cd8d3e8df47b none null local

# 其中,除了hmall以外,其它都是默认的网络

# 3.让dd和mysql都加入该网络,注意,在加入网络时可以通过--alias给容器起别名

# 这样该网络内的其它容器可以用别名互相访问!

# 3.1.mysql容器,指定别名为db,另外每一个容器都有一个别名是容器名

docker network connect hmall mysql --alias db

# 3.2.db容器,也就是的java项目

docker network connect hmall dd

# 4.进入dd容器,尝试利用别名访问db

# 4.1.进入容器

docker exec -it dd bash

# 4.2.用db别名访问

ping db

# 结果

PING db (172.18.0.2) 56(84) bytes of data.

64 bytes from mysql.hmall (172.18.0.2): icmp_seq=1 ttl=64 time=0.070 ms

64 bytes from mysql.hmall (172.18.0.2): icmp_seq=2 ttl=64 time=0.056 ms

# 4.3.用容器名访问

ping mysql

# 结果:

PING mysql (172.18.0.2) 56(84) bytes of data.

64 bytes from mysql.hmall (172.18.0.2): icmp_seq=1 ttl=64 time=0.044 ms

64 bytes from mysql.hmall (172.18.0.2): icmp_seq=2 ttl=64 time=0.054 ms总结:

- 在自定义网络中,可以给容器起多个别名,默认的别名是容器名本身

- 在同一个自定义网络中的容器,可以通过别名互相访问

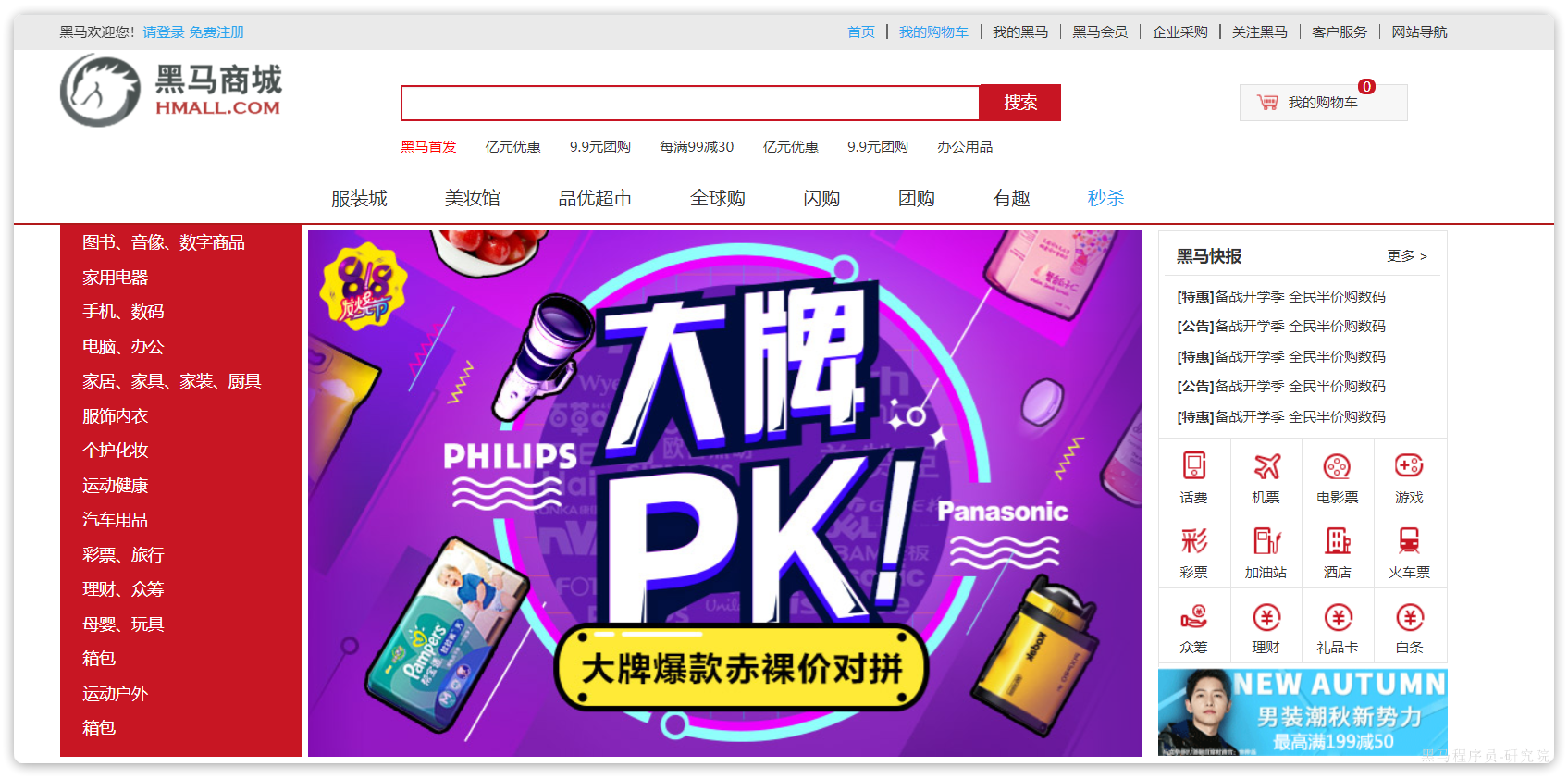

项目部署

项目说明:

- hmall:商城的后端代码

- hmall-portal:商城用户端的前端代码

- hmall-admin:商城管理端的前端代码

部署的容器及端口说明:

| 项目 | 容器名 | 端口 | 备注 |

|---|---|---|---|

| hmall | hmall | 8080 | 黑马商城后端API入口 |

| hmall-portal | nginx | 18080 | 黑马商城用户端入口 |

| hmall-admin | 18081 | 黑马商城管理端入口 | |

| mysql | mysql | 3306 | 数据库 |

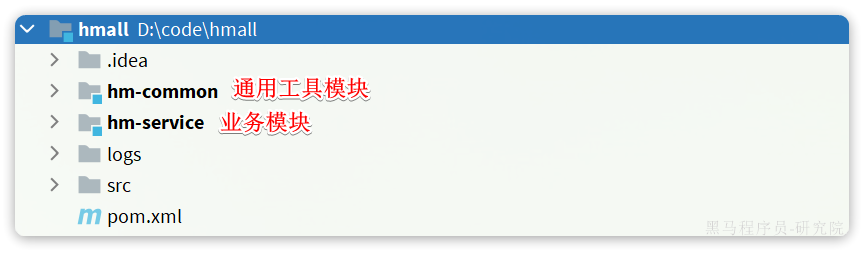

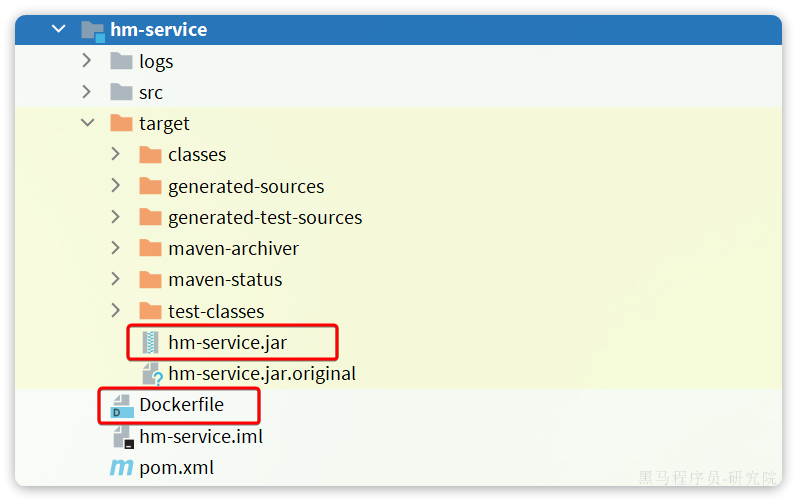

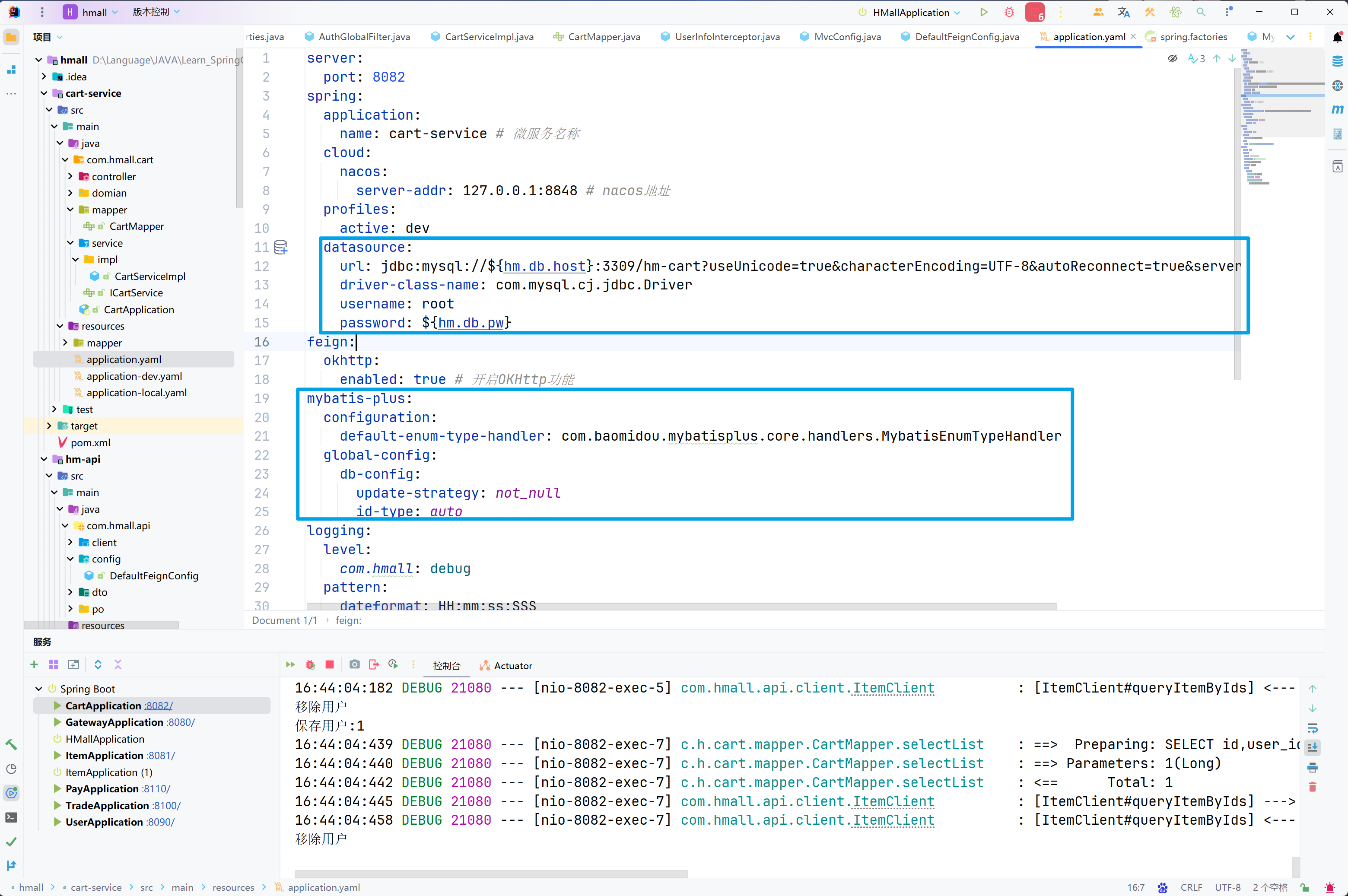

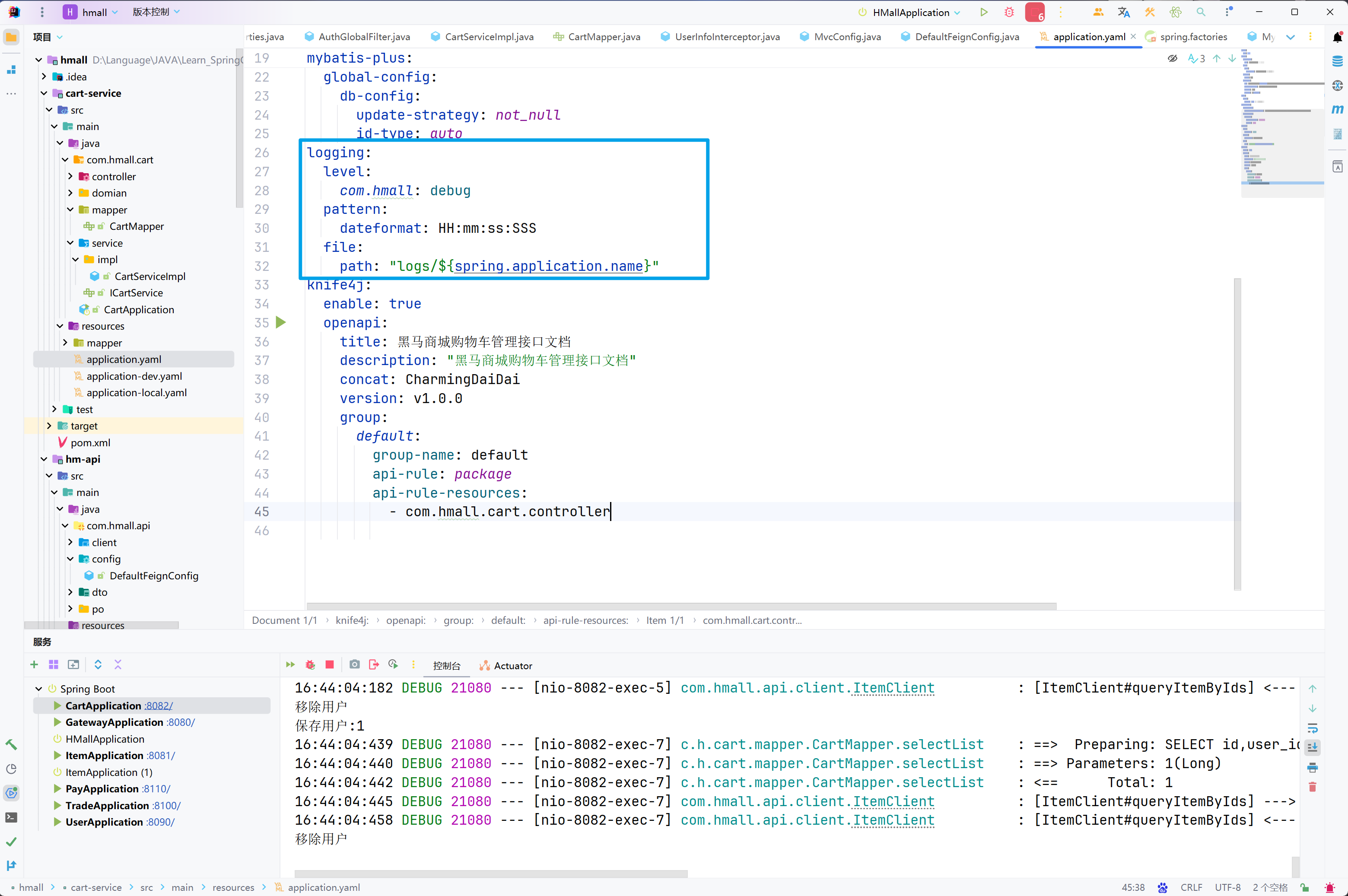

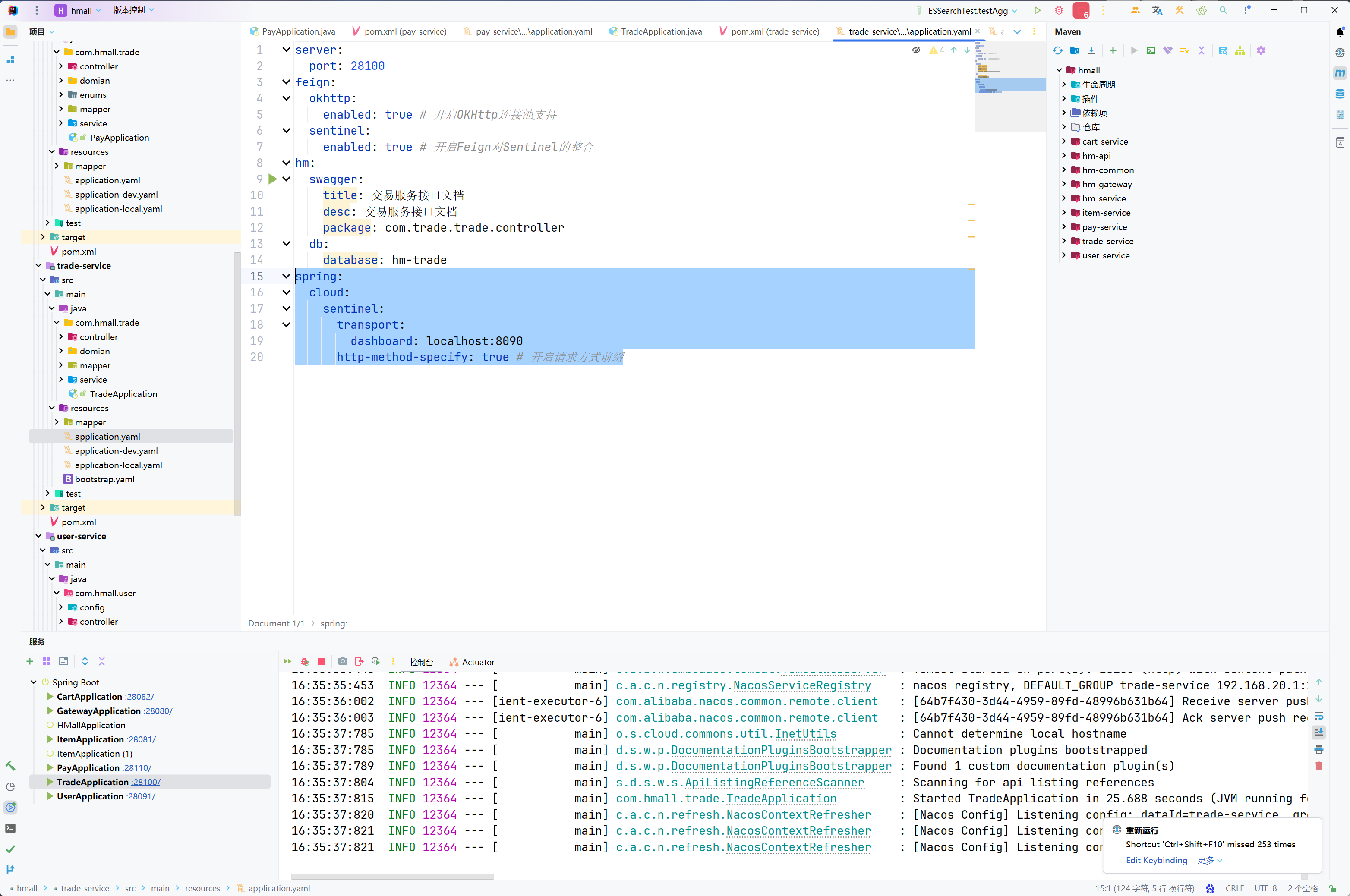

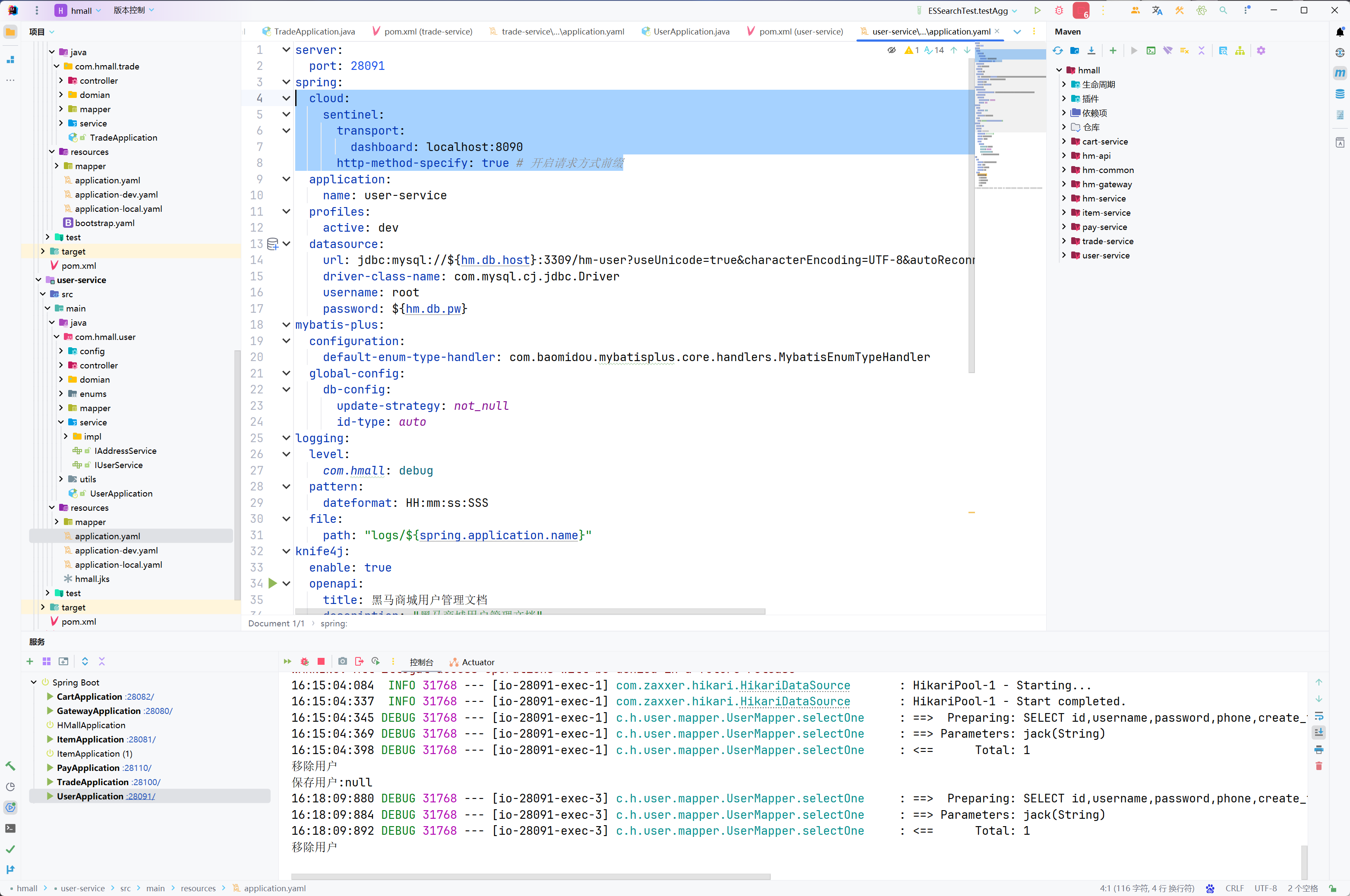

hmall项目是一个maven聚合项目,使用IDEA打开hmall项目,查看项目结构如图:

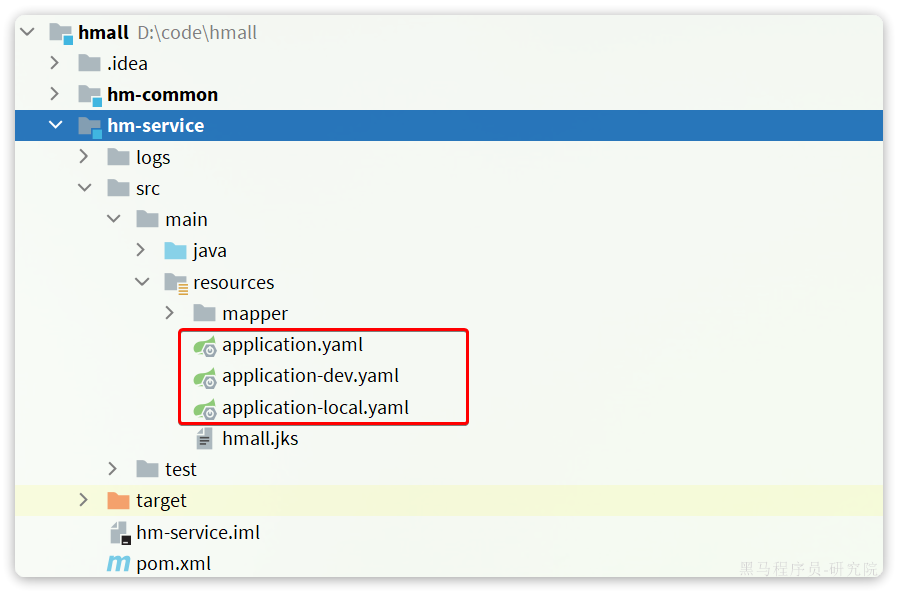

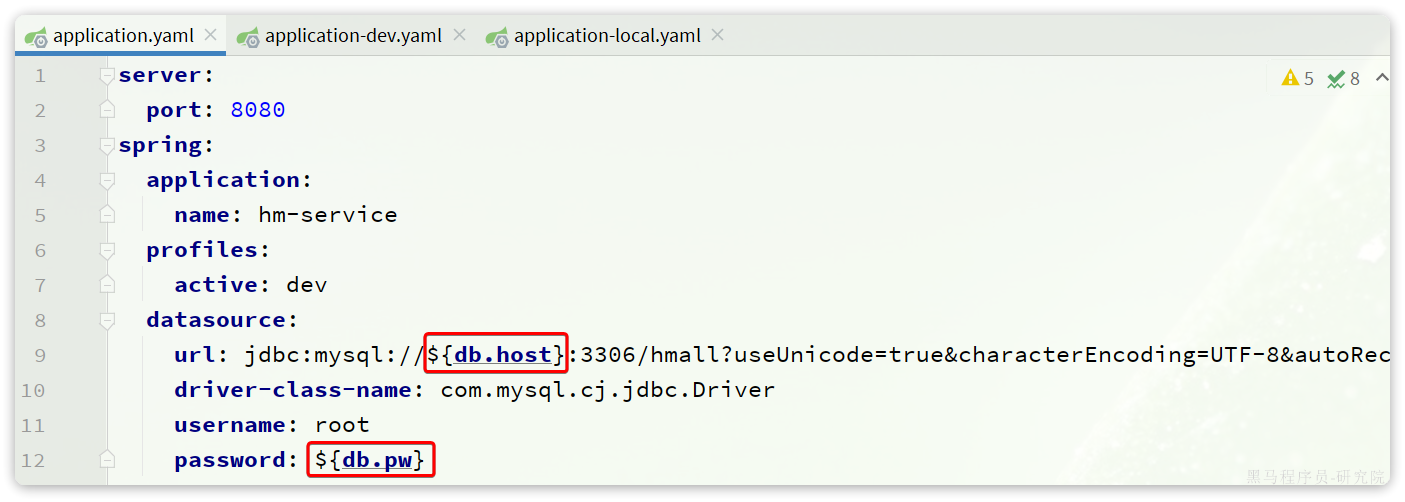

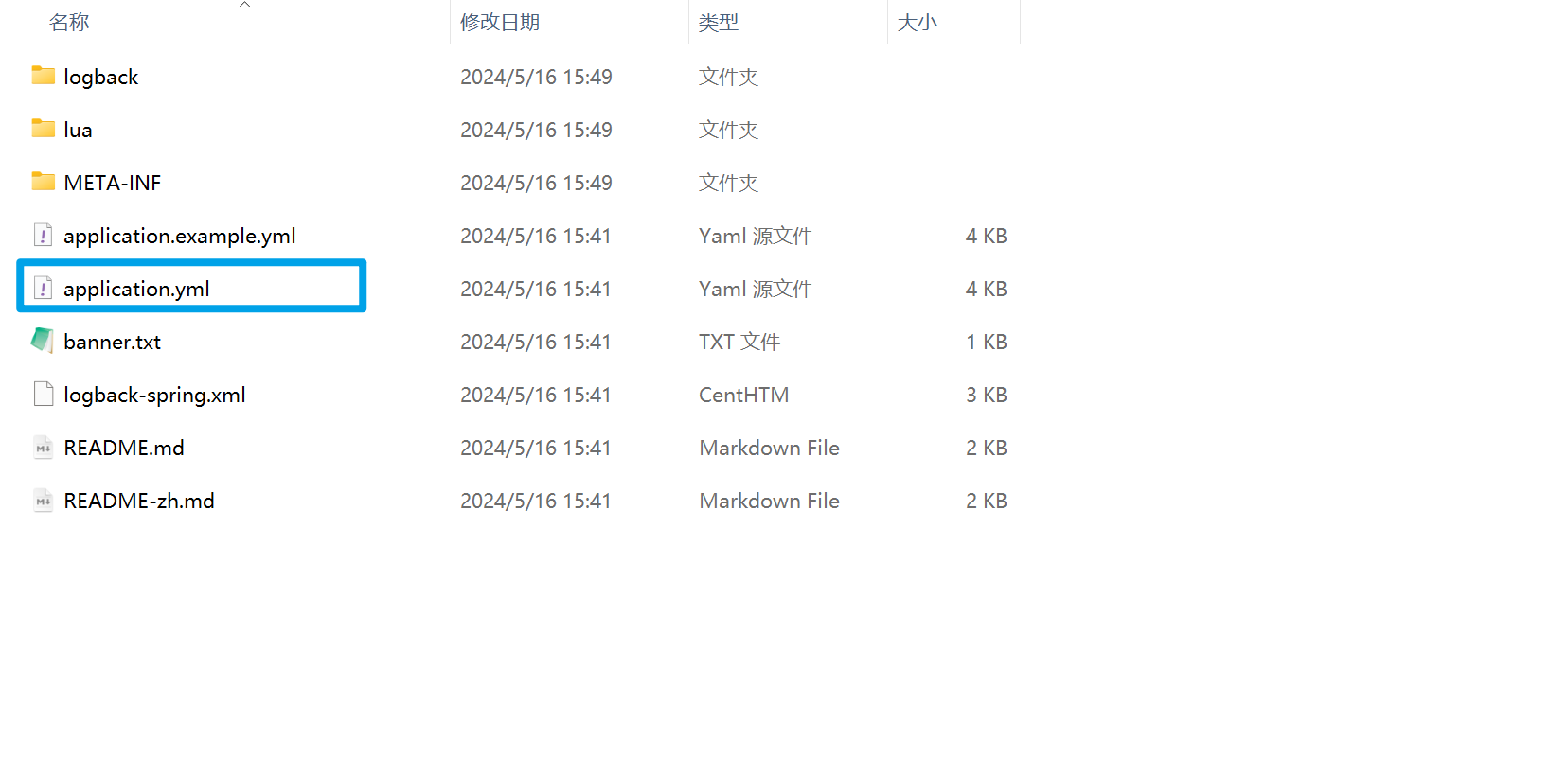

要部署的就是其中的hm-service,其中的配置文件采用了多环境的方式:

其中的application-dev.yaml是部署到开发环境的配置,application-local.yaml是本地运行时的配置。

查看application.yaml,你会发现其中的JDBC地址并未写死,而是读取变量:

这两个变量在application-dev.yaml和application-local.yaml中并不相同:

在dev开发环境(也就是Docker部署时)采用了mysql作为地址,刚好是的mysql容器名,只要两者在一个网络,就一定能互相访问。

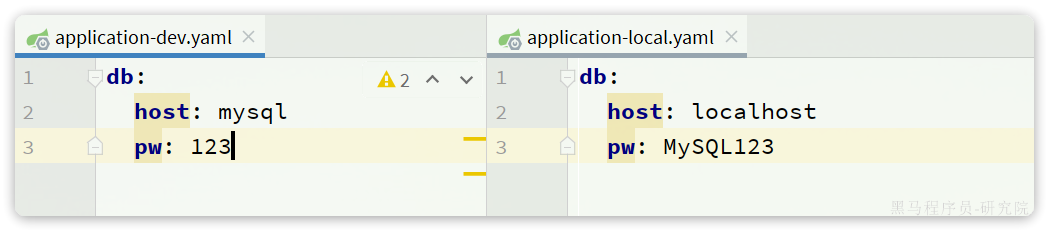

将项目打包:

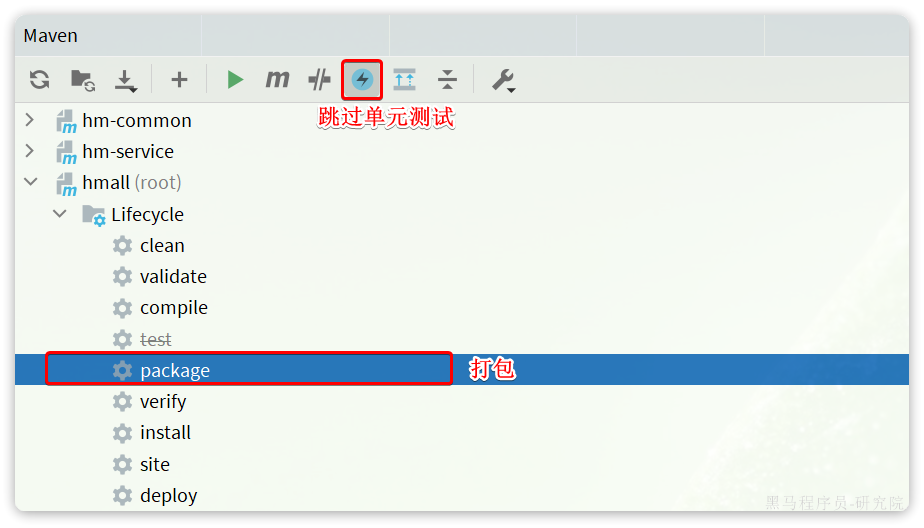

结果:

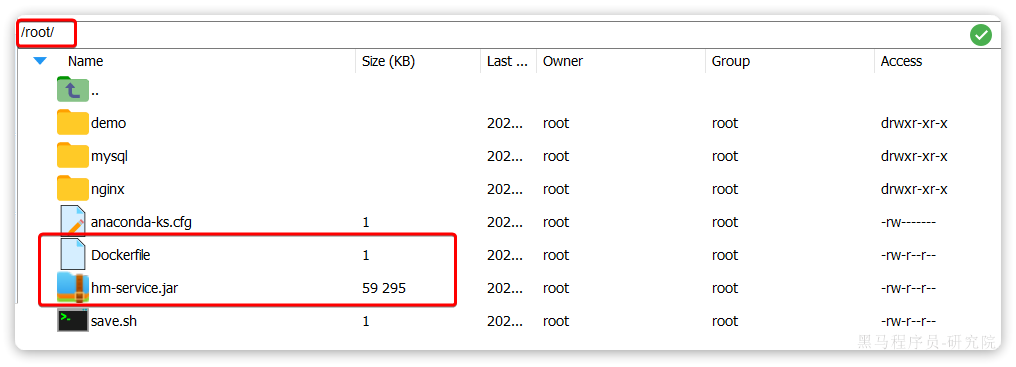

将hm-service目录下的Dockerfile和hm-service/target目录下的hm-service.jar一起上传到虚拟机的root目录:

部署项目:

# 1.构建项目镜像,不指定tag,则默认为latest

docker build -t hmall .

# 2.查看镜像

docker images

# 结果

REPOSITORY TAG IMAGE ID CREATED SIZE

hmall latest 0bb07b2c34b9 43 seconds ago 362MB

docker-demo 1.0 49743484da68 24 hours ago 327MB

nginx latest 605c77e624dd 16 months ago 141MB

mysql latest 3218b38490ce 17 months ago 516MB

# 3.创建并运行容器,并通过--network将其加入hmall网络,这样才能通过容器名访问mysql

docker run -d --name hmall --network hmall -p 8080:8080 hmall测试,通过浏览器访问:http://你的虚拟机地址:8080/search/list

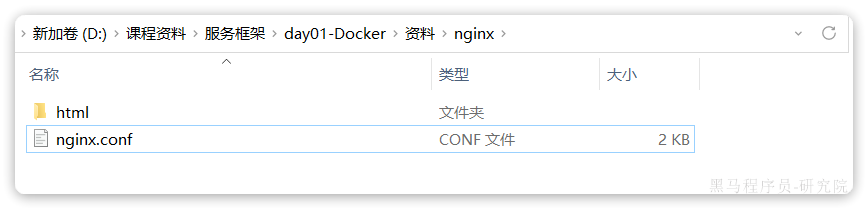

hmall-portal和hmall-admin是前端代码,需要基于nginx部署。在课前资料中已经给大家提供了nginx的部署目录:

其中:

html是静态资源目录,需要把hmall-portal以及hmall-admin都复制进去nginx.conf是nginx的配置文件,主要是完成对html下的两个静态资源目录做代理

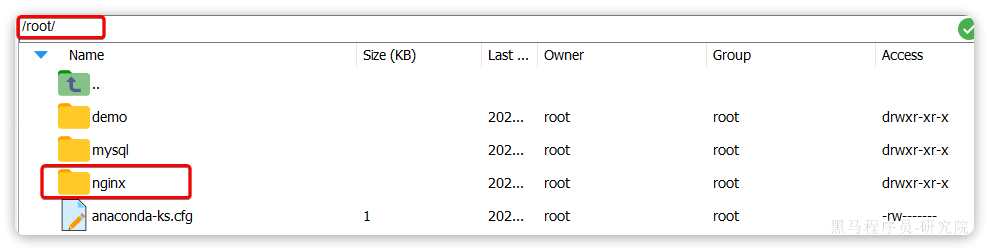

现在要做的就是把整个nginx目录上传到虚拟机的/root目录下:

然后创建nginx容器并完成两个挂载:

- 把

/root/nginx/nginx.conf挂载到/etc/nginx/nginx.conf - 把

/root/nginx/html挂载到/usr/share/nginx/html

由于需要让nginx同时代理hmall-portal和hmall-admin两套前端资源,因此需要暴露两个端口:

- 18080:对应hmall-portal

- 18081:对应hmall-admin

命令如下:

docker run -d \

--name nginx \

-p 18080:18080 \

-p 18081:18081 \

-v /root/nginx/html:/usr/share/nginx/html \

-v /root/nginx/nginx.conf:/etc/nginx/nginx.conf \

--network hmall \

nginx测试,通过浏览器访问:http://你的虚拟机ip:18080

DockerCompose

docker-compose文件中可以定义多个相互关联的应用容器,每一个应用容器被称为一个服务(service)。由于service就是在定义某个应用的运行时参数,因此与docker run参数非常相似。

docker run -d \

--name mysql \

-p 3309:3306 \

-e TZ=Asia/Shanghai \

-e MYSQL_ROOT_PASSWORD=1 \

-v ./mysql/data:/var/lib/mysql \

-v ./mysql/conf:/etc/mysql/conf.d \

-v ./mysql/init:/docker-entrypoint-initdb.d \

--network hm-net \

mysqlversion: "3.8"

services:

mysql:

image: mysql

container_name: mysql

ports:

- "3306:3306"

environment:

TZ: Asia/Shanghai

MYSQL_ROOT_PASSWORD: 123

volumes:

- "./mysql/conf:/etc/mysql/conf.d"

- "./mysql/data:/var/lib/mysql"

networks:

- new

networks:

new:

name: hmall| docker run 参数 | docker compose 指令 | 说明 |

|---|---|---|

| --name | container_name | 容器名称 |

| -p | ports | 端口映射 |

| -e | environment | 环境变量 |

| -v | volumes | 数据卷配置 |

| --network | networks | 网络 |

version: "3.8"

services:

mysql:

image: mysql

container_name: mysql

ports:

- "3306:3306"

environment:

TZ: Asia/Shanghai

MYSQL_ROOT_PASSWORD: 123

volumes:

- "./mysql/conf:/etc/mysql/conf.d"

- "./mysql/data:/var/lib/mysql"

- "./mysql/init:/docker-entrypoint-initdb.d"

networks:

- hm-net

hmall:

build:

context: .

dockerfile: Dockerfile

container_name: hmall

ports:

- "8080:8080"

networks:

- hm-net

depends_on:

- mysql

nginx:

image: nginx

container_name: nginx

ports:

- "18080:18080"

- "18081:18081"

volumes:

- "./nginx/nginx.conf:/etc/nginx/nginx.conf"

- "./nginx/html:/usr/share/nginx/html"

depends_on:

- hmall

networks:

- hm-net

networks:

hm-net:

name: hmallOverview of docker compose CLI | Docker Docs

docker compose [OPTIONS] [COMMAND]| 类型 | 参数或指令 | 说明 |

|---|---|---|

| Options | -f | 指定compose文件的路径和名称 |

| -p | 指定project名称。project就是当前compose文件中设置的多个service的集合,是逻辑概念 | |

| Commands | up | 创建并启动所有service容器 |

| down | 停止并移除所有容器、网络 | |

| ps | 列出所有启动的容器 | |

| logs | 查看指定容器的日志 | |

| stop | 停止容器 | |

| start | 启动容器 | |

| restart | 重启容器 | |

| top | 查看运行的进程 | |

| exec | 在指定的运行中容器中执行命令 |

认识微服务

单体架构

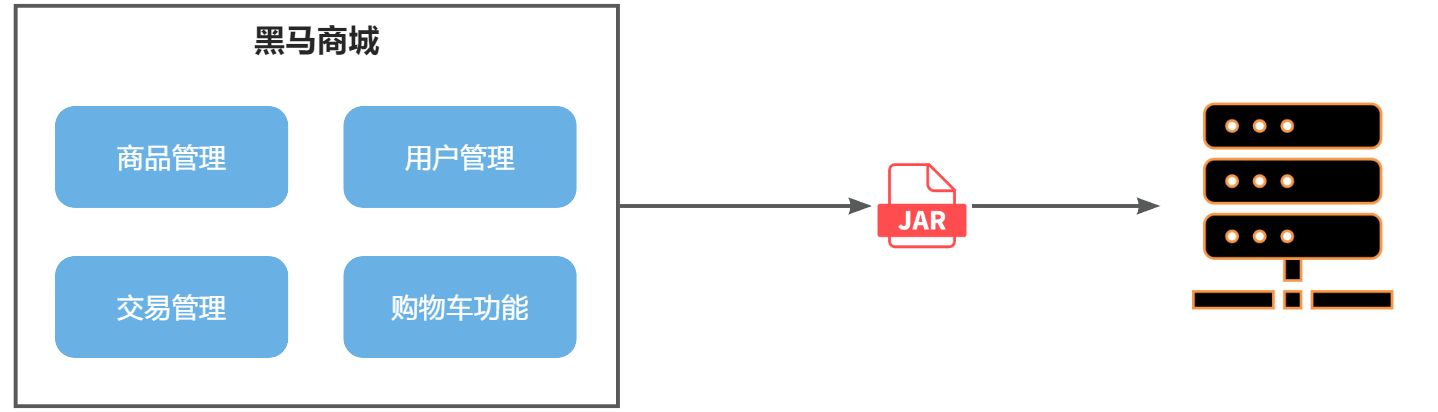

单体架构(monolithic structure):顾名思义,整个项目中所有功能模块都在一个工程中开发;项目部署时需要对所有模块一起编译、打包;项目的架构设计、开发模式都非常简单。

当项目规模较小时,这种模式上手快,部署、运维也都很方便,因此早期很多小型项目都采用这种模式。

但随着项目的业务规模越来越大,团队开发人员也不断增加,单体架构就呈现出越来越多的问题:

- 团队协作成本高:试想一下,你们团队数十个人同时协作开发同一个项目,由于所有模块都在一个项目中,不同模块的代码之间物理边界越来越模糊。最终要把功能合并到一个分支,你绝对会陷入到解决冲突的泥潭之中。

- 系统发布效率低:任何模块变更都需要发布整个系统,而系统发布过程中需要多个模块之间制约较多,需要对比各种文件,任何一处出现问题都会导致发布失败,往往一次发布需要数十分钟甚至数小时。

- 系统可用性差:单体架构各个功能模块是作为一个服务部署,相互之间会互相影响,一些热点功能会耗尽系统资源,导致其它服务低可用。

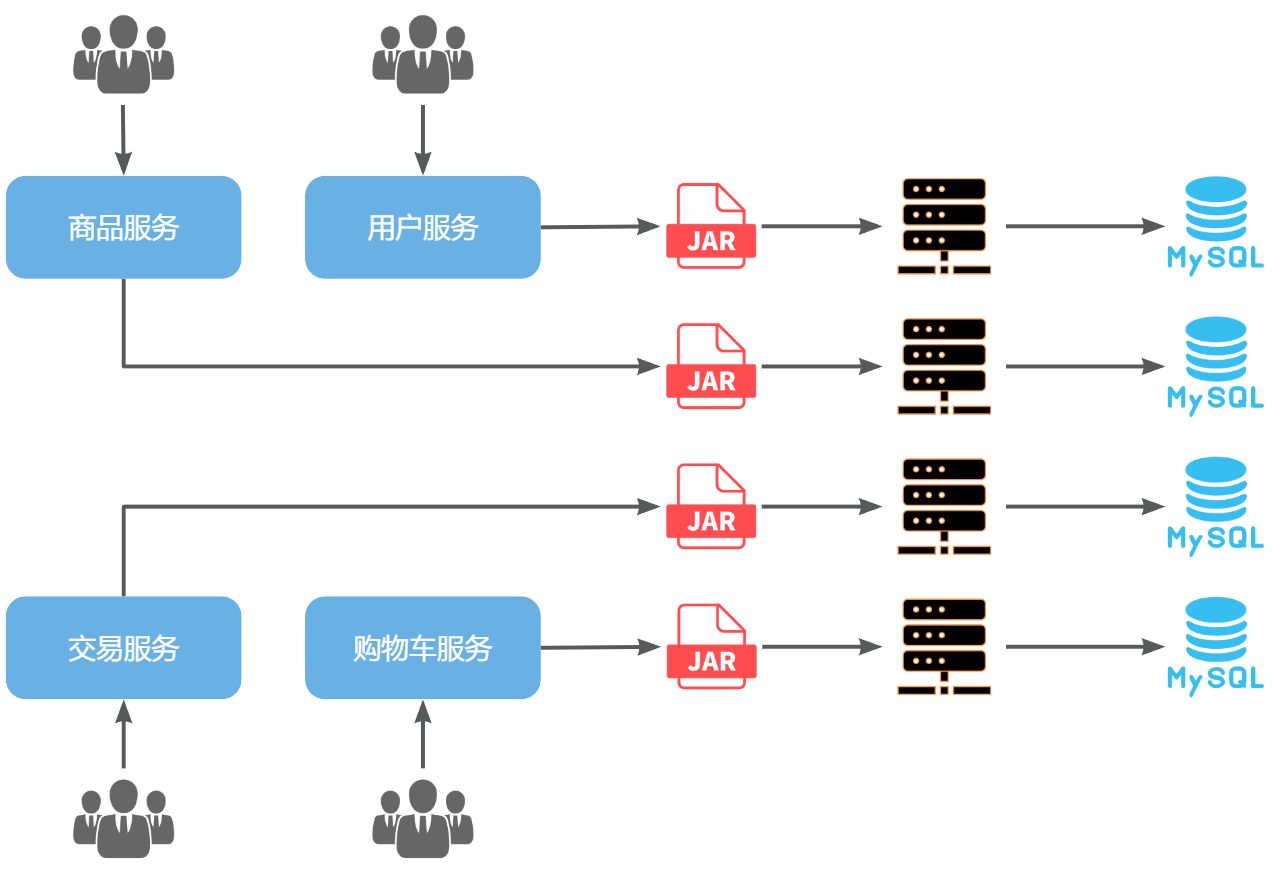

微服务

微服务架构,首先是服务化,就是将单体架构中的功能模块从单体应用中拆分出来,独立部署为多个服务。同时要满足下面的一些特点:

- 单一职责:一个微服务负责一部分业务功能,并且其核心数据不依赖于其它模块。

- 团队自治:每个微服务都有自己独立的开发、测试、发布、运维人员,团队人员规模不超过10人(2张披萨能喂饱)

- 服务自治:每个微服务都独立打包部署,访问自己独立的数据库。并且要做好服务隔离,避免对其它服务产生影响

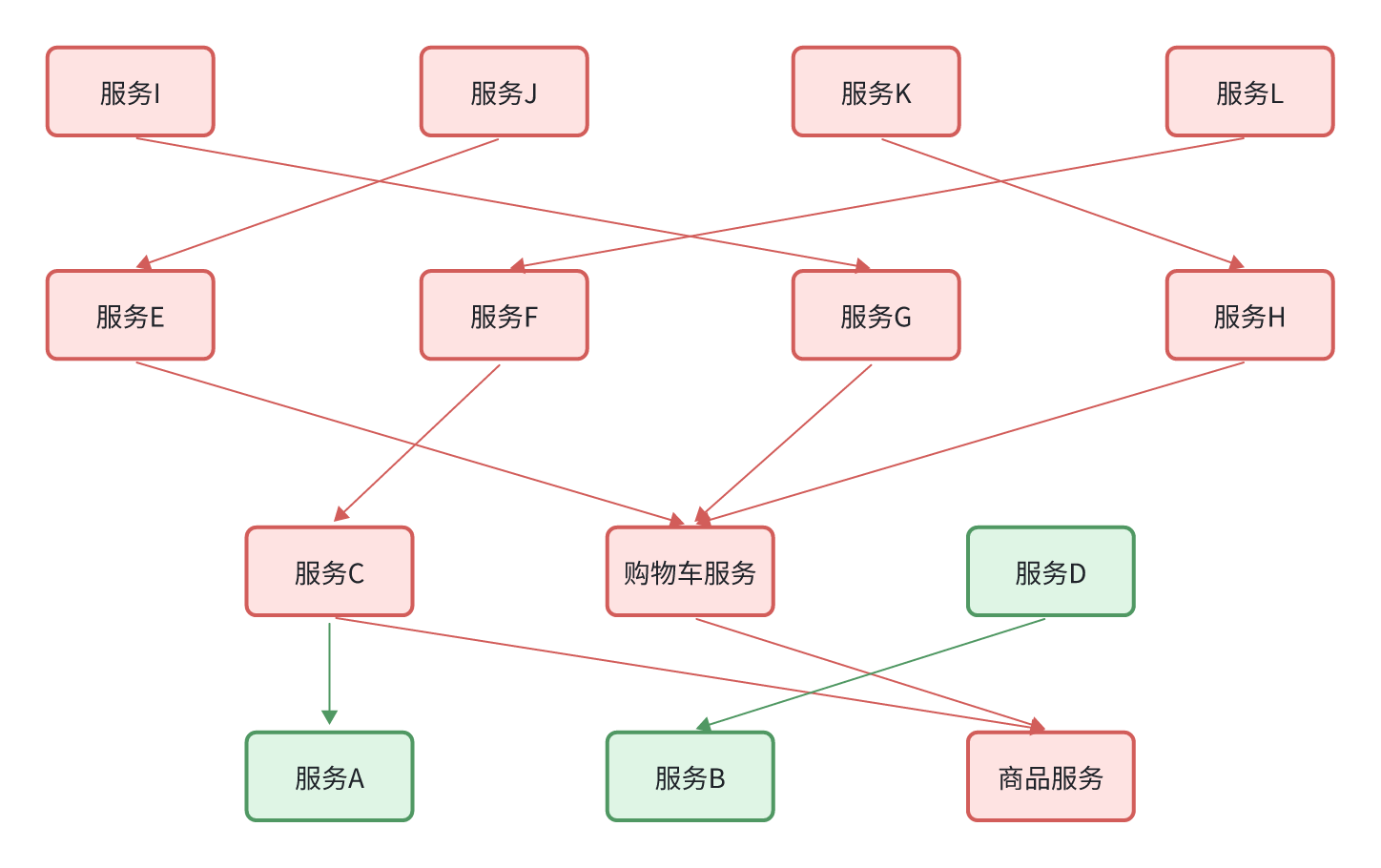

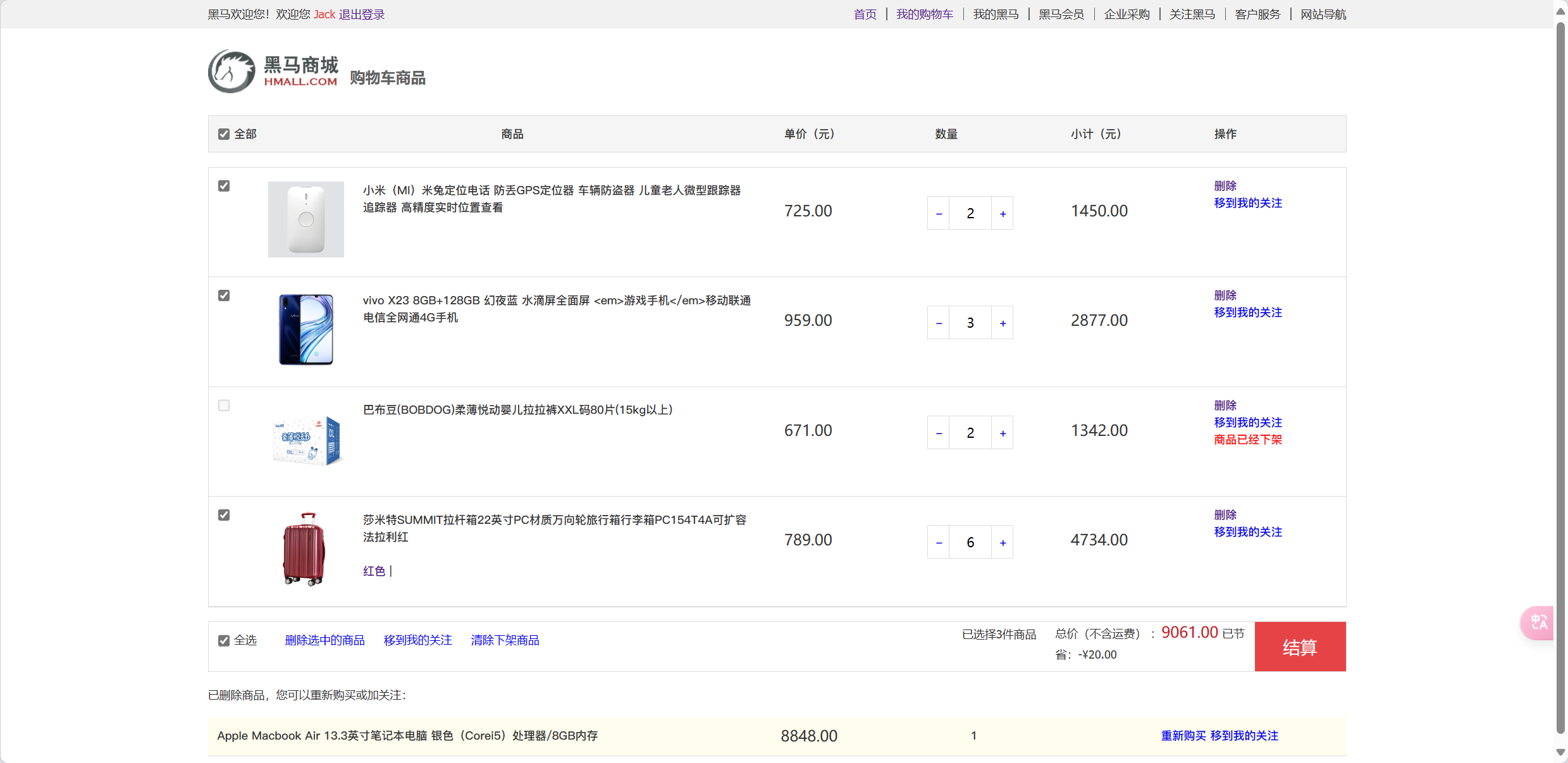

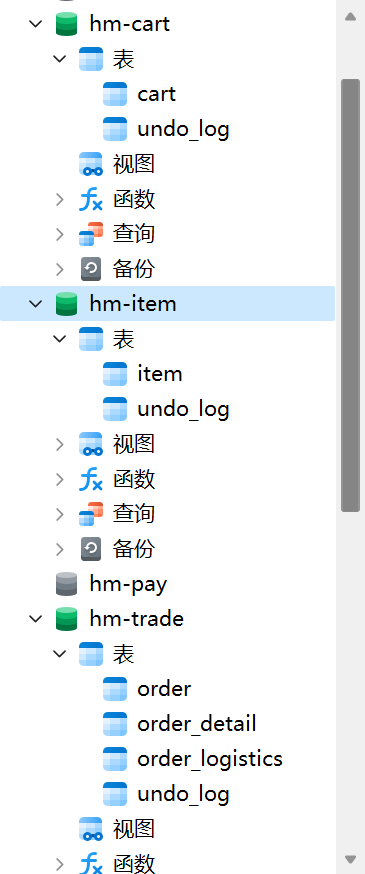

例如,黑马商城项目,就可以把商品、用户、购物车、交易等模块拆分,交给不同的团队去开发,并独立部署:

那么,单体架构存在的问题有没有解决呢?

- 团队协作成本高?

- 由于服务拆分,每个服务代码量大大减少,参与开发的后台人员在1~3名,协作成本大大降低

- 系统发布效率低?

- 每个服务都是独立部署,当有某个服务有代码变更时,只需要打包部署该服务即可

- 系统可用性差?

- 每个服务独立部署,并且做好服务隔离,使用自己的服务器资源,不会影响到其它服务。

综上所述,微服务架构解决了单体架构存在的问题,特别适合大型互联网项目的开发,因此被各大互联网公司普遍采用。大家以前可能听说过分布式架构,分布式就是服务拆分的过程,其实微服务架构正式分布式架构的一种最佳实践的方案。

当然,微服务架构虽然能解决单体架构的各种问题,但在拆分的过程中,还会面临很多其它问题。比如:

- 如果出现跨服务的业务该如何处理?

- 页面请求到底该访问哪个服务?

- 如何实现各个服务之间的服务隔离?

SpringCloud

而且SpringCloud依托于SpringBoot的自动装配能力,大大降低了其项目搭建、组件使用的成本。对于没有自研微服务组件能力的中小型企业,使用SpringCloud全家桶来实现微服务开发可以说是最合适的选择了!

目前SpringCloud最新版本为2022.0.x版本,对应的SpringBoot版本为3.x版本,但它们全部依赖于JDK17,目前在企业中使用相对较少。

| SpringCloud版本 | SpringBoot版本 |

|---|---|

| 2022.0.x aka Kilburn | 3.0.x |

| 2021.0.x aka Jubilee | 2.6.x, 2.7.x (Starting with 2021.0.3) |

| 2020.0.x aka Ilford | 2.4.x, 2.5.x (Starting with 2020.0.3) |

| Hoxton | 2.2.x, 2.3.x (Starting with SR5) |

| Greenwich | 2.1.x |

| Finchley | 2.0.x |

| Edgware | 1.5.x |

| Dalston | 1.5.x |

因此,推荐使用次新版本:Spring Cloud 2021.0.x以及Spring Boot 2.7.x版本。

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.heima</groupId>

<artifactId>hmall</artifactId>

<packaging>pom</packaging>

<version>1.0.0</version>

<modules>

<module>hm-common</module>

<module>hm-service</module>

</modules>

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.7.12</version>

<relativePath/>

</parent>

<properties>

<maven.compiler.source>11</maven.compiler.source>

<maven.compiler.target>11</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding>

<org.projectlombok.version>1.18.20</org.projectlombok.version>

<spring-cloud.version>2021.0.3</spring-cloud.version>

<spring-cloud-alibaba.version>2021.0.4.0</spring-cloud-alibaba.version>

<mybatis-plus.version>3.4.3</mybatis-plus.version>

<hutool.version>5.8.11</hutool.version>

<mysql.version>8.0.23</mysql.version>

</properties>

<!-- 对依赖包进行管理 -->

<dependencyManagement>

<dependencies>

<!--spring cloud-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-dependencies</artifactId>

<version>${spring-cloud.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!--spring cloud alibaba-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-alibaba-dependencies</artifactId>

<version>${spring-cloud-alibaba.version}</version>

<type>pom</type>

<scope>import</scope>

</dependency>

<!-- 数据库驱动包管理 -->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>${mysql.version}</version>

</dependency>

<!-- mybatis plus 管理 -->

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus-boot-starter</artifactId>

<version>${mybatis-plus.version}</version>

</dependency>

<!--hutool工具包-->

<dependency>

<groupId>cn.hutool</groupId>

<artifactId>hutool-all</artifactId>

<version>${hutool.version}</version>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<!-- lombok 管理 -->

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>${org.projectlombok.version}</version>

</dependency>

<!--单元测试-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

</dependencies>

<build>

<pluginManagement>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.8.1</version>

<configuration>

<source>11</source> <!-- depending on your project -->

<target>11</target> <!-- depending on your project -->

</configuration>

</plugin>

</plugins>

</pluginManagement>

</build>

</project>微服务拆分

什么时候拆

一般情况下,对于一个初创的项目,首先要做的是验证项目的可行性。因此这一阶段的首要任

务是敏捷开发,快速产出生产可用的产品,投入市场做验证。为了达成这一目的,该阶段项目

架构往往会比较简单,很多情况下会直接采用单体架构,这样开发成本比较低,可以快速产出

结果,一旦发现项目不符合市场,损失较小。

如果这一阶段采用复杂的微服务架构,投入大量的人力和时间成本用于架构设计,最终发现产

品不符合市场需求,等于全部做了无用功。

所以,对于大多数小型项目来说,一般是先采用单体架构,随着用户规模扩大、业务复杂后再

逐渐拆分为微服务架构。这样初期成本会比较低,可以快速试错。但是,这么做的问题就在于

后期做服务拆分时,可能会遇到很多代码耦合带来的问题,拆分比较困难(前易后难)。

而对于一些大型项目,在立项之初目的就很明确,为了长远考虑,在架构设计时就直接选择微

服务架构。虽然前期投入较多,但后期就少了拆分服务的烦恼(前难后易)。

之前说过,微服务拆分时粒度要小,这其实是拆分的目标。具体可以从两个角度来分析:

- 高内聚:每个微服务的职责要尽量单一,包含的业务相互关联度高、完整度高。

- 低耦合:每个微服务的功能要相对独立,尽量减少对其它微服务的依赖,或者依赖接口的稳定性要强。

明确了拆分目标,接下来就是拆分方式了。在做服务拆分时一般有两种方式:

- 纵向拆分

- 横向拆分

所谓纵向拆分,就是按照项目的功能模块来拆分。例如黑马商城中,就有用户管理功能、订单管理功能、购物车功能、商品管理功能、支付功能等。那么按照功能模块将他们拆分为一个个服务,就属于纵向拆分。这种拆分模式可以尽可能提高服务的内聚性。

而横向拆分,是看各个功能模块之间有没有公共的业务部分,如果有将其抽取出来作为通用服务。例如用户登录是需要发送消息通知,记录风控数据,下单时也要发送短信,记录风控数据。因此消息发送、风控数据记录就是通用的业务功能,因此可以将他们分别抽取为公共服务:消息中心服务、风控管理服务。这样可以提高业务的复用性,避免重复开发。同时通用业务一般接口稳定性较强,也不会使服务之间过分耦合。

远程调用

Spring提供了一个RestTemplate的API,可以方便的实现Http请求的发送。

先将RestTemplate注册为一个Bean:

package com.hmall.cart.config;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.web.client.RestTemplate;

@Configuration

public class RemoteCallConfig {

@Bean

public RestTemplate restTemplate() {

return new RestTemplate();

}

}CartServiceImpl

private void handleCartItems(List<CartVO> vos) {

// 1.获取商品id

Set<Long> itemIds = vos.stream().map(CartVO::getItemId).collect(Collectors.toSet());

// 2.查询商品

// List<ItemDTO> items = itemService.queryItemByIds(itemIds);

// 通过调用http请求获取

ResponseEntity<List<ItemDTO>> response = restTemplate.exchange(

"http://localhost:8081/items={ids}",

HttpMethod.GET,

null,

new ParameterizedTypeReference<List<ItemDTO>>() {

},

Map.of("ids", CollectionUtil.join(itemIds, ","))

);

// 解析数据

if (!response.getStatusCode().is2xxSuccessful()) {

return;

}

List<ItemDTO> items = response.getBody();

if (CollUtils.isEmpty(items)) {

return;

}

// 3.转为 id 到 item的map

Map<Long, ItemDTO> itemMap = items.stream().collect(Collectors.toMap(ItemDTO::getId, Function.identity()));

// 4.写入vo

for (CartVO v : vos) {

ItemDTO item = itemMap.get(v.getItemId());

if (item == null) {

continue;

}

v.setNewPrice(item.getPrice());

v.setStatus(item.getStatus());

v.setStock(item.getStock());

}

}服务治理

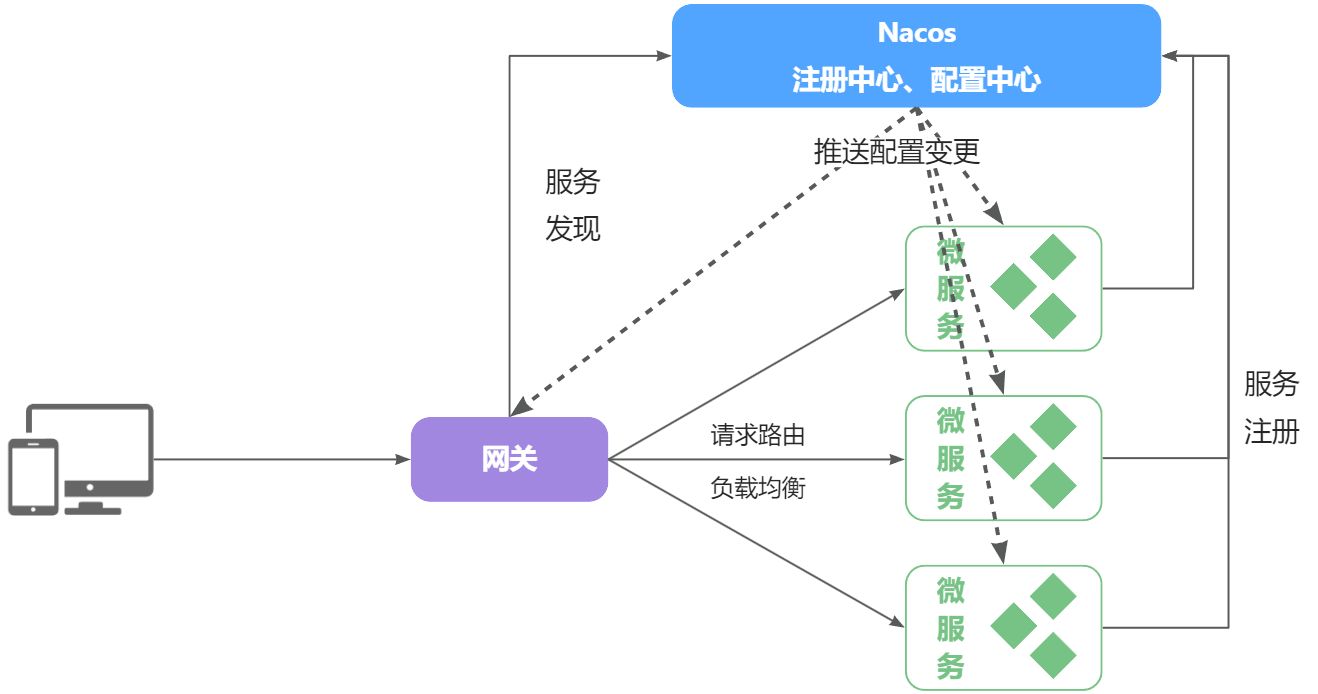

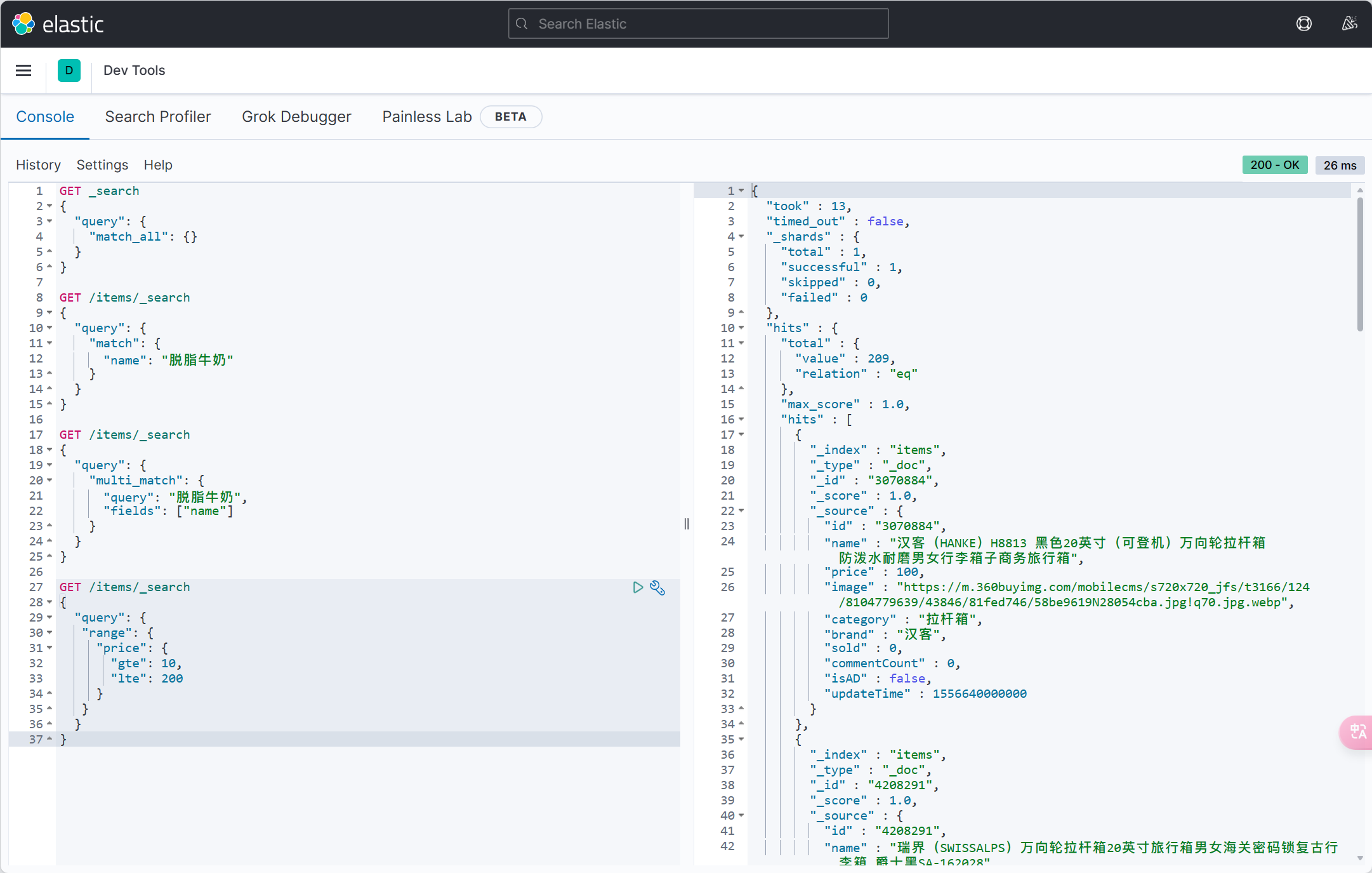

注册中心

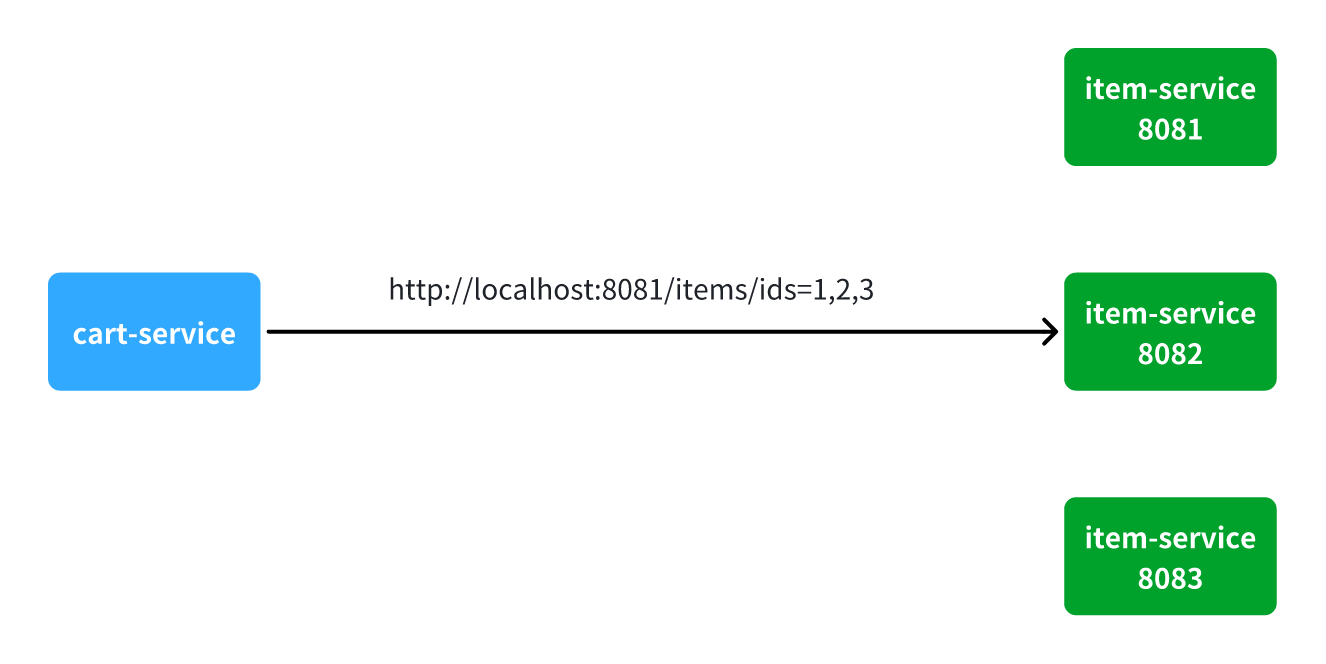

试想一下,假如商品微服务被调用较多,为了应对更高的并发,进行了多实例部署,如图:

此时,每个item-service的实例其IP或端口不同,问题来了:

- item-service这么多实例,cart-service如何知道每一个实例的地址?

- http请求要写url地址,

cart-service服务到底该调用哪个实例呢? - 如果在运行过程中,某一个

item-service实例宕机,cart-service依然在调用该怎么办? - 如果并发太高,

item-service临时多部署了N台实例,cart-service如何知道新实例的地址?

为了解决上述问题,就必须引入注册中心的概念了

注册中心原理

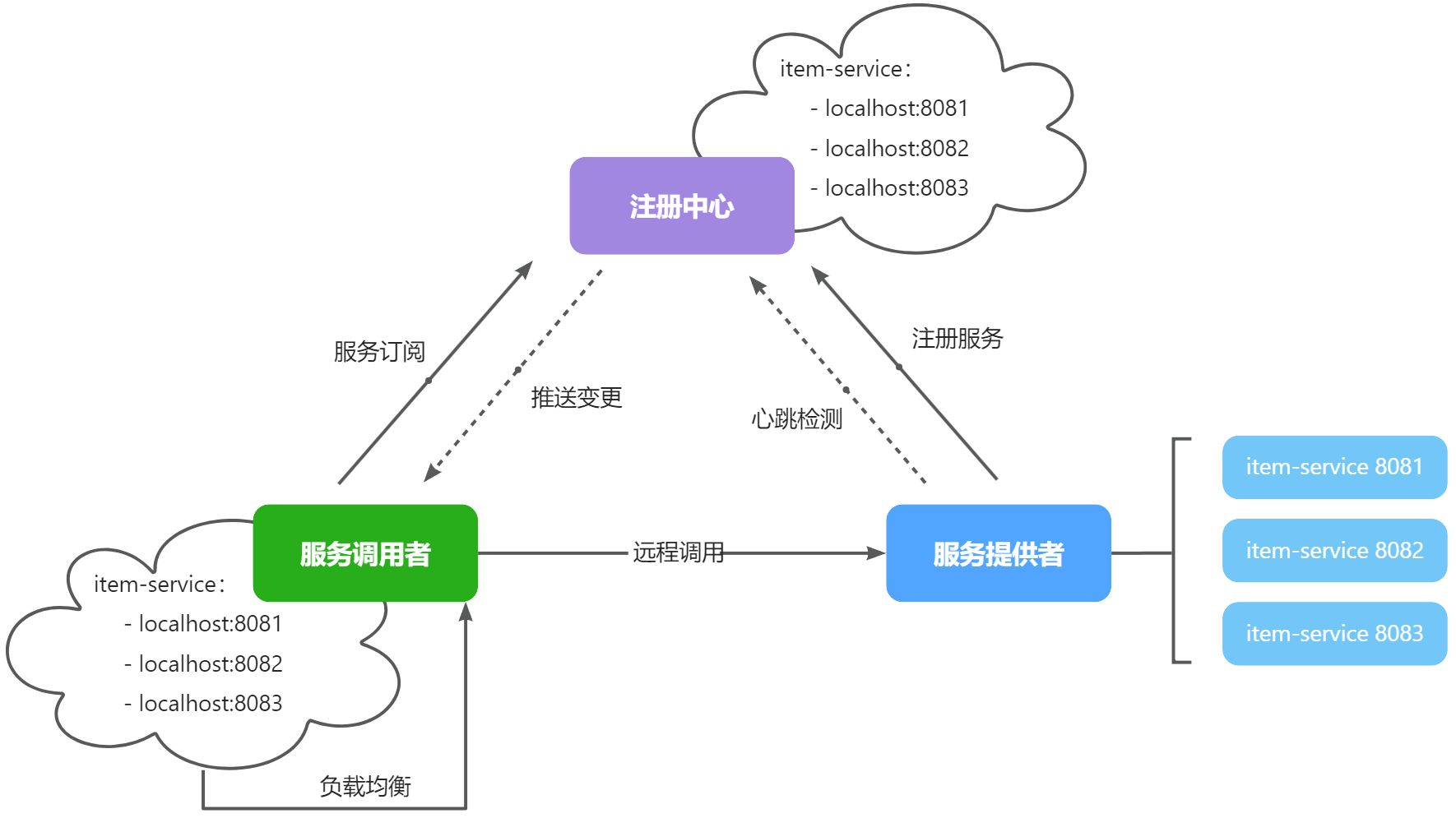

在微服务远程调用的过程中,包括两个角色:

- 服务提供者:提供接口供其它微服务访问,比如

item-service - 服务消费者:调用其它微服务提供的接口,比如

cart-service

在大型微服务项目中,服务提供者的数量会非常多,为了管理这些服务就引入了注册中心的概念。注册中心、服务提供者、服务消费者三者间关系如下:

流程如下:

- 服务启动时就会注册自己的服务信息(服务名、IP、端口)到注册中心

- 调用者可以从注册中心订阅想要的服务,获取服务对应的实例列表(1个服务可能多实例部署)

- 调用者自己对实例列表负载均衡,挑选一个实例

- 调用者向该实例发起远程调用

当服务提供者的实例宕机或者启动新实例时,调用者如何得知呢?

- 服务提供者会定期向注册中心发送请求,报告自己的健康状态(心跳请求)

- 当注册中心长时间收不到提供者的心跳时,会认为该实例宕机,将其从服务的实例列表中剔除

- 当服务有新实例启动时,会发送注册服务请求,其信息会被记录在注册中心的服务实例列表

- 当注册中心服务列表变更时,会主动通知微服务,更新本地服务列表

Nacos注册中心

目前开源的注册中心框架有很多,国内比较常见的有:

- Eureka:Netflix公司出品,目前被集成在SpringCloud当中,一般用于Java应用

- Nacos:Alibaba公司出品,目前被集成在SpringCloudAlibaba中,一般用于Java应用

- Consul:HashiCorp公司出品,目前集成在SpringCloud中,不限制微服务语言

Nacos官网 | Nacos 官方社区 | Nacos 下载 | Nacos

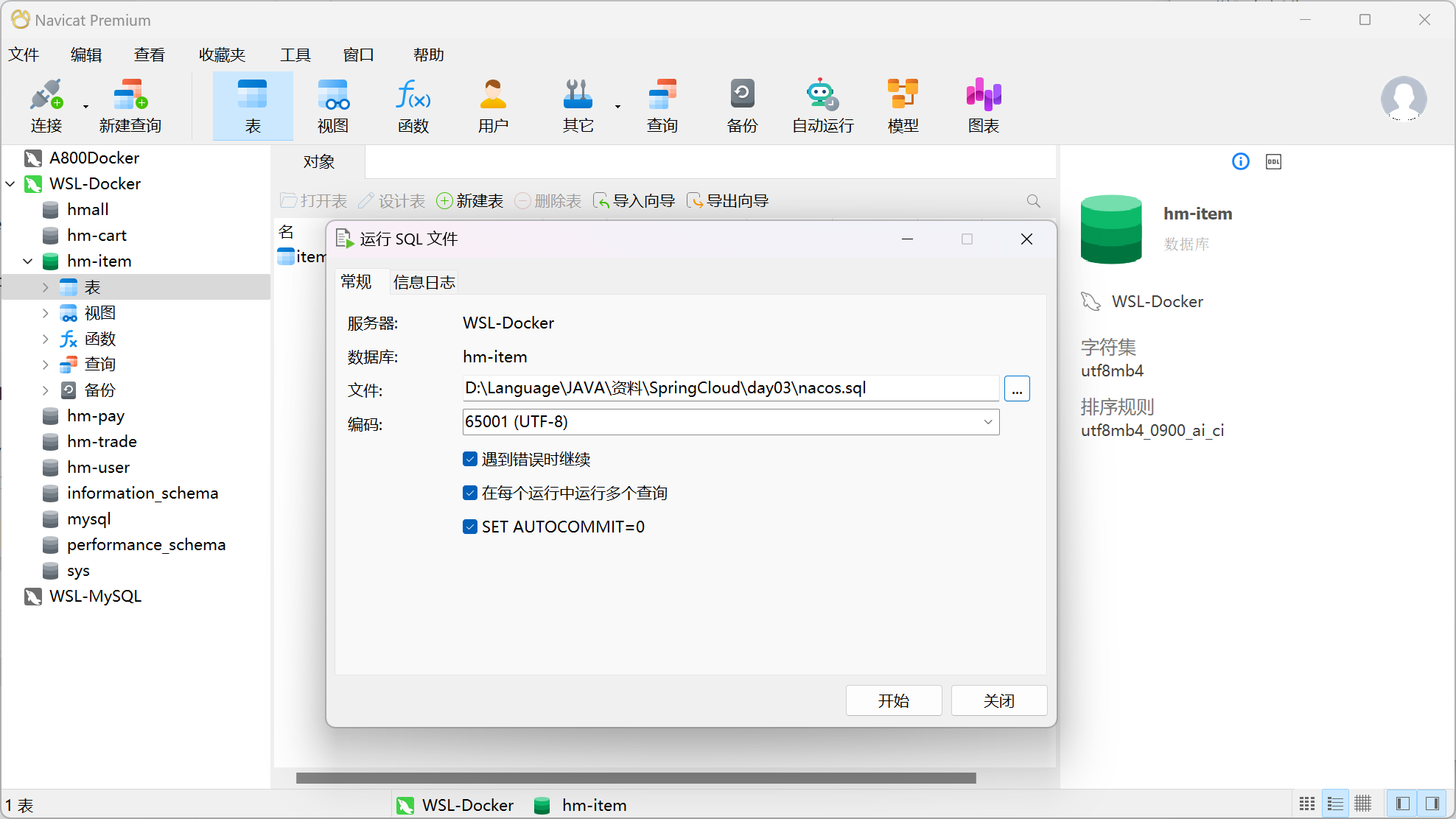

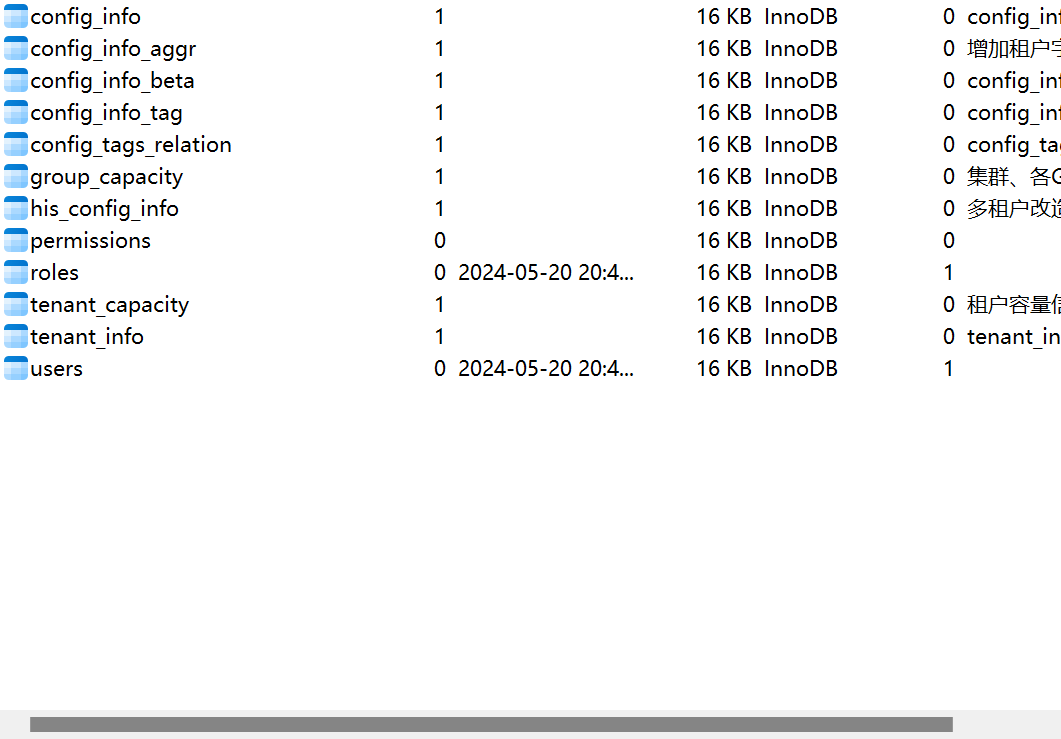

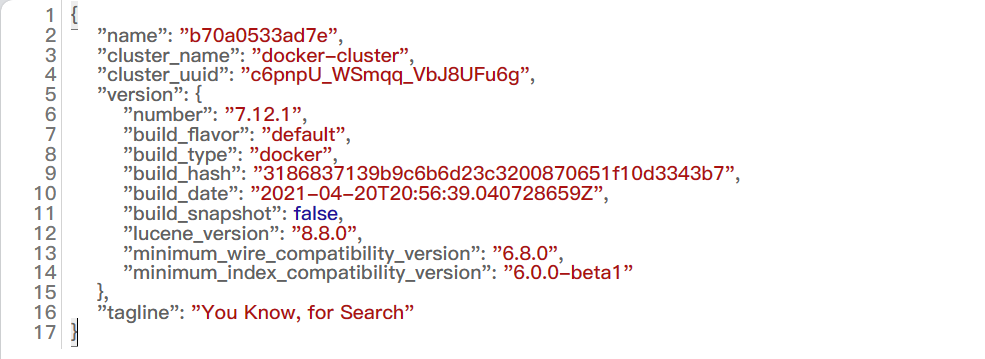

基于Docker来部署Nacos的注册中心,首先要准备MySQL数据库表,用来存储Nacos的数据。

部署nacos

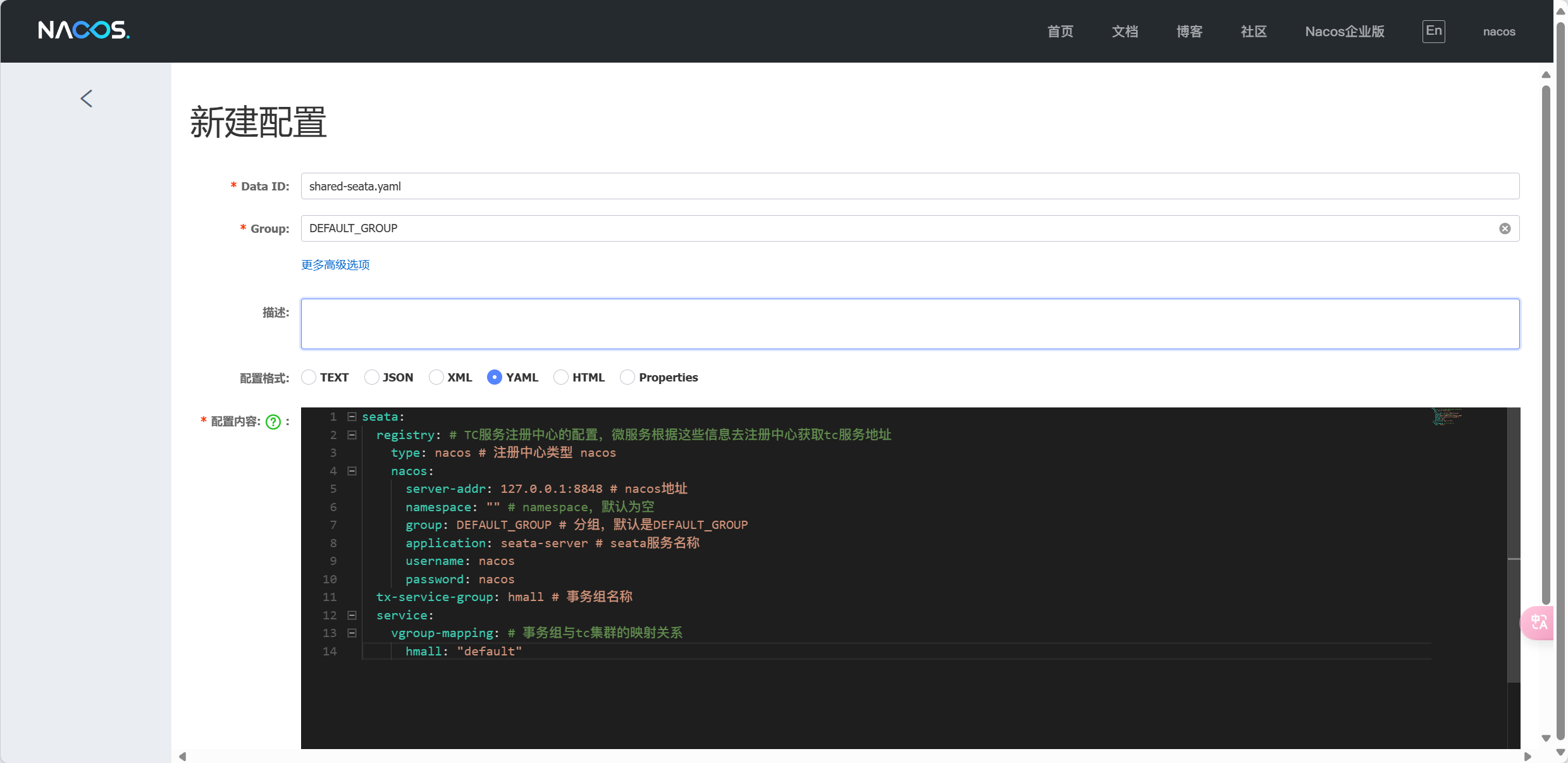

配置文件 custom.env

PREFER_HOST_MODE=hostname

MODE=standalone

SPRING_DATASOURCE_PLATFORM=mysql

MYSQL_SERVICE_HOST=mysql 🚩写ip不对

MYSQL_SERVICE_DB_NAME=nacos

MYSQL_SERVICE_PORT=3306

MYSQL_SERVICE_USER=root

MYSQL_SERVICE_PASSWORD=123

MYSQL_SERVICE_DB_PARAM=characterEncoding=utf8&connectTimeout=1000&socketTimeout=3000&autoReconnect=true&useSSL=false&allowPublicKeyRetrieval=true&serverTimezone=Asia/Shanghai

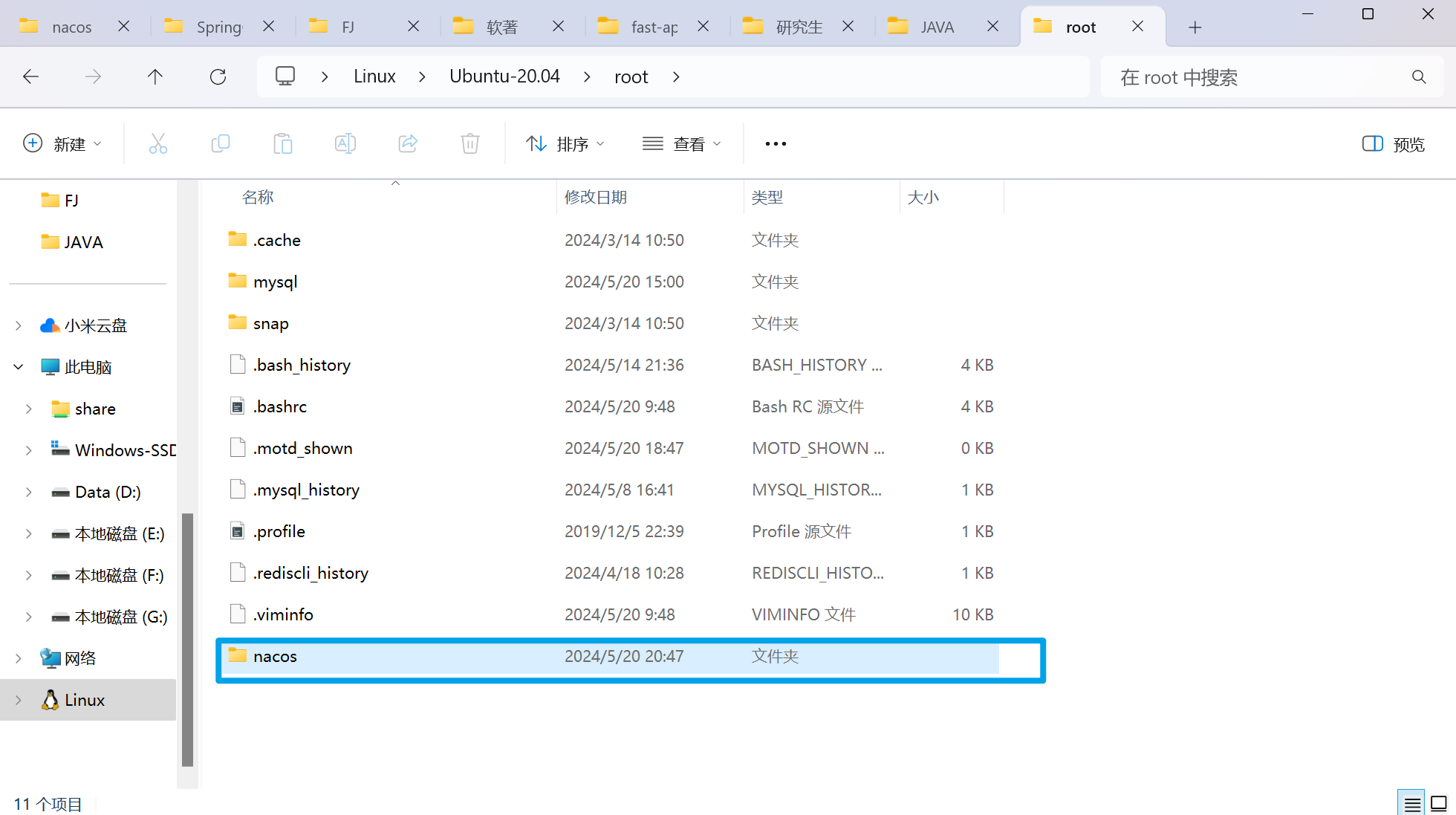

docker run -d \

--name nacos \

--env-file ./nacos/custom.env \

-p 8848:8848 \

-p 9848:9848 \

-p 9849:9849 \

--restart=always \

--network hm-net \

nacos/nacos-server:v2.1.0-slim这里不用和mysql要同一个网络下,因为nacos.env文件中会使用虚拟机地址访问

root@LAPTOP-L6QS5167:~# docker run -d \

--name n> --name nacos \

> --env-file ./nacos/custom.env \

> -p 8848:8848 \

> -p 9848:9848 \

> -p 9849:9849 \

> --restart=always \

> nacos/nacos-server:v2.1.0-slim

Unable to find image 'nacos/nacos-server:v2.1.0-slim' locally

v2.1.0-slim: Pulling from nacos/nacos-server

1fe172e4850f: Pull complete

44d3aa8d0766: Pull complete

81bea02f1eea: Pull complete

072e5a76c05b: Pull complete

b11ea097ecb2: Pull complete

0b1ee541a876: Pull complete

9e6c0537392c: Pull complete

c43200de8246: Pull complete

2c34f234a65f: Pull complete

4f4fb700ef54: Pull complete

Digest: sha256:e689b1c79ca4a391fc478b6b28eac74916bfe569f37abaa8145c156cefe45067

Status: Downloaded newer image for nacos/nacos-server:v2.1.0-slim

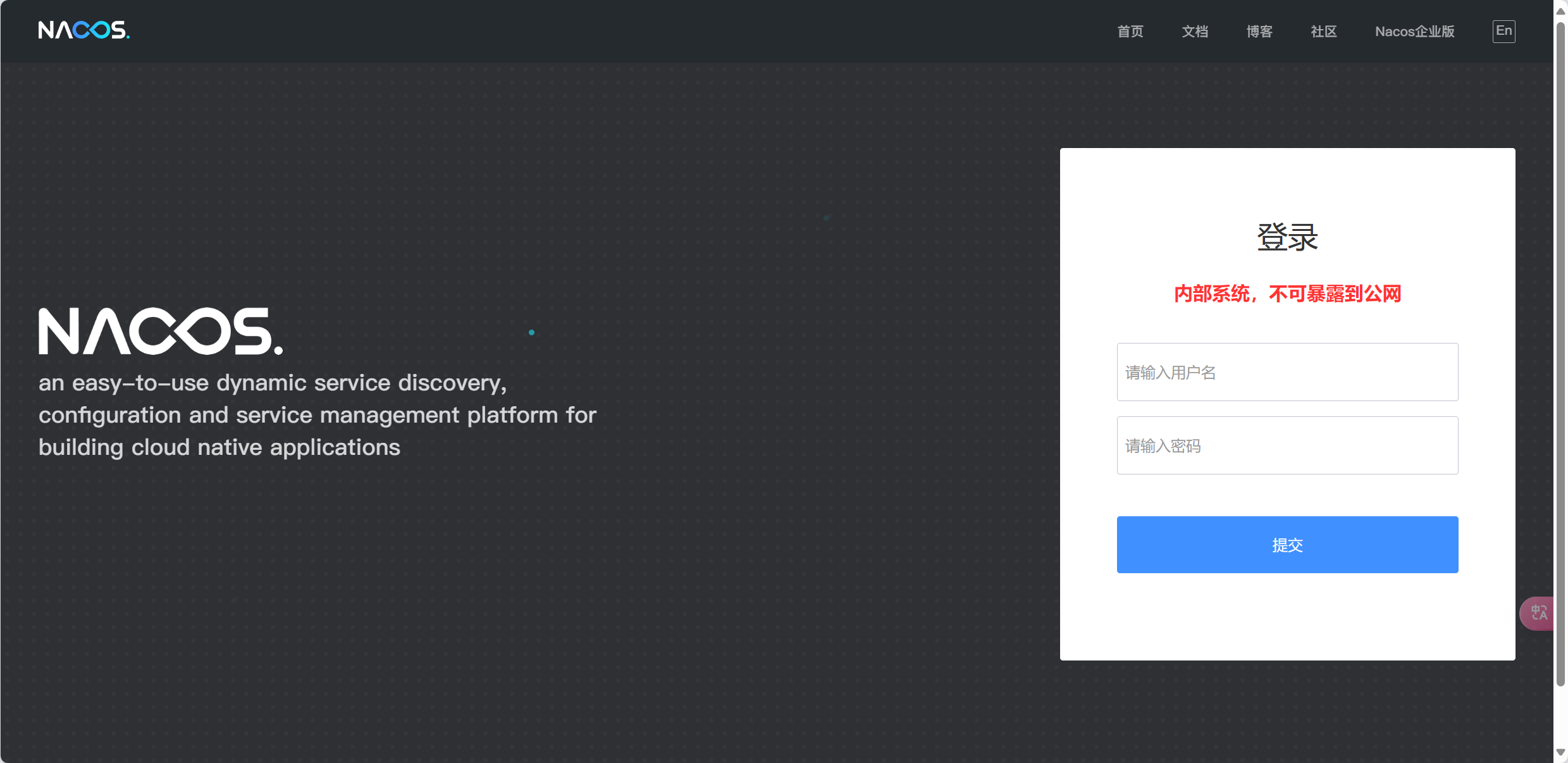

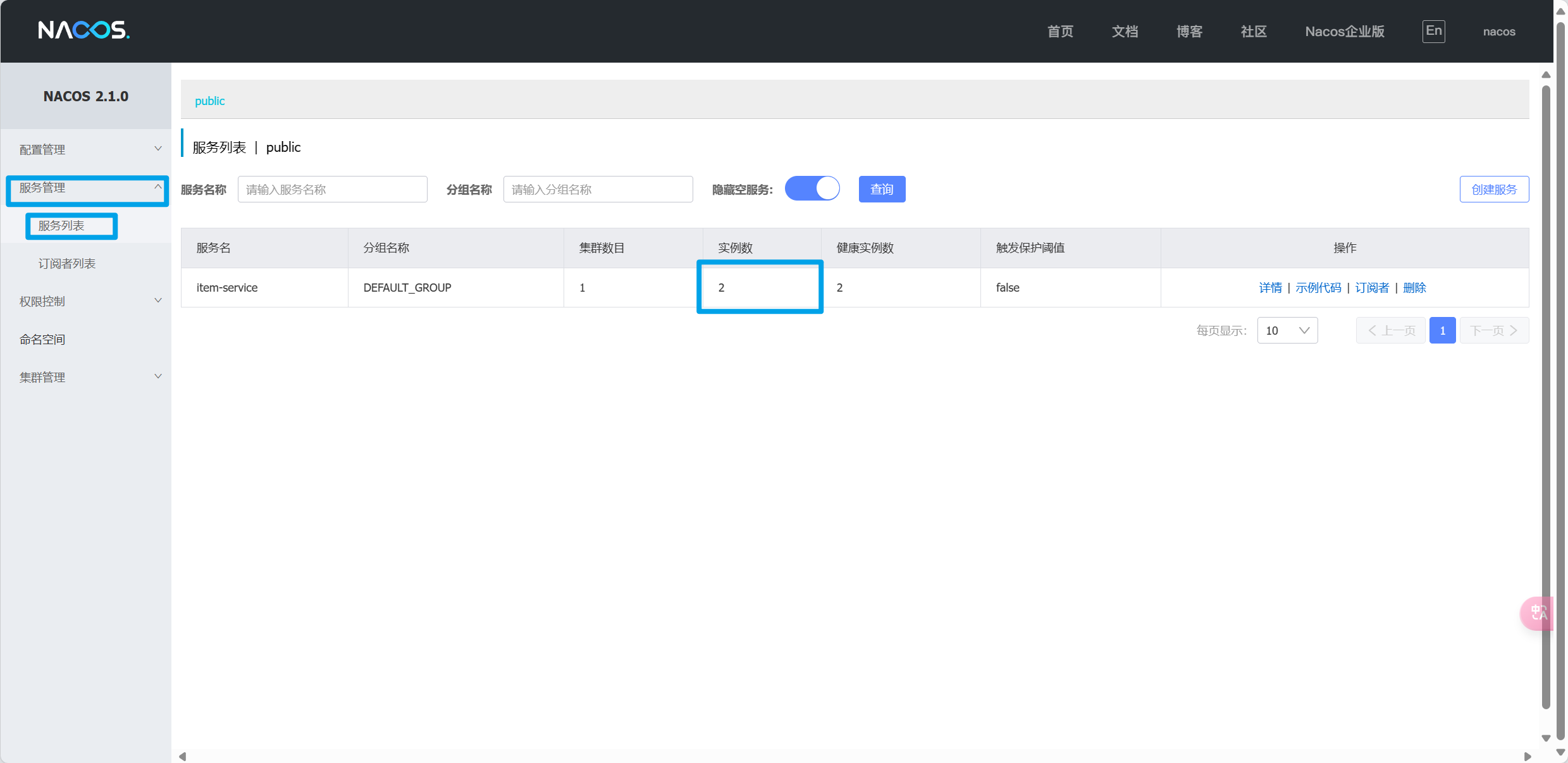

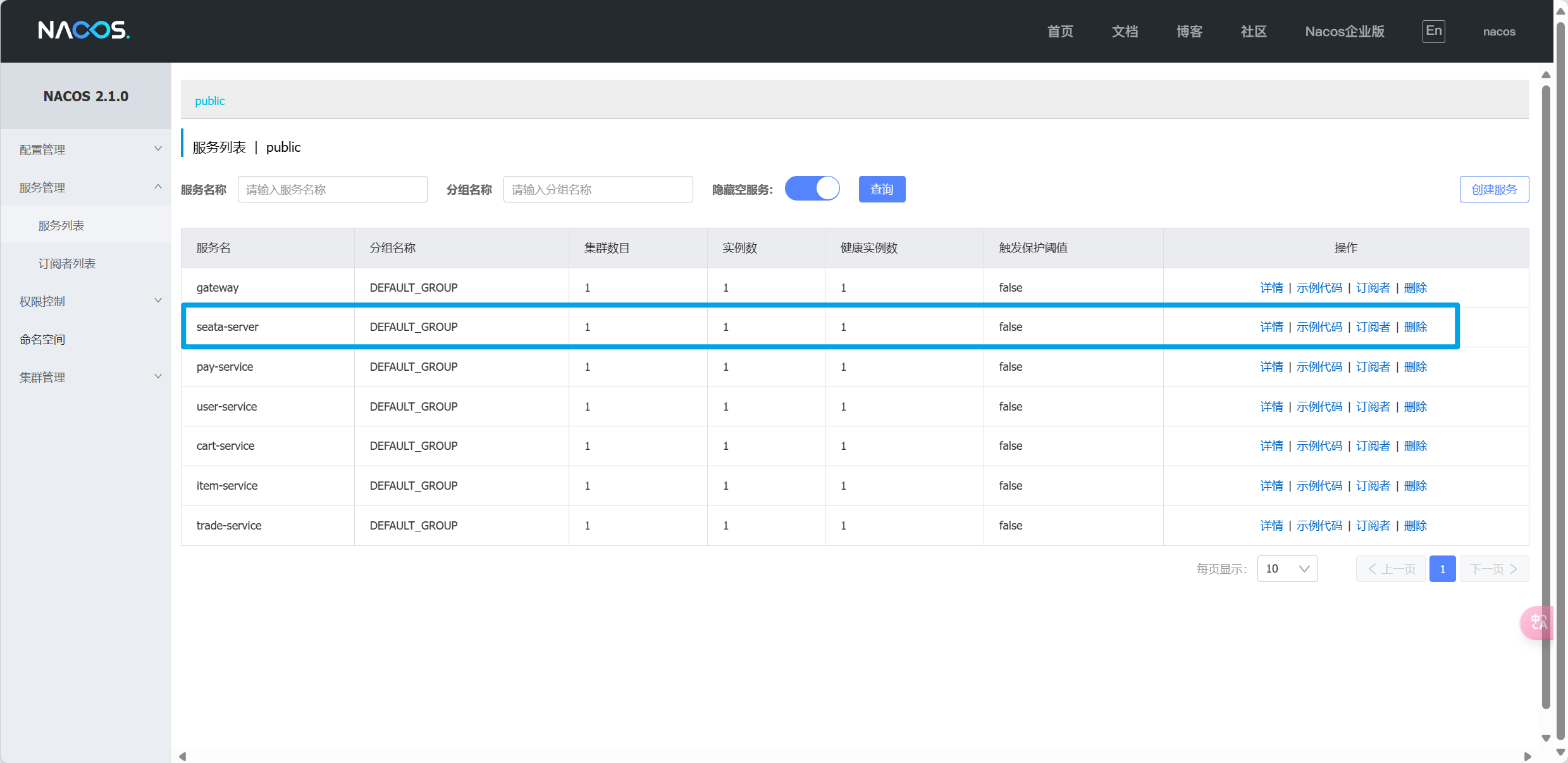

64dacd745237562c7253c9c0c6805cc8ceaf16676264d11b0adbc0353d45269e启动完成后,访问下面地址:http://127.0.0.1:8848/nacos/

账号密码都是nacos

服务注册

引入nacos discovery依赖

在item-service的pom.xml中添加依赖

<!--nacos 服务注册发现-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>配置nacos地址

在item-service的application.yml中添加nacos地址配置

spring:

application:

name: item-service # 微服务名称

cloud:

nacos:

server-addr: 127.0.0.1:8848 # nacos地址为了测试一个服务多个实例的情况,再配置一个item-service的部署实例

ctrl+D复制实例

服务发现

服务的消费者要去nacos订阅服务,这个过程就是服务发现,步骤如下:

- 引入依赖

- 配置Nacos地址

- 发现并调用服务

引入依赖

服务发现除了要引入nacos依赖以外,由于还需要负载均衡,因此要引入SpringCloud提供的LoadBalancer依赖。

在cart-service中的pom.xml中添加下面的依赖

<!--nacos 服务注册发现-->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>配置Nacos地址

在cart-service的application.yml中添加nacos地址配置

spring:

application:

name: cart-service # 微服务名称

cloud:

nacos:

server-addr: 127.0.0.1:8848 # nacos地址发现并调用服务

服务调用者cart-service订阅item-service服务

常见的负载均衡算法有:

- 随机

- 轮询

- IP的hash

- 最近最少访问

- ...

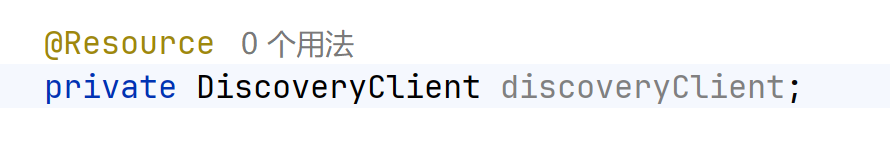

服务发现需要用到一个工具,DiscoveryClient,SpringCloud已经帮自动装配,可以直接注入使用

改造实现类,不把地址写死

package com.hmall.cart.service.impl;

/**

* <p>

* 订单详情表 服务实现类

* </p>

*/

@Service

@RequiredArgsConstructor

public class CartServiceImpl extends ServiceImpl<CartMapper, Cart> implements ICartService {

// private final IItemService itemService;

@Resource

private RestTemplate restTemplate;

@Resource

private DiscoveryClient discoveryClient;

@Override

public void addItem2Cart(CartFormDTO cartFormDTO) {

// 1.获取登录用户

Long userId = UserContext.getUser();

// 2.判断是否已经存在

if (checkItemExists(cartFormDTO.getItemId(), userId)) {

// 2.1.存在,则更新数量

baseMapper.updateNum(cartFormDTO.getItemId(), userId);

return;

}

// 2.2.不存在,判断是否超过购物车数量

checkCartsFull(userId);

// 3.新增购物车条目

// 3.1.转换PO

Cart cart = BeanUtils.copyBean(cartFormDTO, Cart.class);

// 3.2.保存当前用户

cart.setUserId(userId);

// 3.3.保存到数据库

save(cart);

}

@Override

public List<CartVO> queryMyCarts() {

// 1.查询我的购物车列表

List<Cart> carts = lambdaQuery().eq(Cart::getUserId, 1L /* TODO UserContext.getUser()*/).list();

if (CollUtils.isEmpty(carts)) {

return CollUtils.emptyList();

}

// 2.转换VO

List<CartVO> vos = BeanUtils.copyList(carts, CartVO.class);

// 3.处理VO中的商品信息

handleCartItems(vos);

// 4.返回

return vos;

}

private void handleCartItems(List<CartVO> vos) {

// 1.获取商品id

Set<Long> itemIds = vos.stream().map(CartVO::getItemId).collect(Collectors.toSet());

// 2.查询商品

// List<ItemDTO> items = itemService.queryItemByIds(itemIds);

List<ServiceInstance> instances = discoveryClient.getInstances("item-service");

if(CollUtil.isEmpty(instances)) {

return;

}

ServiceInstance instance = instances.get(RandomUtil.randomInt(instances.size()));

// 通过调用http请求获取

ResponseEntity<List<ItemDTO>> response =

restTemplate.exchange(instance.getUri() + "/items?ids={ids}", HttpMethod.GET, null,

new ParameterizedTypeReference<List<ItemDTO>>() {}, Map.of("ids", CollectionUtil.join(itemIds, ",")));

// 解析数据

if (!response.getStatusCode().is2xxSuccessful()) {

return;

}

List<ItemDTO> items = response.getBody();

if (CollUtils.isEmpty(items)) {

return;

}

// 3.转为 id 到 item的map

Map<Long, ItemDTO> itemMap = items.stream().collect(Collectors.toMap(ItemDTO::getId, Function.identity()));

// 4.写入vo

for (CartVO v : vos) {

ItemDTO item = itemMap.get(v.getItemId());

if (item == null) {

continue;

}

v.setNewPrice(item.getPrice());

v.setStatus(item.getStatus());

v.setStock(item.getStock());

}

}

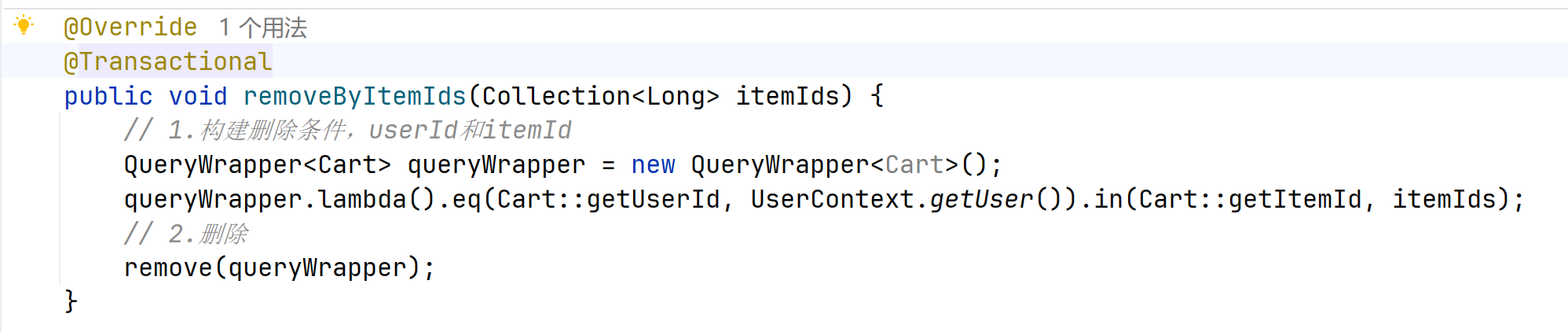

@Override

public void removeByItemIds(Collection<Long> itemIds) {

// 1.构建删除条件,userId和itemId

QueryWrapper<Cart> queryWrapper = new QueryWrapper<Cart>();

queryWrapper.lambda().eq(Cart::getUserId, UserContext.getUser()).in(Cart::getItemId, itemIds);

// 2.删除

remove(queryWrapper);

}

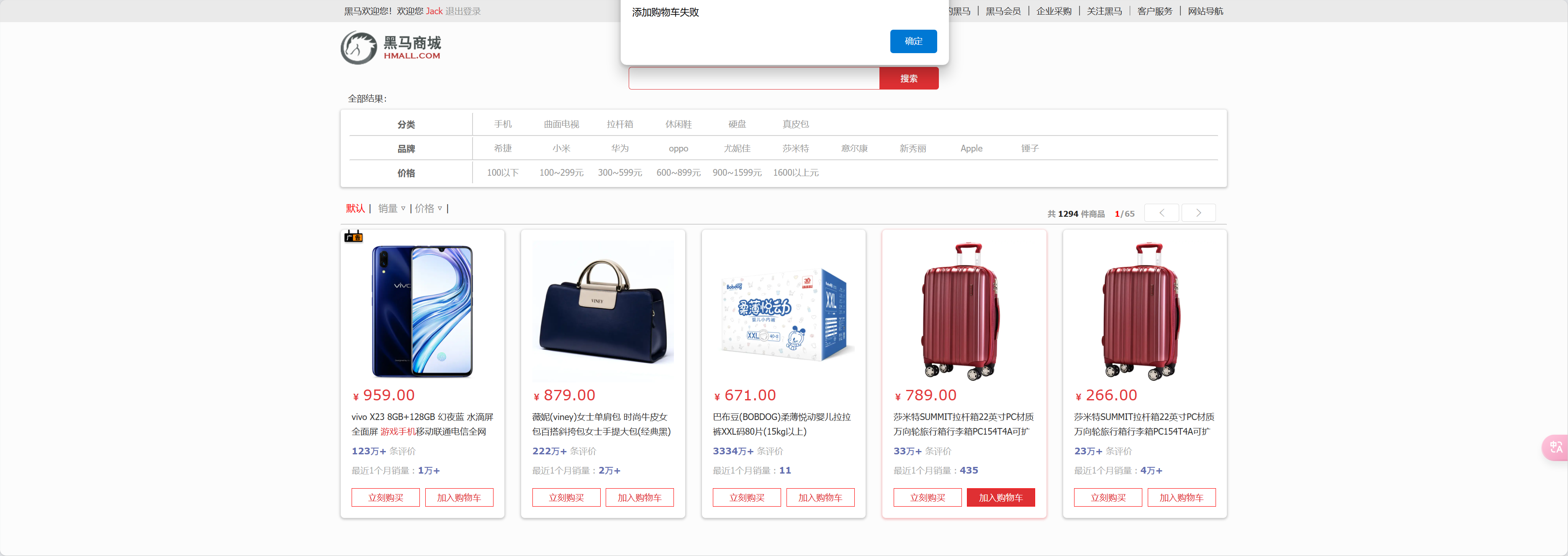

private void checkCartsFull(Long userId) {

int count = lambdaQuery().eq(Cart::getUserId, userId).count();

if (count >= 10) {

throw new BizIllegalException(StrUtil.format("用户购物车课程不能超过{}", 10));

}

}

private boolean checkItemExists(Long itemId, Long userId) {

int count = lambdaQuery().eq(Cart::getUserId, userId).eq(Cart::getItemId, itemId).count();

return count > 0;

}

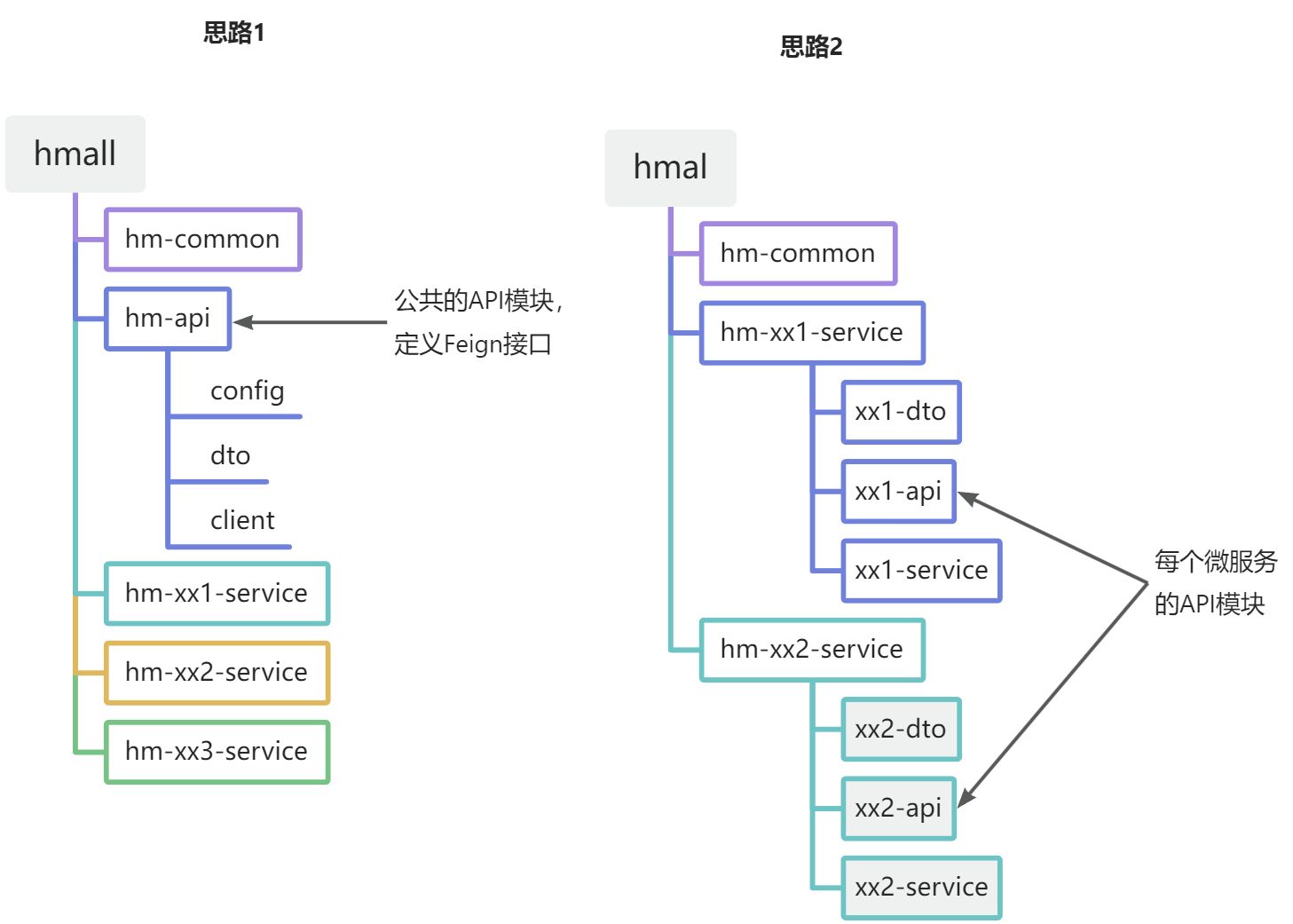

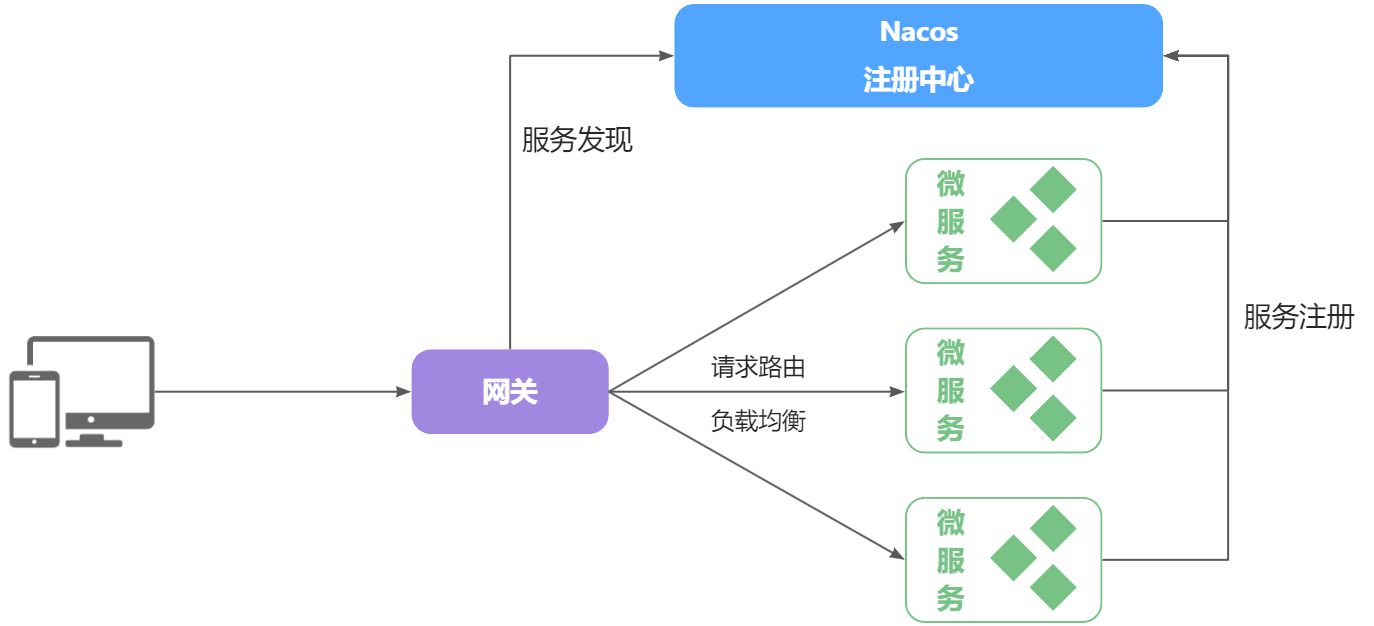

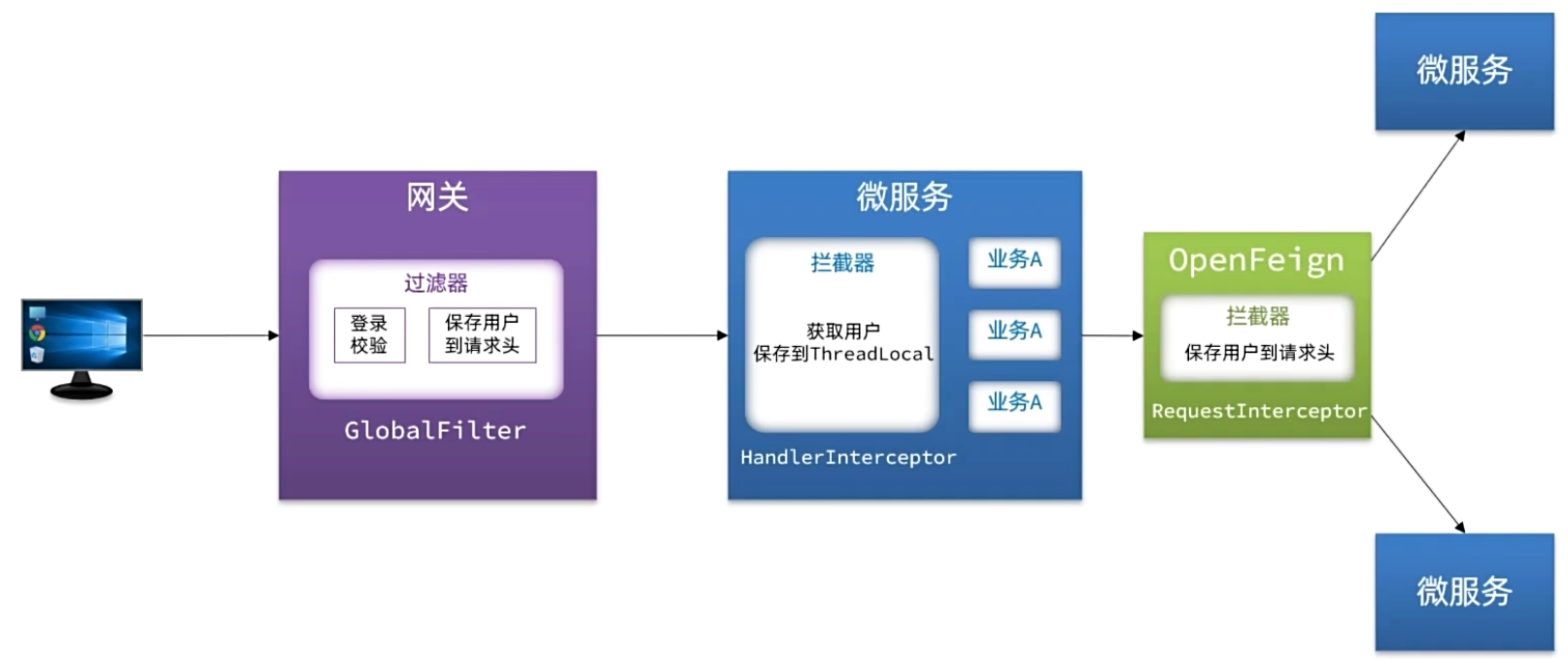

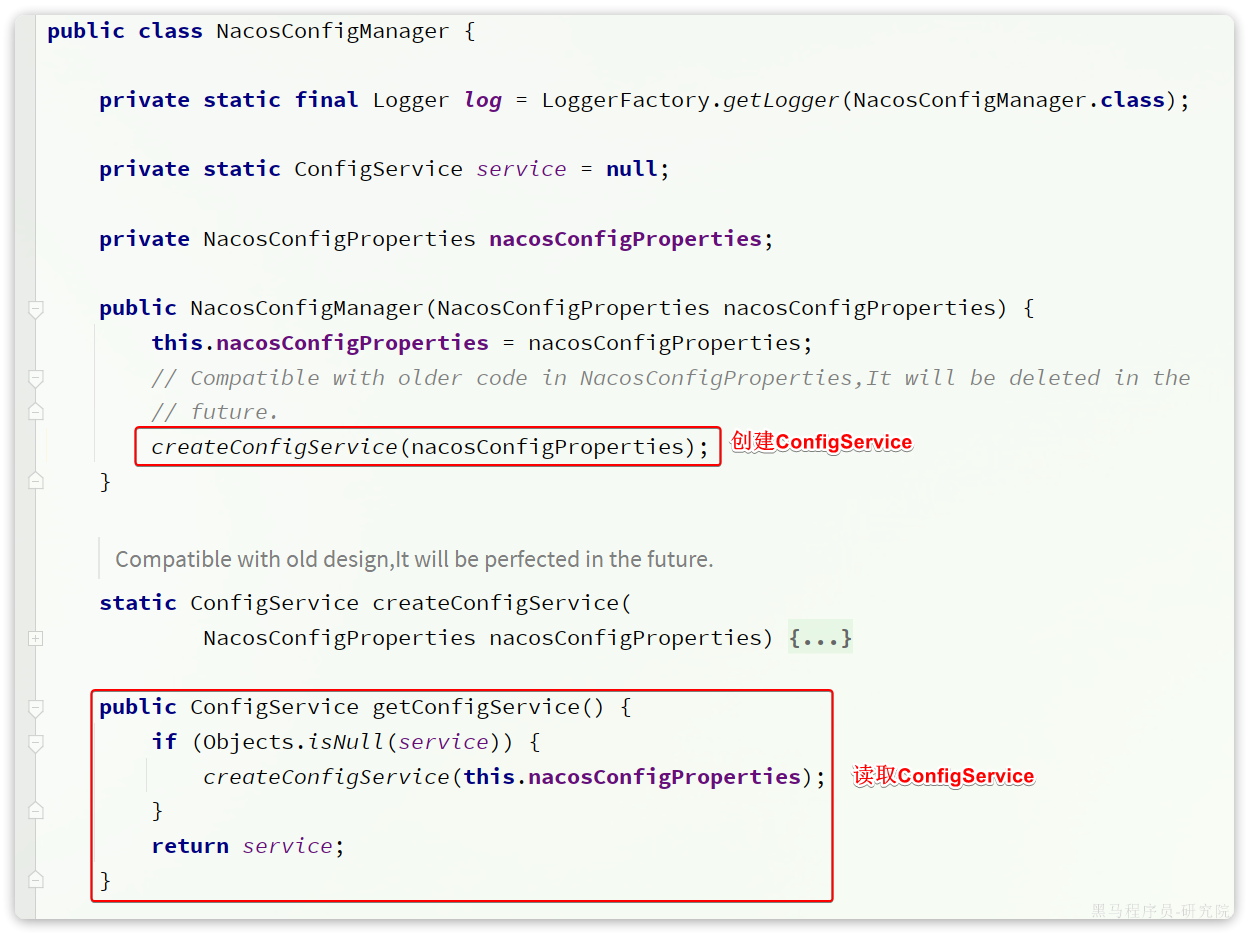

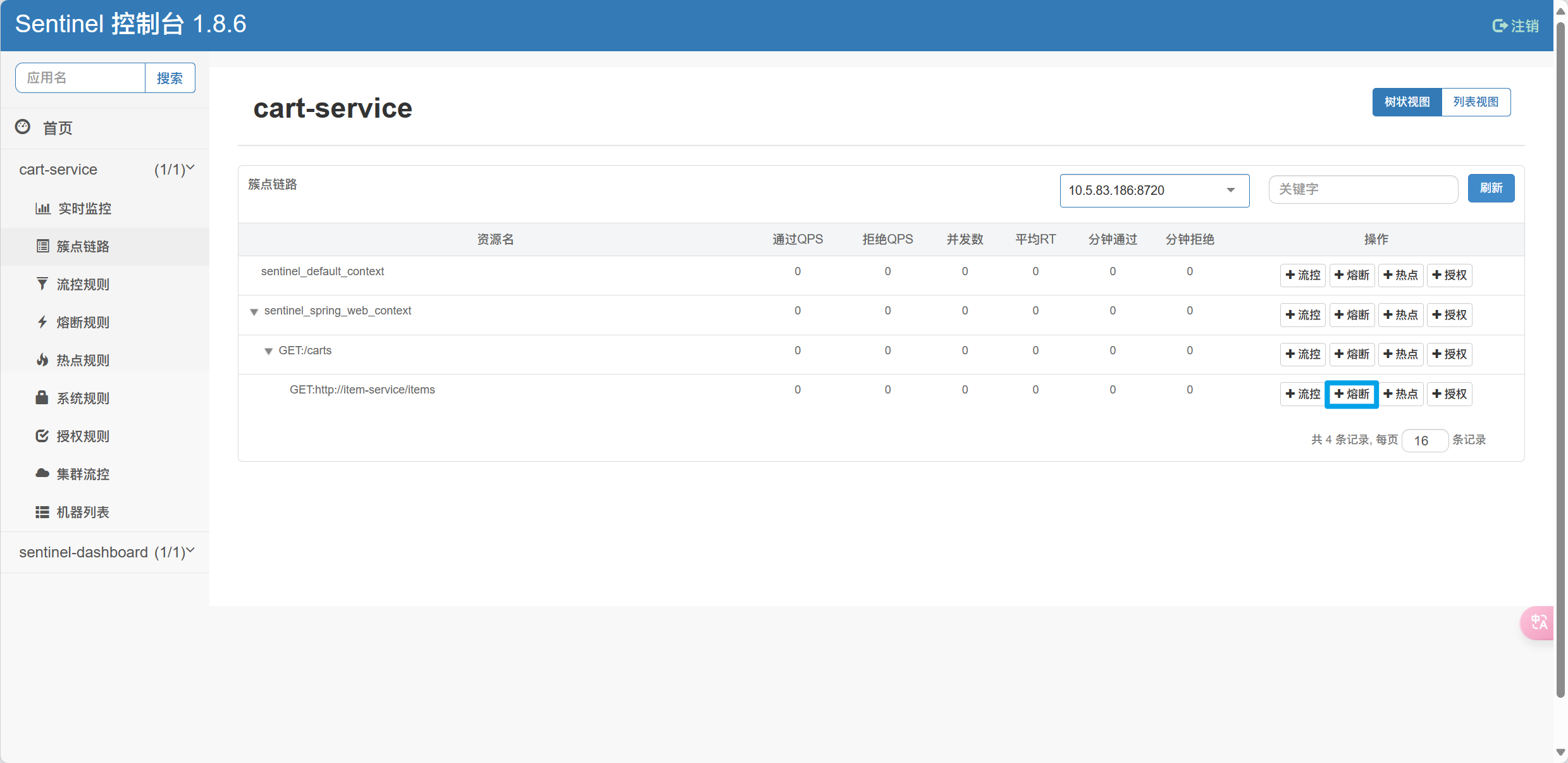

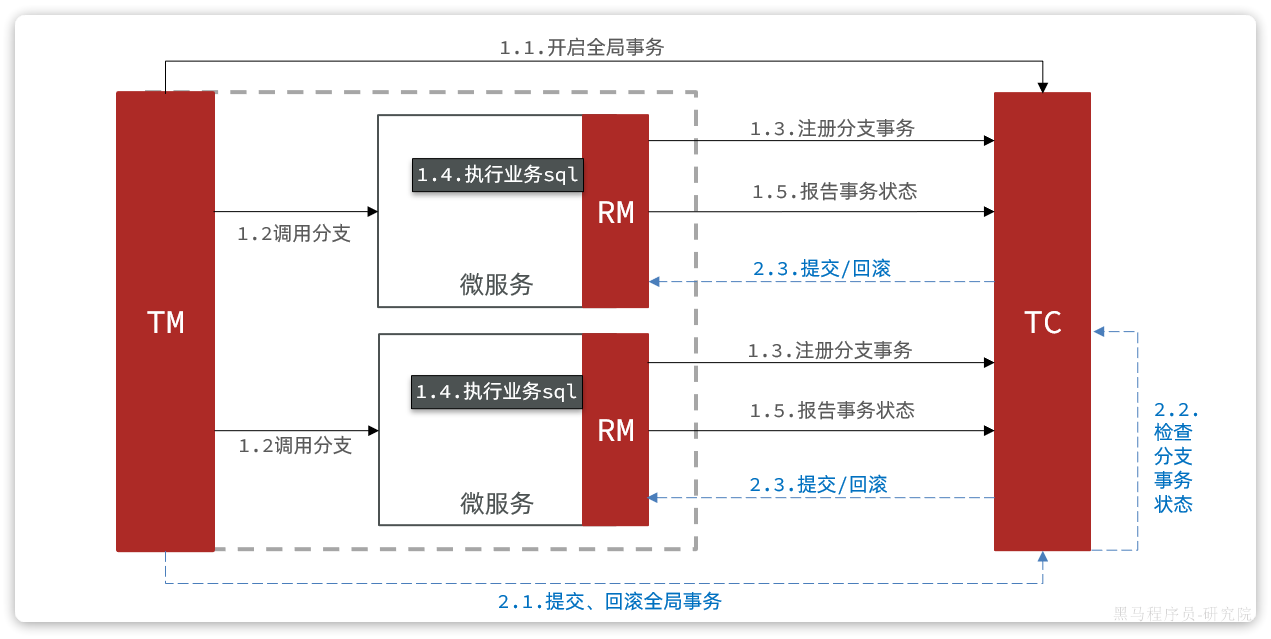

}OpenFeign

入门

解决调用太麻烦的问题

远程调用的关键点就在于四个:

- 请求方式

- 请求路径

- 请求参数

- 返回值类型

所以,OpenFeign就利用SpringMVC的相关注解来声明上述4个参数,然后基于动态代理帮生成远程调用的代码,而无需手动再编写

引入依赖

在cart-service服务的pom.xml中引入OpenFeign的依赖和loadBalancer依赖

<!--openFeign-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-openfeign</artifactId>

</dependency>

<!--负载均衡器-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-loadbalancer</artifactId>

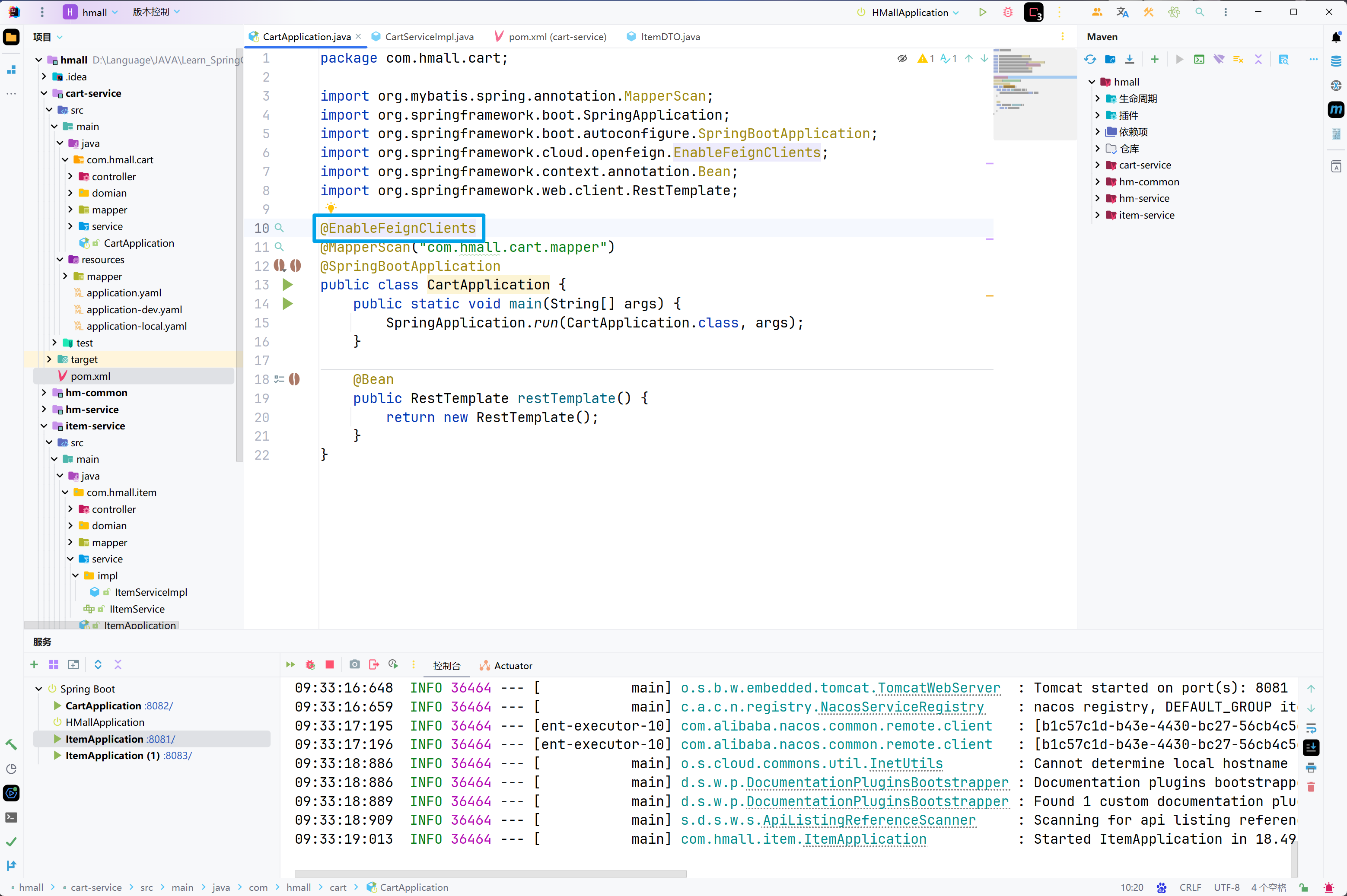

</dependency>启用OpenFeign

在cart-service的CartApplication启动类上添加EnableFeignClients注解,启动OpenFeign功能

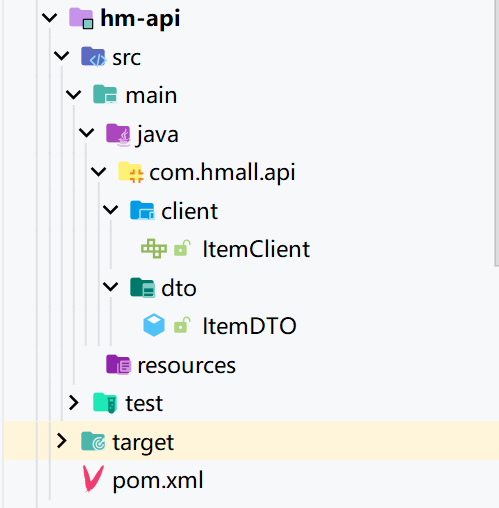

编写OpenFeign客户端

在cart-service中,定义一个新的接口,编写Feign客户端

package com.hmall.cart.client;

import com.hmall.cart.domain.dto.ItemDTO;

import org.springframework.cloud.openfeign.FeignClient;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import java.util.List;

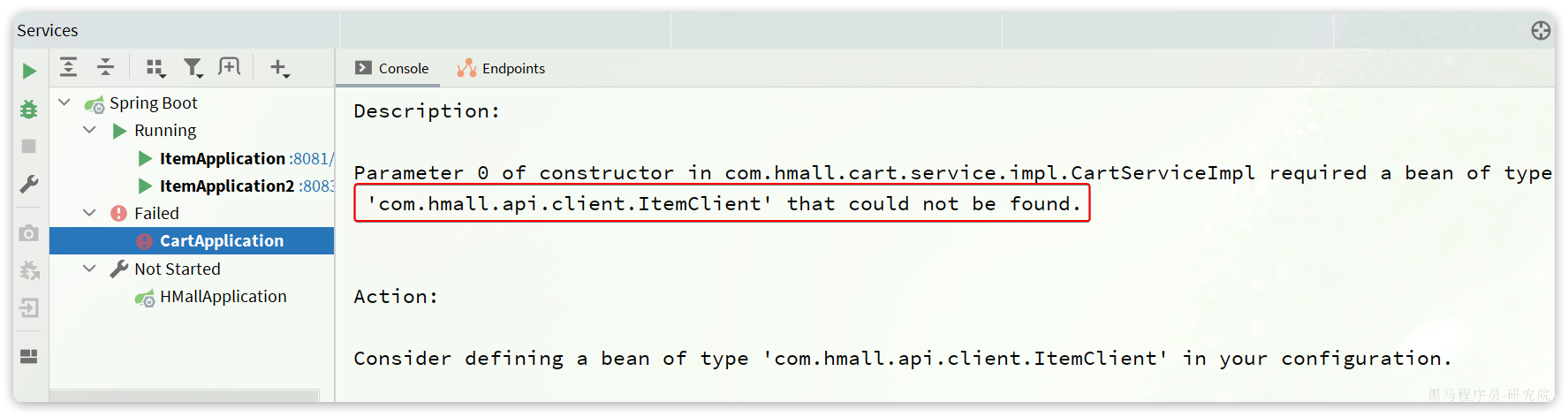

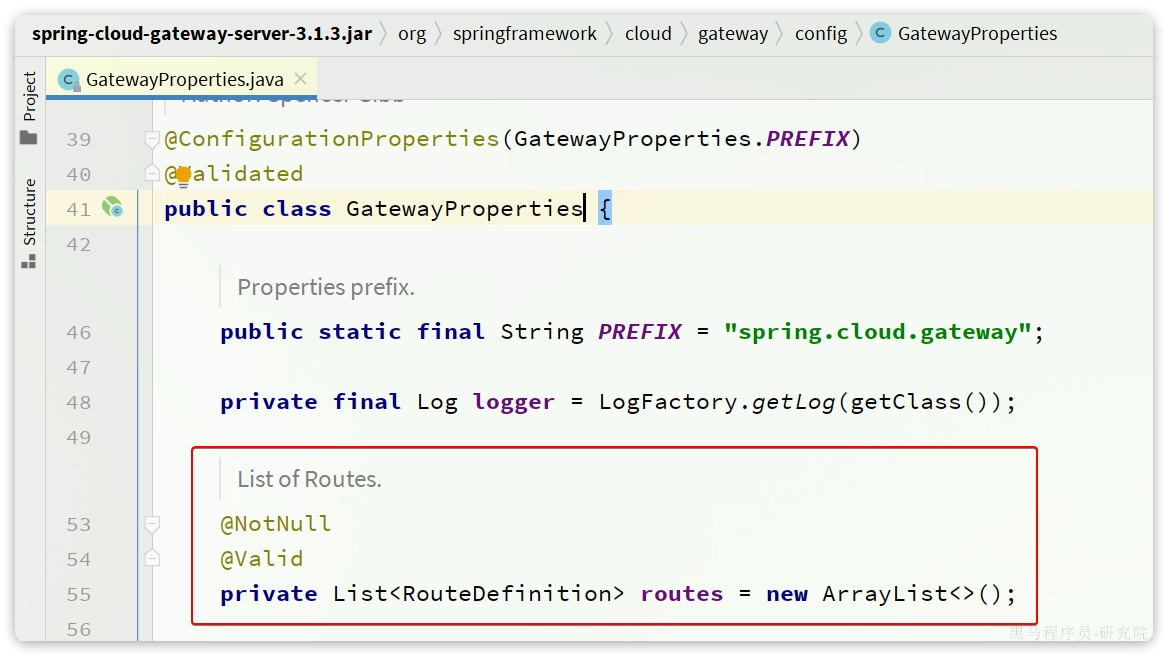

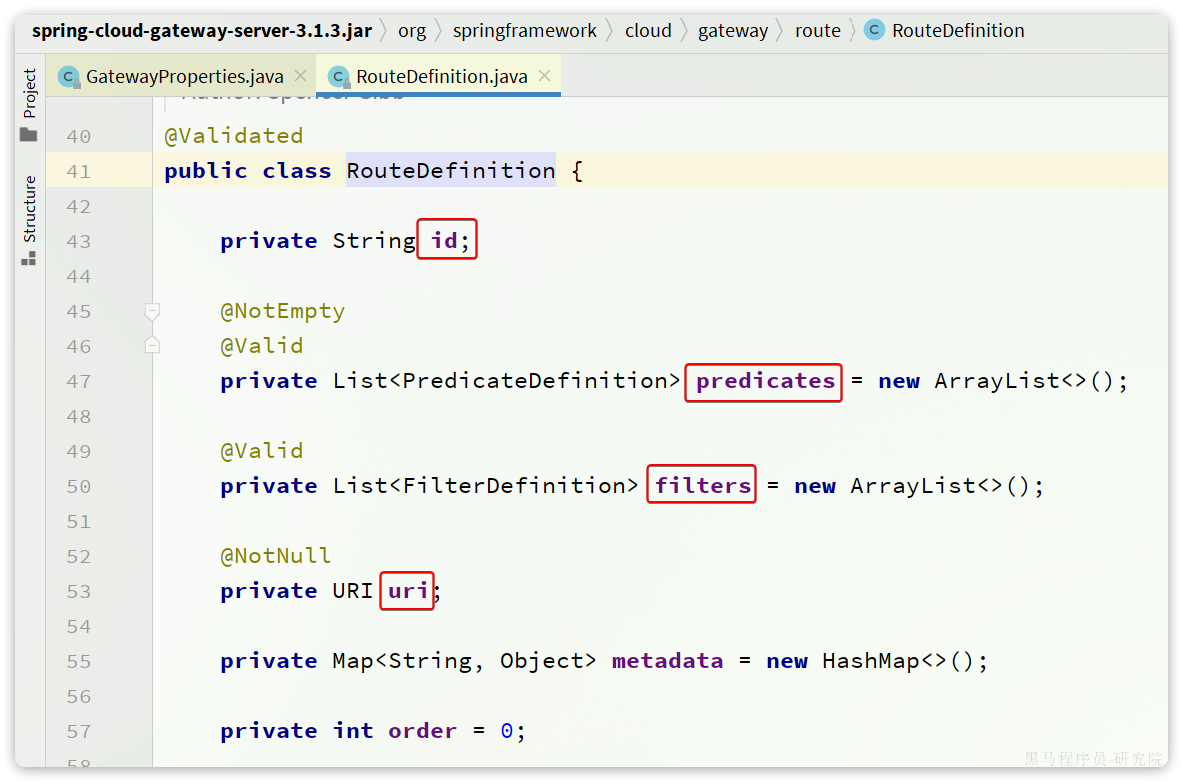

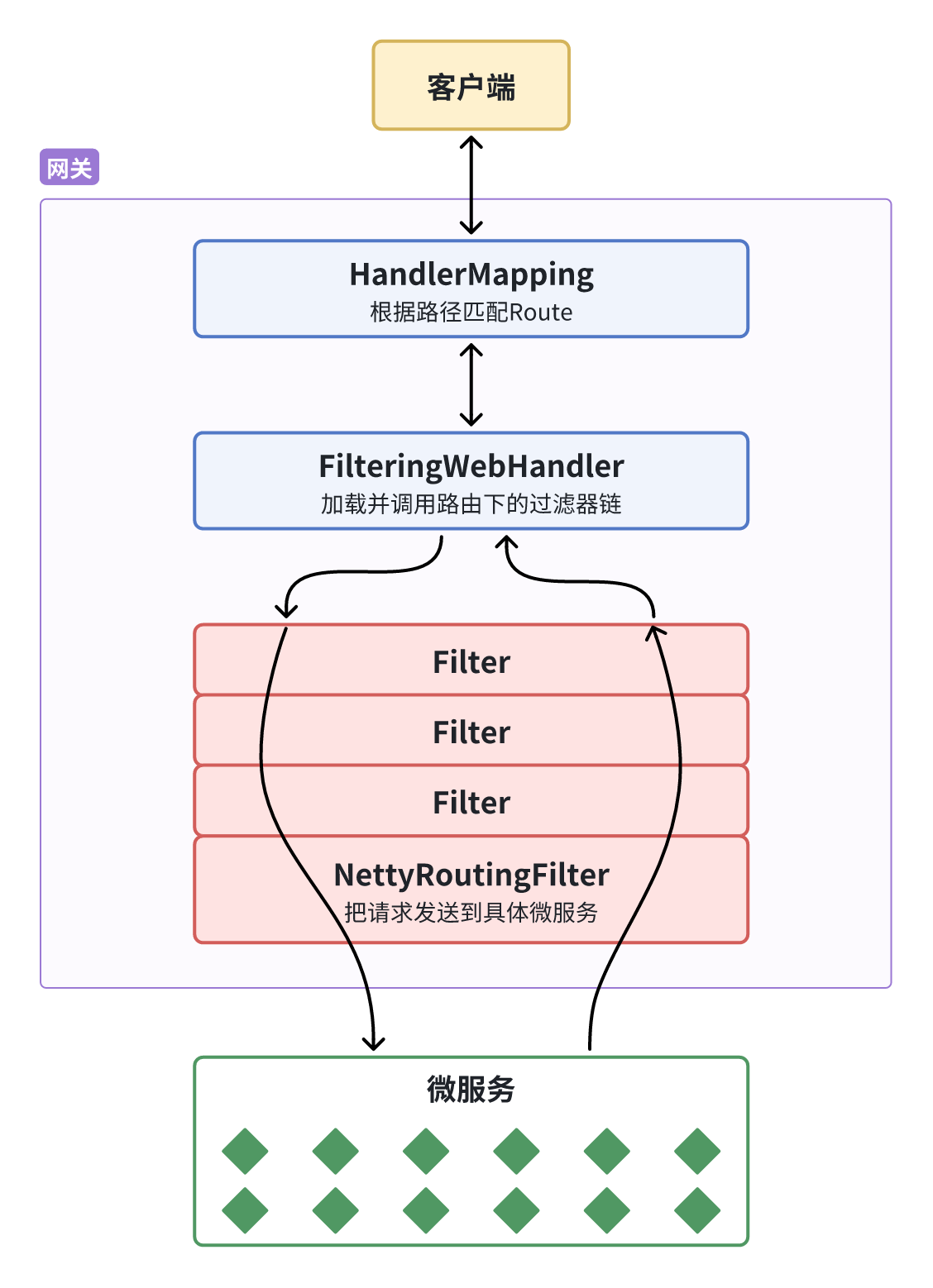

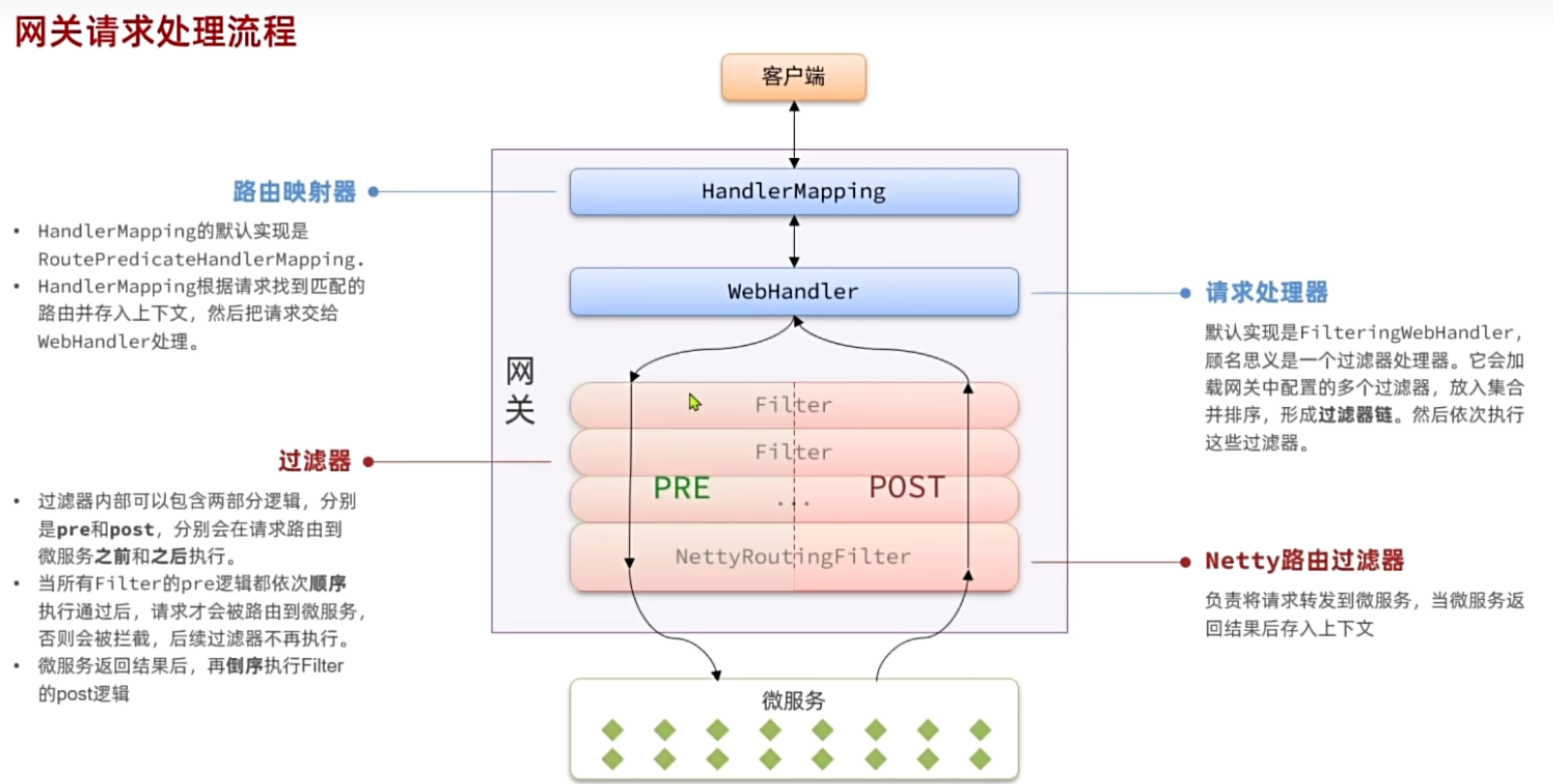

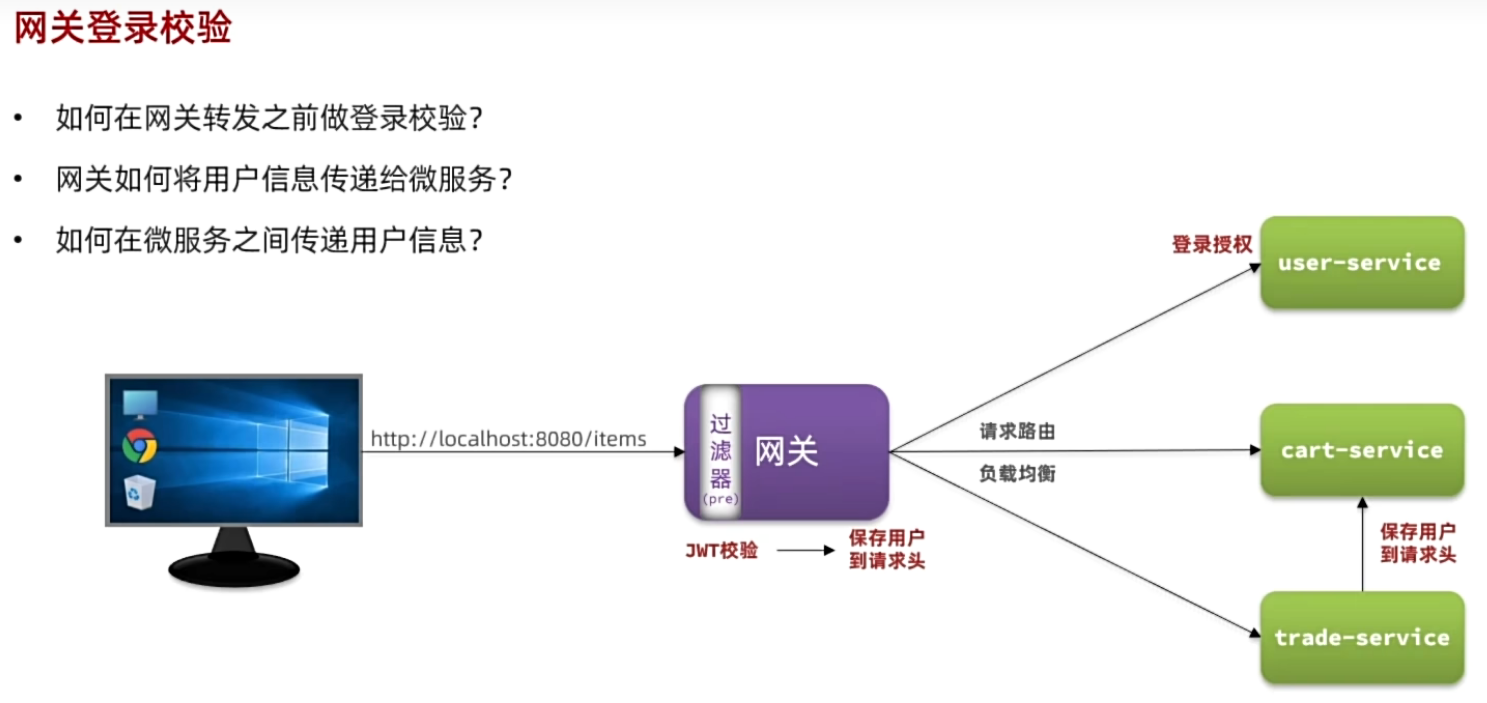

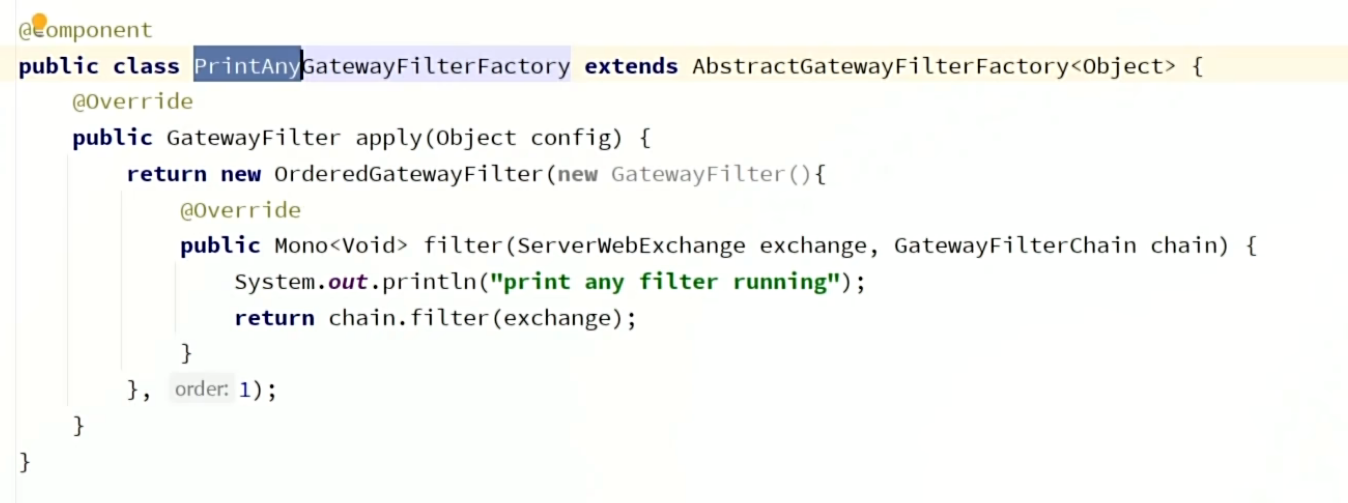

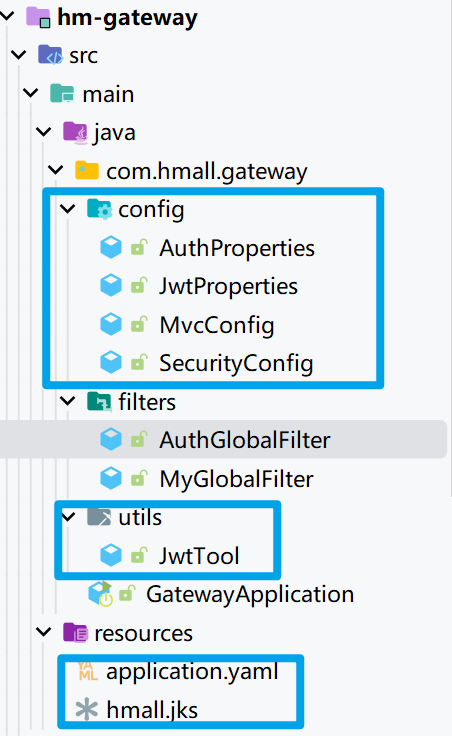

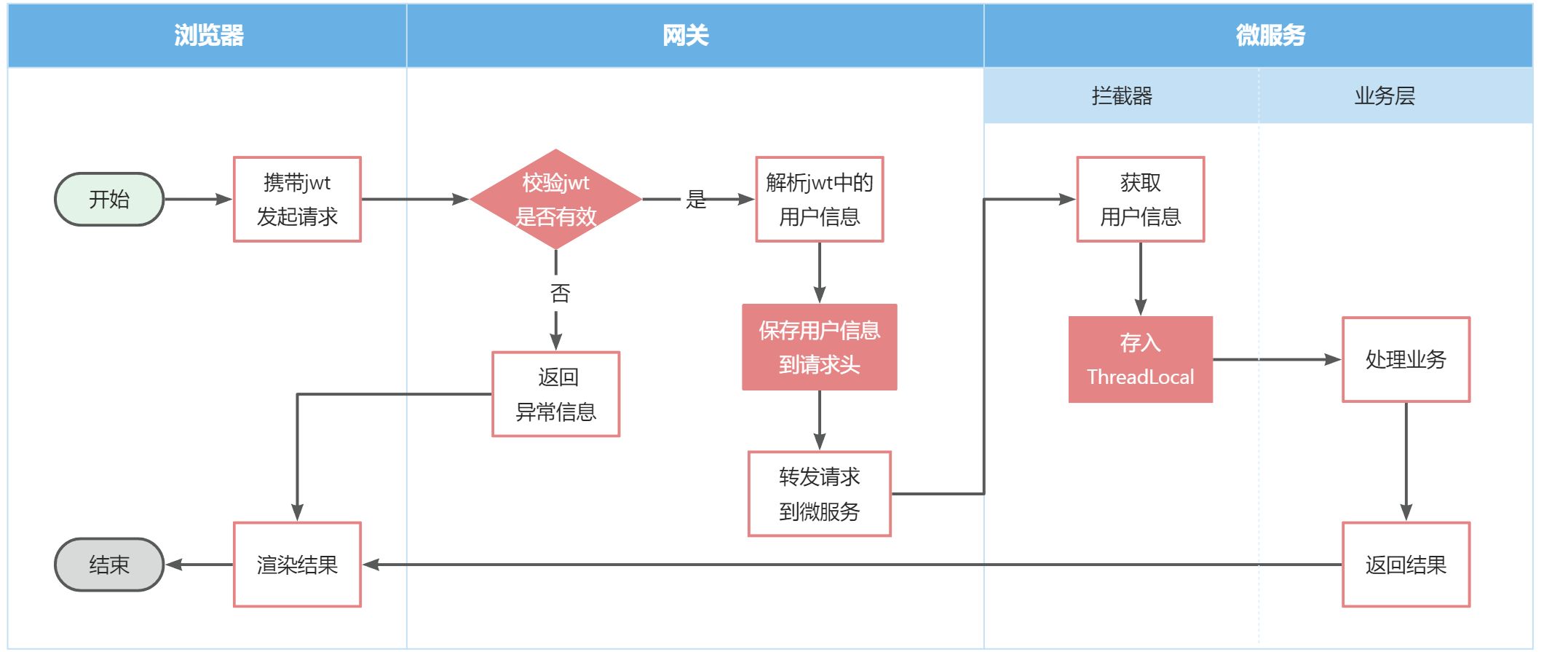

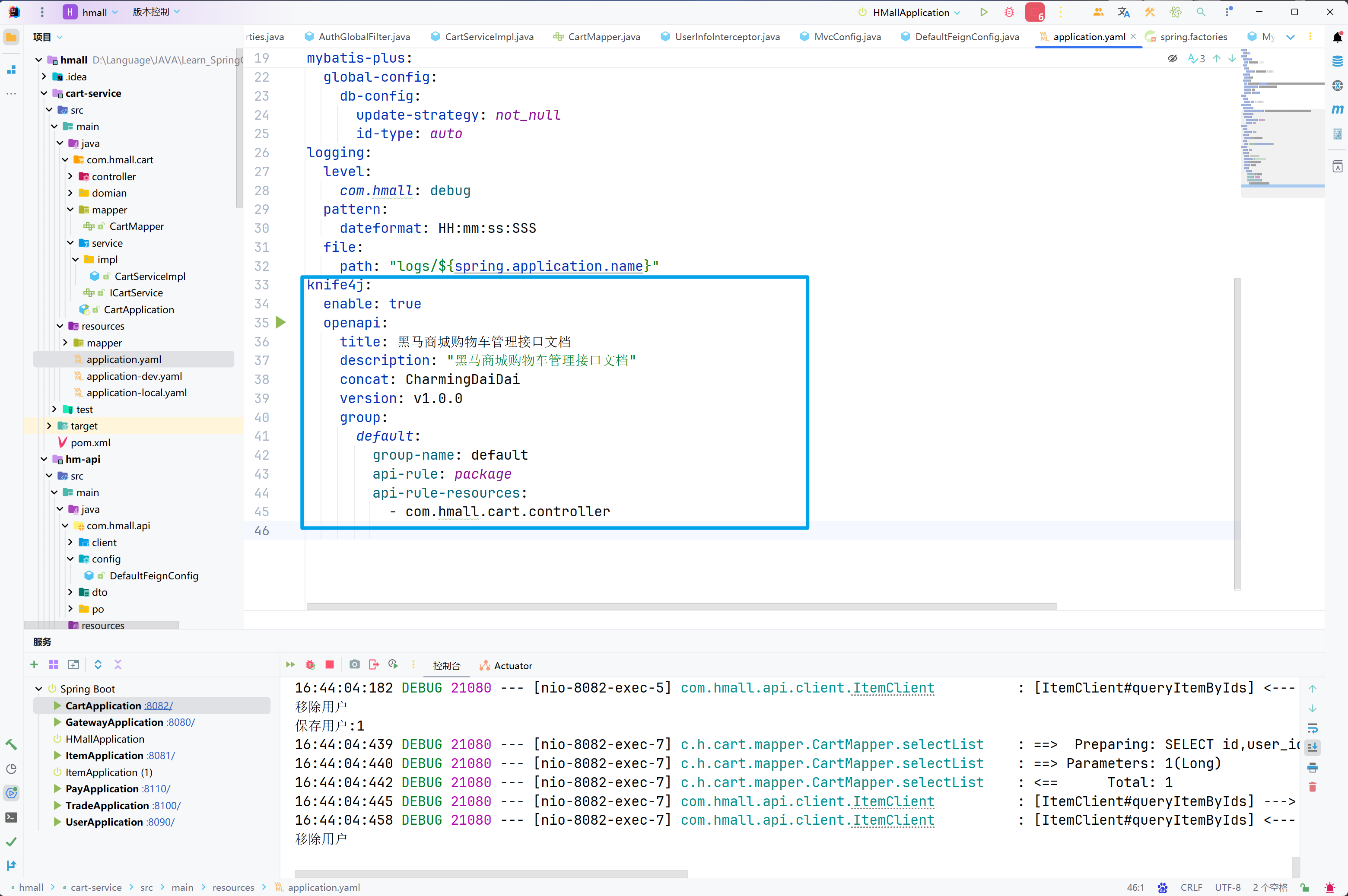

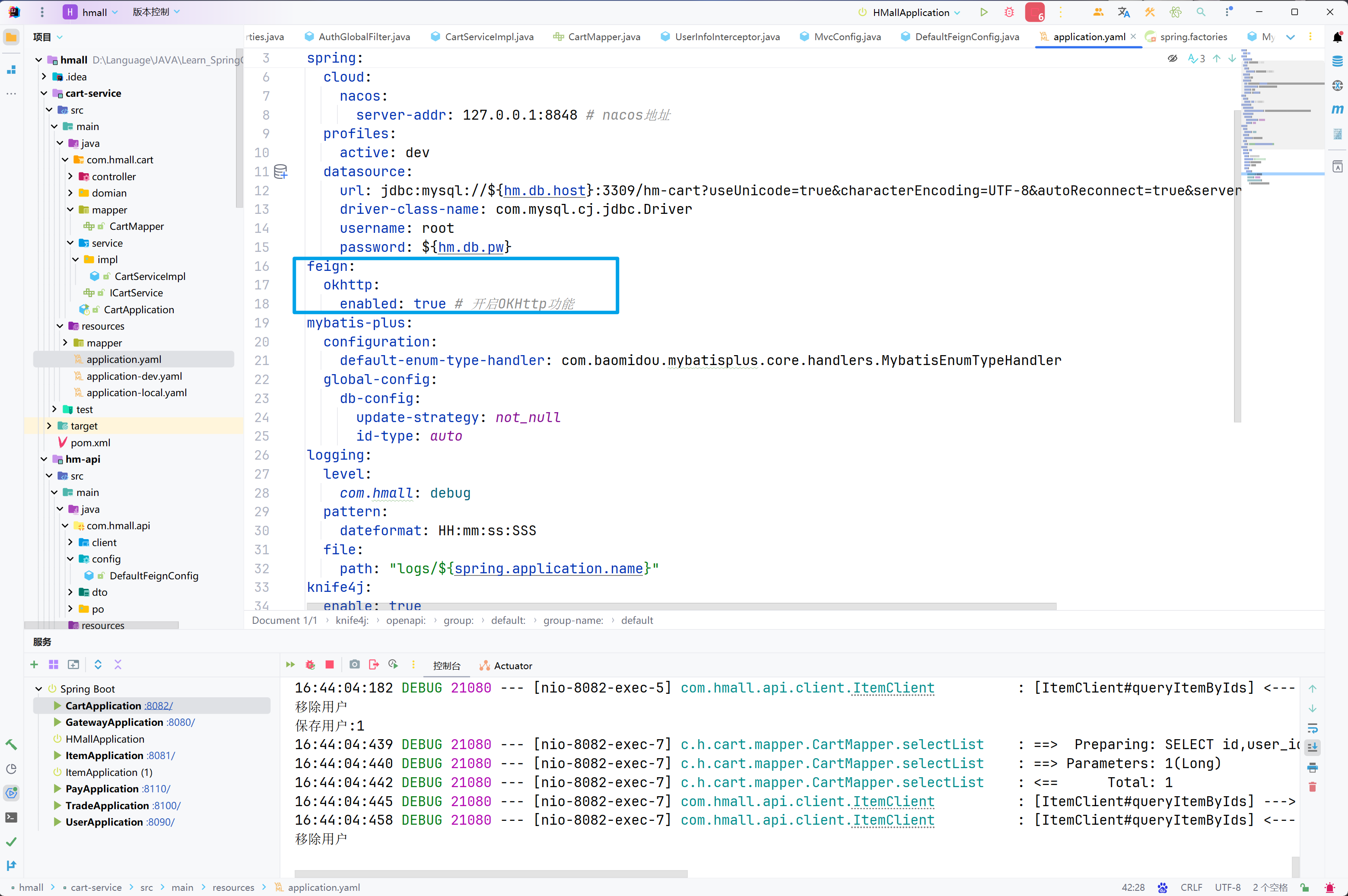

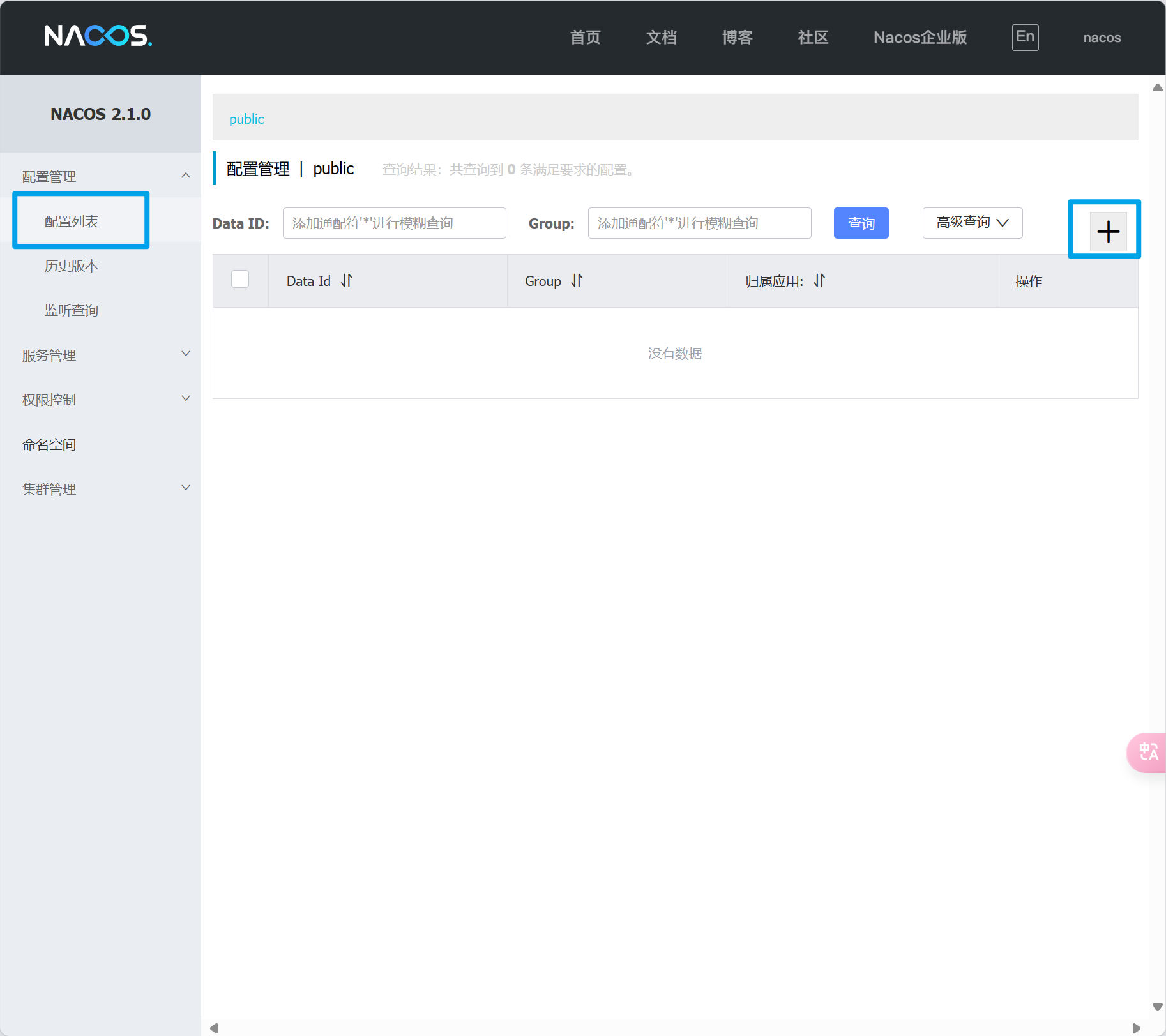

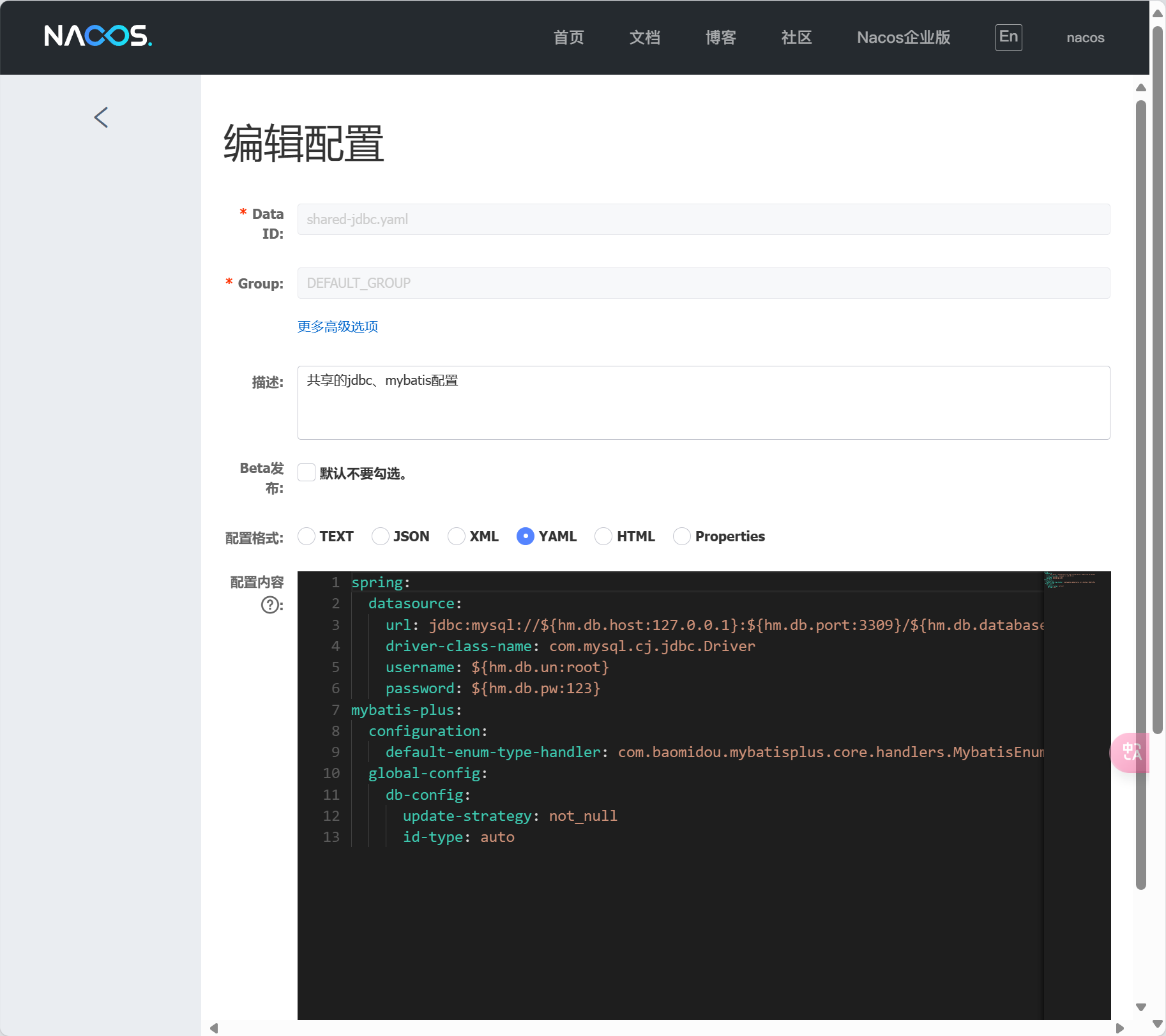

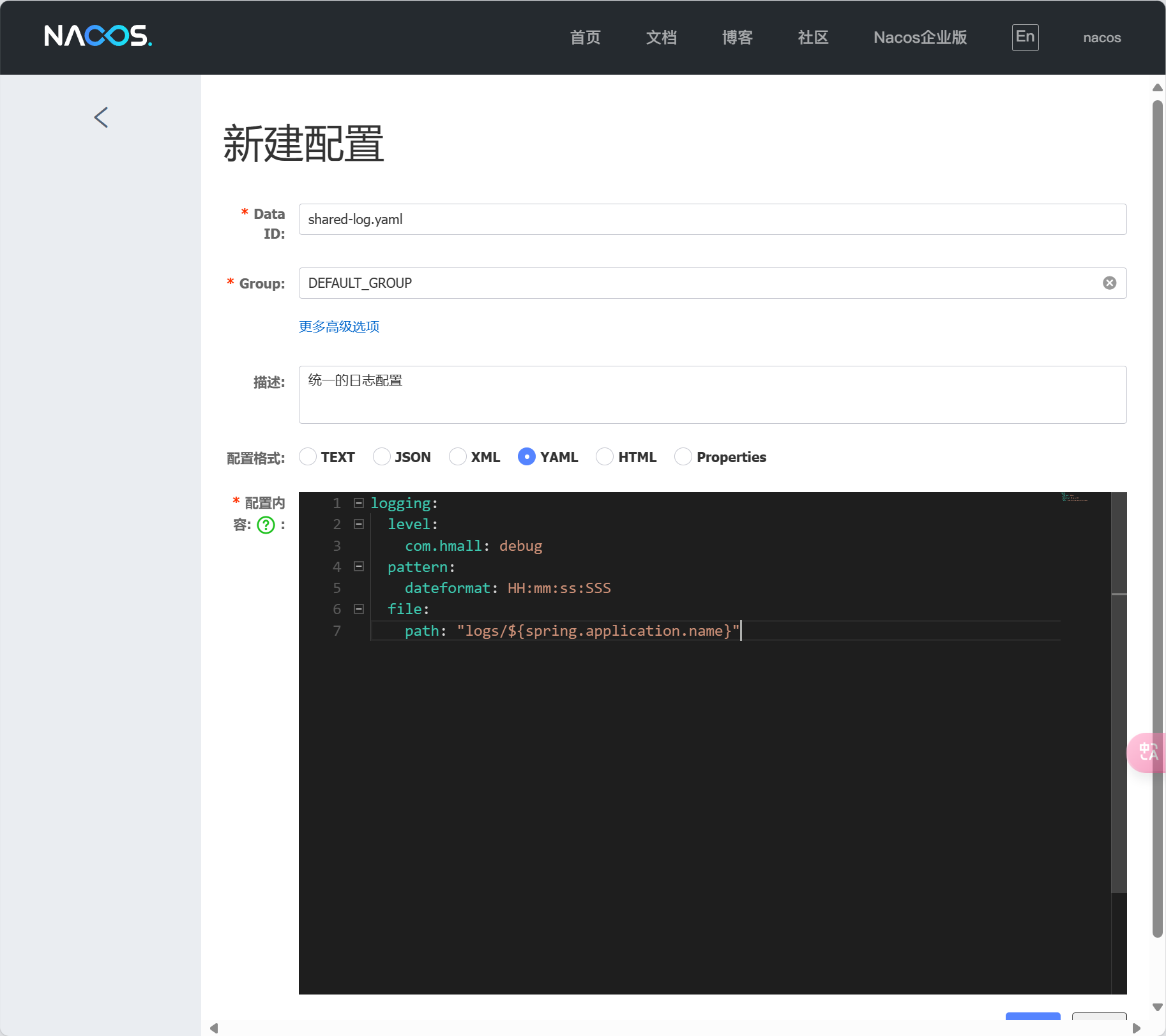

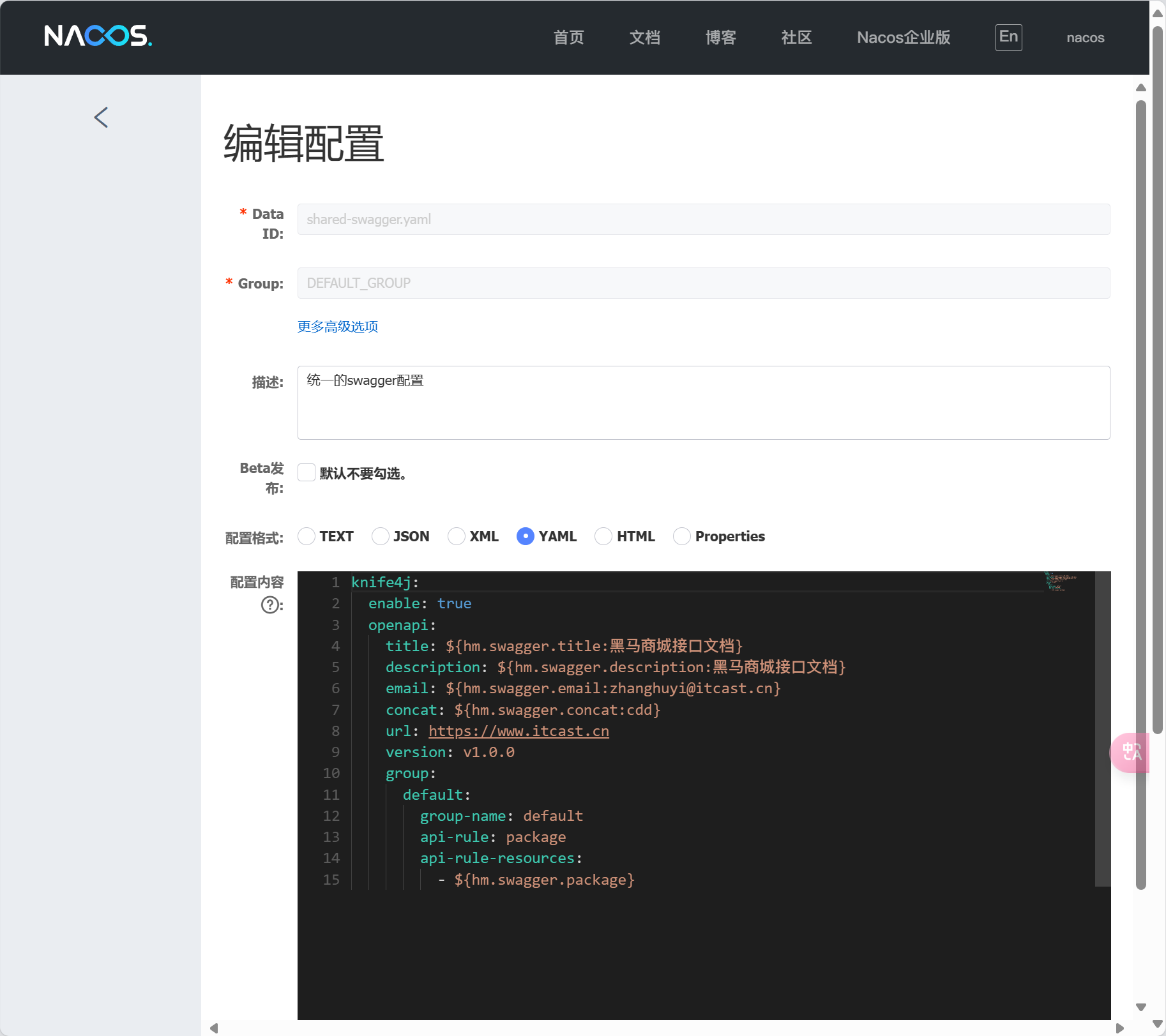

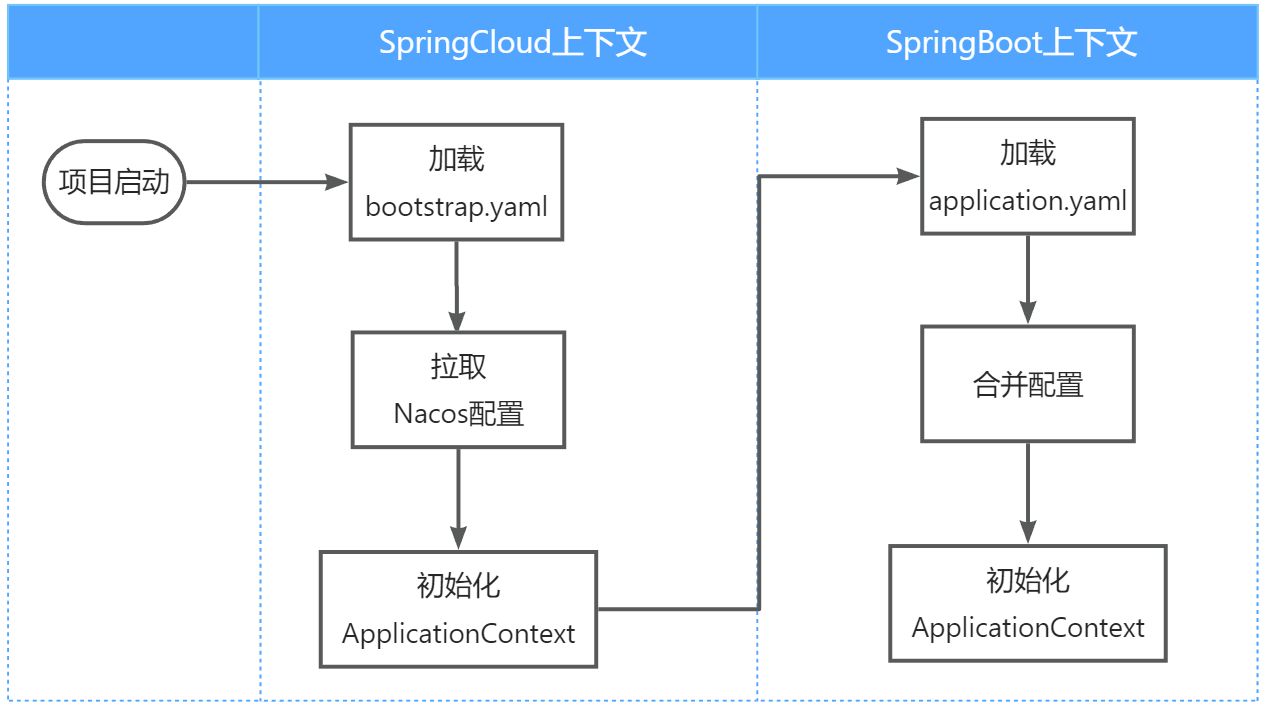

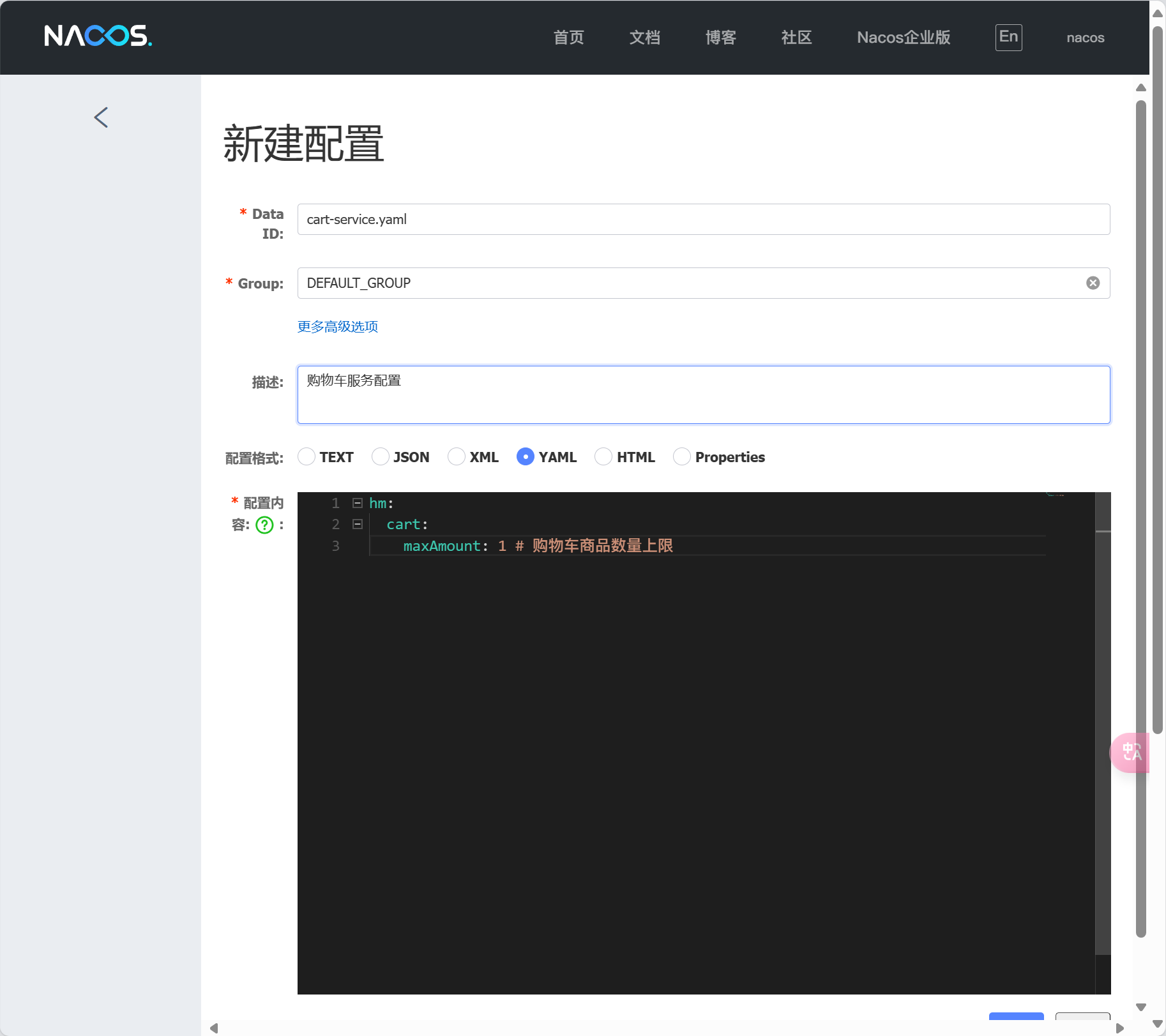

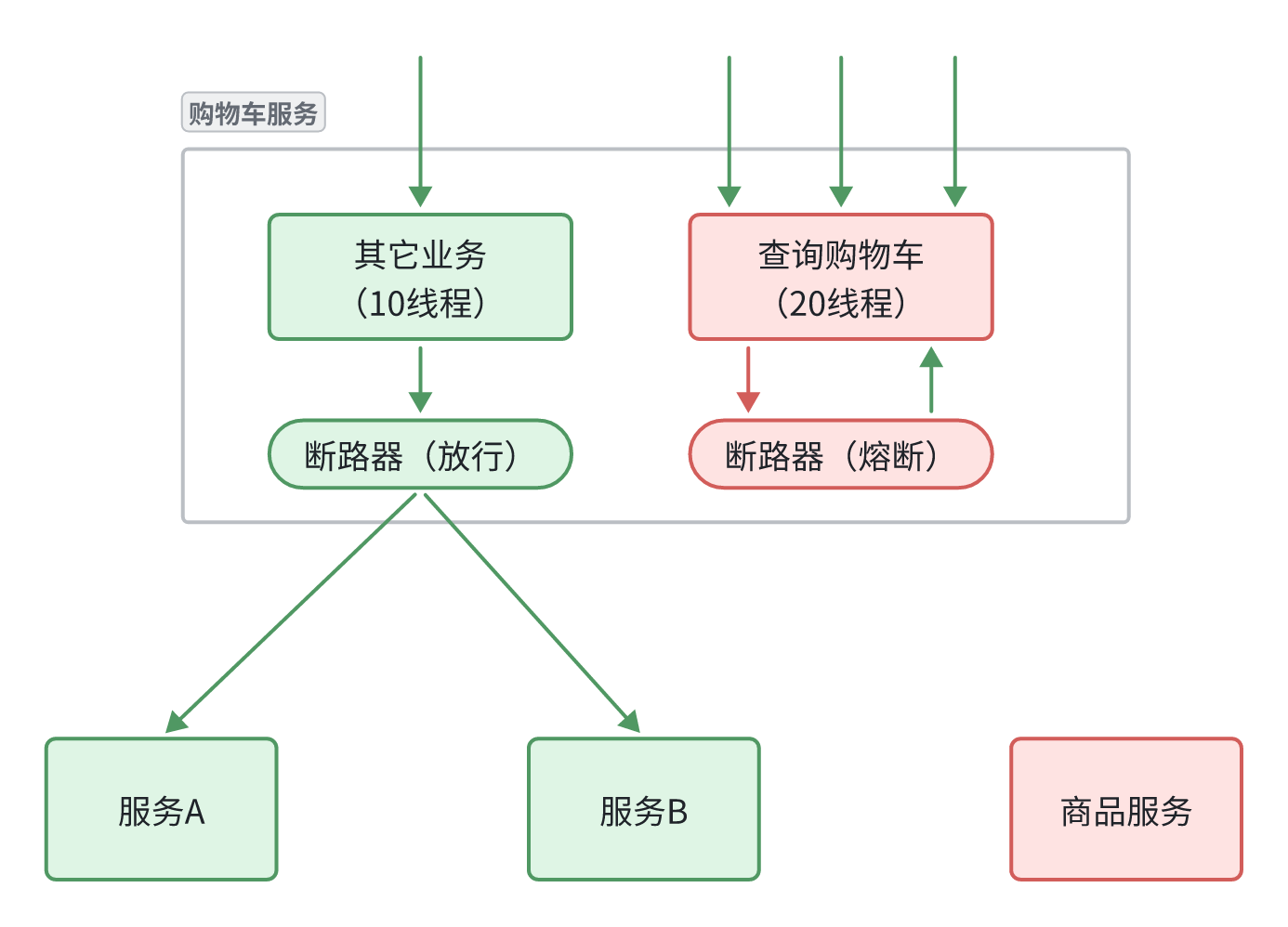

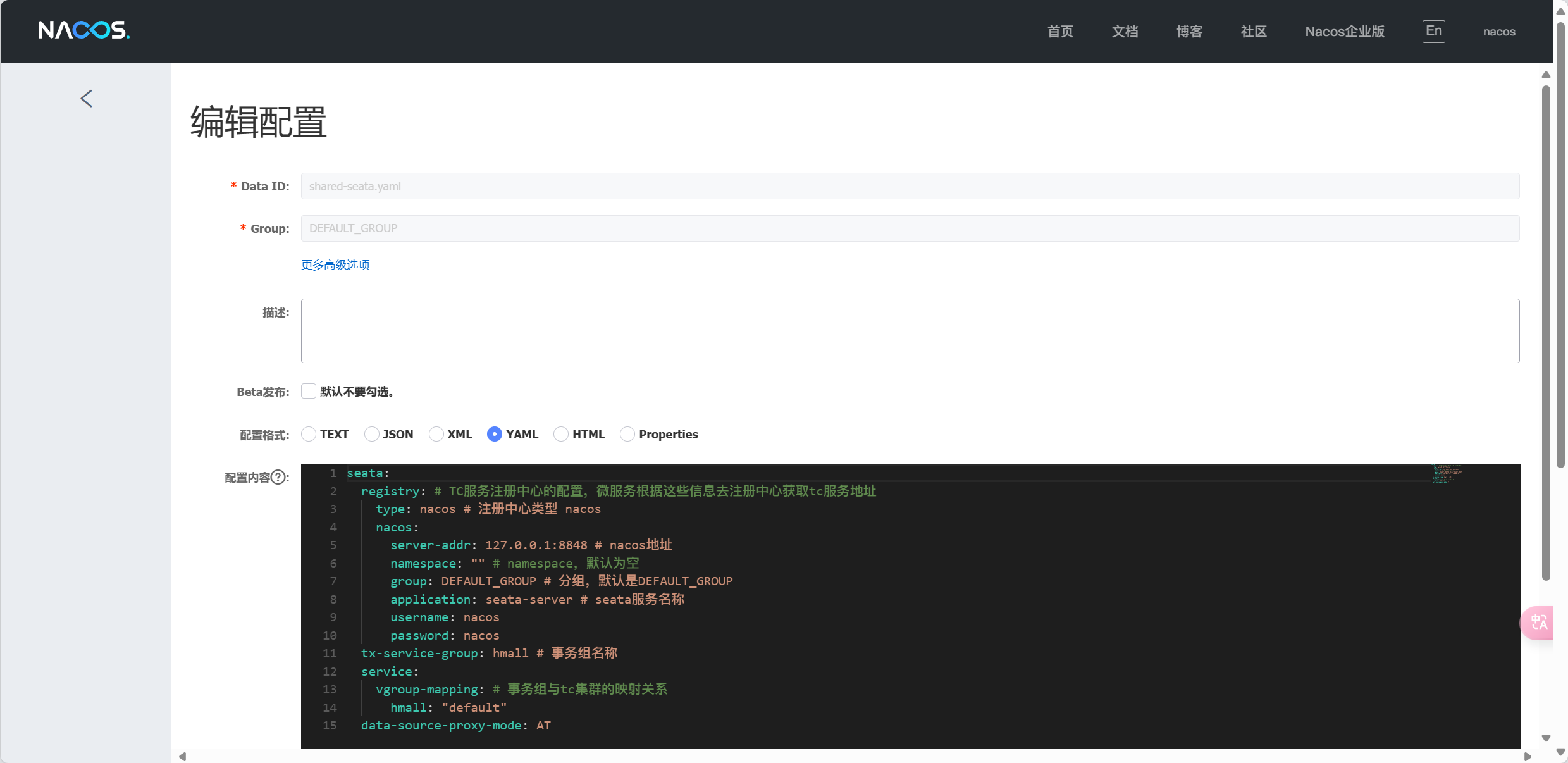

@FeignClient("item-service")